本文提出了一种参数高效的微调方法–AdaLoRA,它根据重要性评分自适应地分配参数预算。在AdaLoRA中,以奇异值分解的形式对权重矩阵的增量更新进行参数化。然后,根据新的重要性指标,通过操纵奇异值,在增量矩阵之间动态地分配参数预算。这种方法有效地提高了模型性能和参数效率。我们对自然语言处理、问题回答和自然语言生成任务进行了广泛的实验。结果表明,AdaLoRA的性能优于现有的方法。

Adaptive Budget Allocation for Parameter-Efficient Fine-Tuning

Qingru Zhang, Minshuo Chen, Alexander Bukharin, Pengcheng He, Yu Cheng, Weizhu Chen, Tuo Zhao

[Georgia Institute of Technology & Princeton University & Microsoft Azure AI]

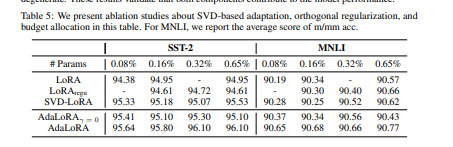

- 在下游任务中对大型预训练语言模型进行微调已经成为NLP的一个重要范式。然而,通常的做法是对预训练模型中的所有参数进行微调,当有大量的下游任务时,这种做法就变得令人望而却步。因此,许多微调方法被提出来,以参数有效的方式学习预训练权重的增量更新,例如低等级增量。这些方法通常将增量更新的预算平均分配到所有预训练的权重矩阵上,而忽略了不同权重参数的不同重要性。

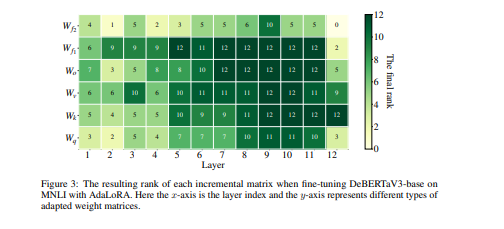

- 因此,微调性能是次优的。为了弥补这一差距,提出了AdaLoRA,它根据权重矩阵的重要性得分,在权重矩阵之间自适应地分配参数预算。特别是,AdaLoRA以奇异值分解的形式对增量更新进行参数化。这种新颖的方法使得能够有效地修剪不重要的更新的奇异值,这主要是为了减少它们的参数预算,但规避密集的精确SVD计算。

- 在自然语言处理、问题回答和自然语言生成方面用几个预训练的模型进行了广泛的实验,以验证AdaLoRA的有效性。结果表明,AdaLoRA比基线有明显的改进,特别是在低预算的情况下。

代码:https://github.com/QingruZhang/AdaLoRA

https://arxiv.org/pdf/2303.10512.pdf

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง