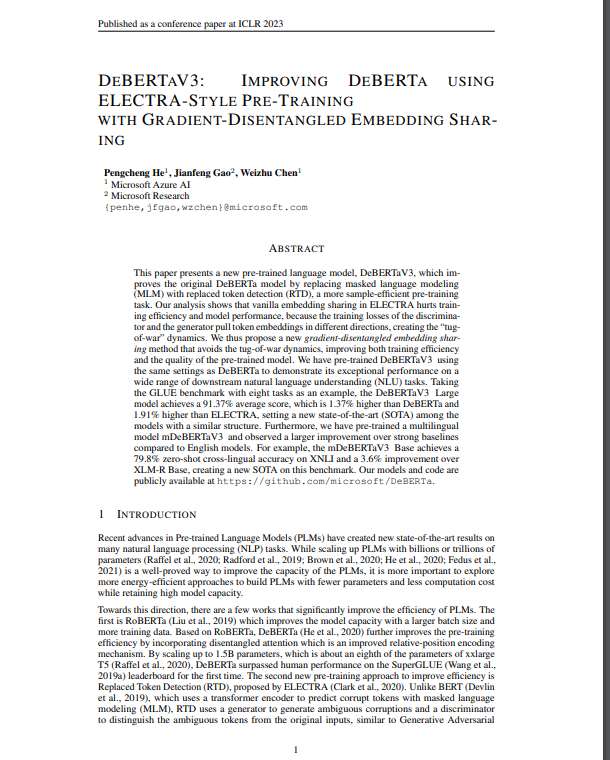

在本文中,提出了一种基于DeBERTa和ELECTRA的新型语言模型预训练范式,这两种最先进的模型分别使用相对位置编码和替换标记检测(RTD)。文章表明,由于RTD框架中生成器和判别器之间的关键干扰问题,即众所周知的 “拉锯战 “动力学,简单地将这两个模型结合起来会导致预训练的不稳定和低效率。为了解决这个问题,引入了一种新的嵌入共享范式,即GDES,这是本工作的主要创新和贡献。GDES允许鉴别器利用生成器嵌入层中编码的语义信息,而不干扰生成器的梯度。生成器的梯度,从而提高预训练的效率。GDES定义了一种新的方式 在RTD框架中的生成器和鉴别器之间共享信息的新方法,该方法可以很容易地应用于其他基于RTD的语言。可以很容易地应用于其他基于RTD的语言模型。

DeBERTaV3: Improving DeBERTa using ELECTRA-Style Pre-Training with Gradient-Disentangled Embedding Sharing

Pengcheng He, Jianfeng Gao, Weizhu Chen

[Microsoft research]

- 本文提出了一种新的预训练语言模型–NewModel,它通过用替换标记检测(RTD)代替掩码语言建模(MLM),改进了原有的DeBERTa模型,这是一项更有样本效率的预训练任务。

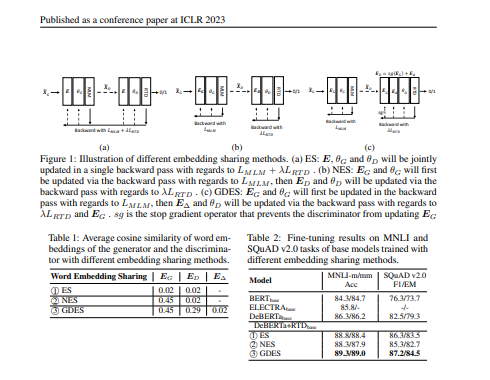

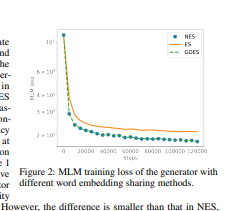

- 分析表明,ELECTRA中的香草嵌入共享损害了训练效率和模型性能。这是因为鉴别器和生成器的训练损失将令牌嵌入拉向不同的方向,形成了 “拉锯战 “的动态。因此,提出了一种新的梯度分解嵌入共享方法,避免了拉锯战的动态,提高了训练效率和预训练模型的质量。

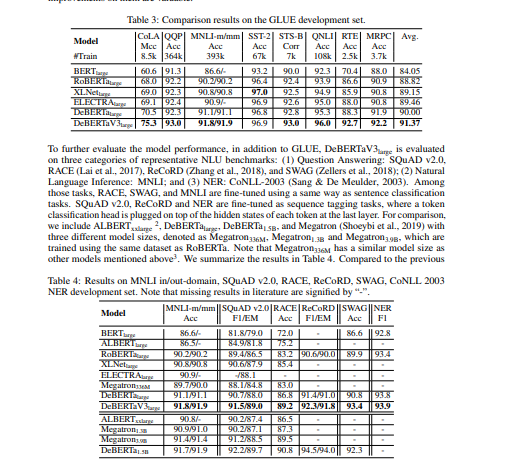

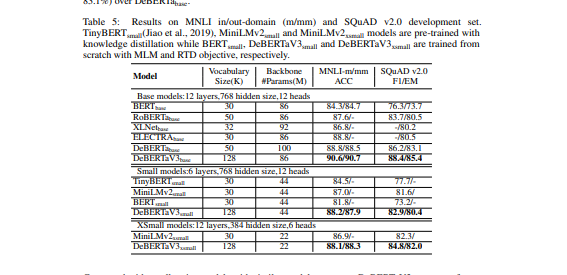

- 使用与DeBERTa相同的设置对NewModel进行了预训练,以证明其在广泛的下游自然语言理解(NLU)任务上的卓越表现。

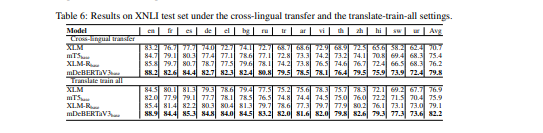

- 以有八个任务的GLUE基准为例,NewModel大型模型取得了91.37%的平均得分,比DeBERTa高出1.37%,比ELECTRA高出1.91%,在具有类似结构的模型中创造了新的最先进水平(SOTA)。此外,我们预先训练了一个多语言模型mNew-Model,并观察到与英语模型相比,比强基线有更大的改进。例如,mNewModel基线在XNLI上实现了79.8%的零次跨语言准确性,比XLM-R基线提高了3.6%,在这个基准上创造了新的SOTA。

代码地址:https://github.com/microsoft/DeBERTa

论文地址:https://openreview.net/pdf?id=sE7-XhLxHA

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง