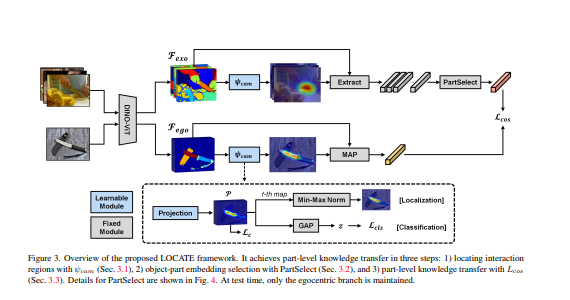

在本文中,提出了一个名为LOCATE的框架,通过观察人与物的交互图像来解决弱监督的承受力定位任务。具体来说,首先定位了外中心交互的发生地点,然后设计了一个名为PartSelect的模块,从交互区域中挑选出特定的承受力信息。最后,将学到的知识转移到以自我为中心的视图中,只用图像级别的承受力标签就可以进行承受力定位。

LOCATE: Localize and Transfer Object Parts for Weakly Supervised Affordance Grounding

Gen Li, Varun Jampani, Deqing Sun, Laura Sevilla-Lara

[University of Edinburgh & Google Research]

- 人类擅长于通过观察来获取知识。例如,可以通过观看演示来学习使用新工具。这种技能是智能系统与世界互动的基础。获得这种技能的一个关键步骤是识别物体的哪一部分为每个动作提供了条件,这被称为承受力基础。

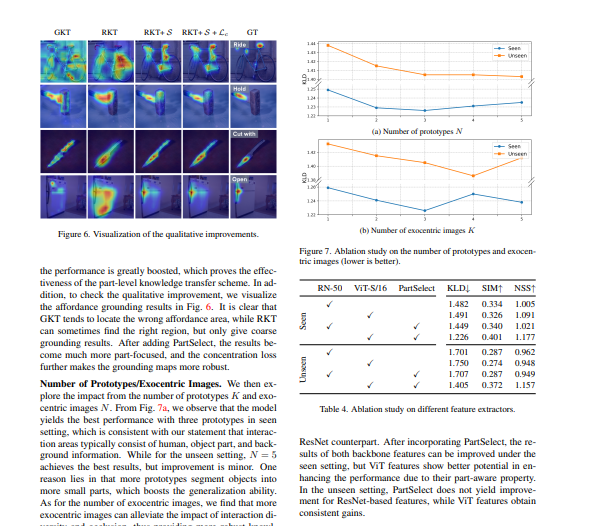

- 在本文中,解决了这个问题,并提出了一个叫做LOCATE的框架,它可以在不同的图像中识别匹配的物体部分,将知识从正在使用物体的图像(用于学习的外中心图像)转移到物体不活动的图像(用于测试的自我中心图像)。为此,我们首先找到交互区域并提取其特征嵌入。然后,学习将这些嵌入聚合成紧凑的原型(人、物体部分和背景),并选择一个代表物体部分的原型。最后,使用所选的原型来指导负担能力的建立。论文以一种弱监督的方式来做这件事,只从图像层面的承受力和物体标签中学习。

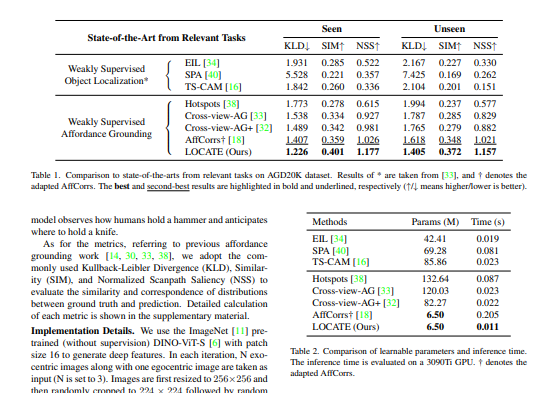

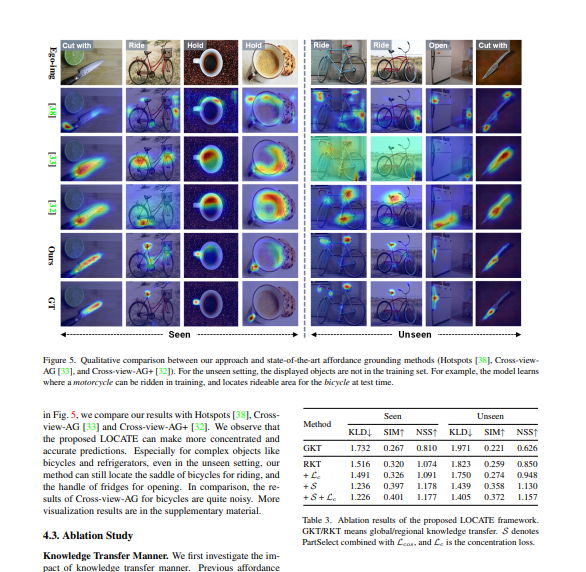

- 大量的实验表明,该方法在已见和未见的物体上都比最先进的方法有很大的优势。

https://arxiv.org/pdf/2303.09665.pdf

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง