在北京时间3月21日23点举行的GTC 2023的首日主题演讲上,英伟达的创始人黄仁勋发表演讲:如何将人工智能模型应用到芯片设计制造领域,将硅材料的工艺向着1nm的理论极限推进。

而这一切得以实现的原因,来自黄仁勋口中一个全新的名字——NVIDIA cuLitho。

NVIDIA Hopper的“光刻机说明书”来了

2022年的GTC上,英伟达带来了全新的GPU架构NVIDIA Hopper,同时推出了首个基于Hopper架构打造的产品NVIDIA H100。一年的时间里,H100已经成为各大科技训练人工智能模型使用最多的GPU之一。

一年后,黄仁勋再次站到GTC的主舞台上,这一次他带来了NVIDIA cuLitho,这是一套可以集成在NVIDIA Hopper架构中的光刻库,它可以帮助GPU提高在芯片制造场景中的工作效率。你甚至可以称其为NVIDIA Hopper的“说明书”。

黄仁勋在GTC的演讲中宣布英伟达目前已经和AMSL、台积电(TSMC)以及新思科技 (Synopsys)建立了合作关系,ASML计划将搭载了NVIDIA cuLitho软件库的NVIDIA Hopper GPU集成在他们所生产的光刻机设备中去。

按照英伟达的预估,使用NVIDIA cuLitho软件库加上NVIDIA Hopper GPU替代目前光刻机上使用的CPU,整体的效率可以提升40倍左右,减少目前每年消耗数百亿CPU小时的大量计算工作负载。

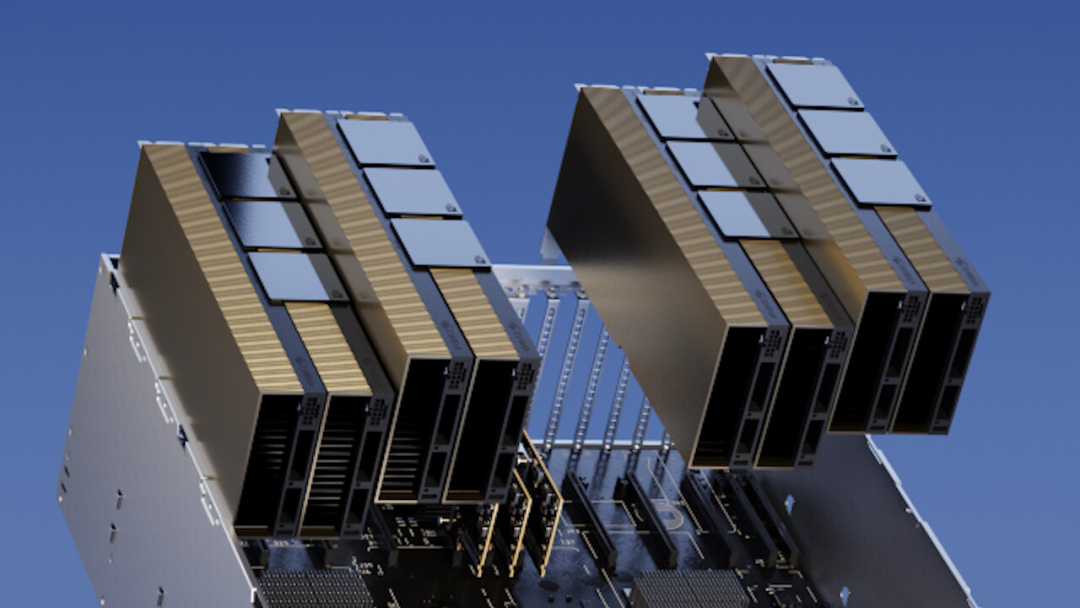

而在芯片的光刻过程中,500个NVIDIA DGX H100组成的系统能够全面覆盖当下40000个CPU服务器相当的工作量,这意味着英伟达提供的这套技术,可以有效的减少能源的消耗和碳排放。

在集成了cuLitho软件库之后,晶圆厂每天生产掩模的速度相比当下提升了3-5倍,使用的功率比当前减少了9倍,这对于晶圆厂未来的发展至关重要。

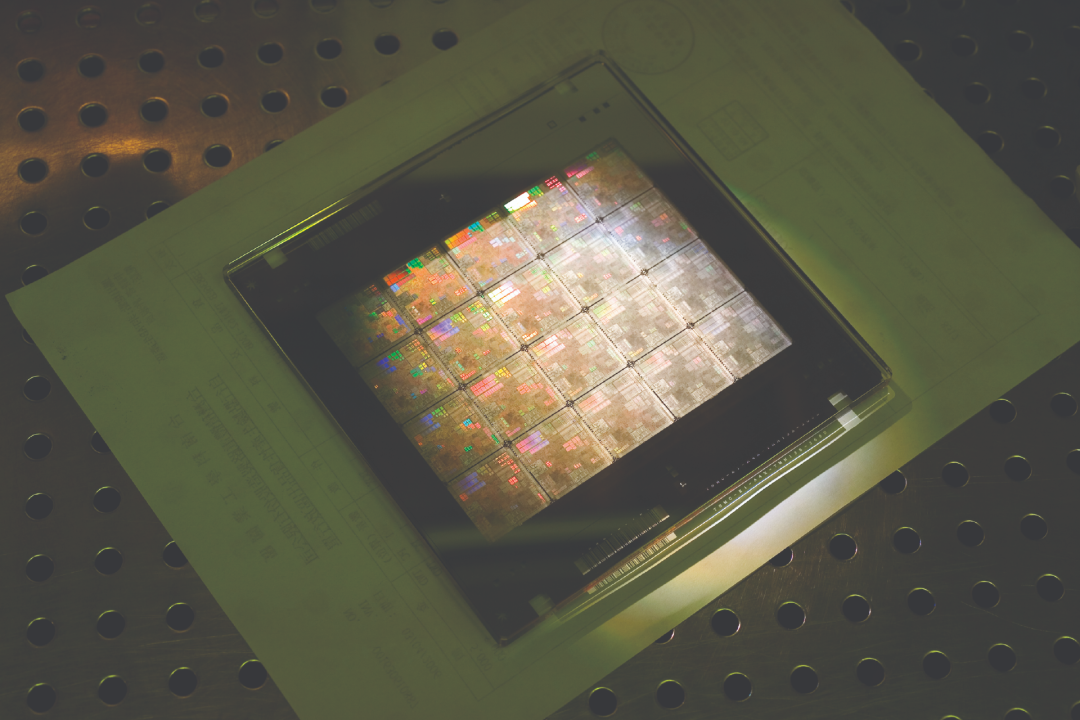

在过去的几年时间里,晶圆厂的高端芯片工艺,由4-5nm向3nm突破的难度越来越高,从台积电和三星的3nm工艺技术演进来看,半导体制造业中最大工作量所需的计算时间成本已经超过了摩尔定律,这是由于新工艺节点中晶体管数量更多和精度要求更严格带来的结果。

未来在2nm甚至1nm的工艺节点上需要更庞大的计算量,但并不是所有的计算都能合理地适应当前平台提供的可用计算带宽,这直接减慢了半导体向着硅材料工艺物理极限前进的步伐。

cuLitho相比当下设备更高的效率和更低的能耗,这意味着原本需要更长时间的硅材料工艺设计可以以比之前更快的速度突破3nm,向着更加极限的2nm推进。

我们正处于人工智能的iPhone时代

“我们正处于人工智能的iPhone时代”,这句话是在黄仁勋宣布英伟达发布NVIDIA DGX Cloud人工智能云服务时说的,而它也可能会成为整个2023年人工智能市场的缩影。

NVIDIA DGX Cloud是一项人工智能超级计算服务,它可以让企业快速访问为生成式人工智能和其他开创性应用训练高级模型所需的基础设施和软件。DGX Cloud提供NVIDIA DGX AI超级计算专用集群,黄仁勋在大会宣布DGX H100人工智能超级计算机全面投产。

每个DGX Cloud中都集成了8个NVIDIA H100或A100 80GB Tensor Core(张量计算核心)的GPU,每个节点合计有640GB的GPU,这个巨大的GPU可以满足高级AI训练的性能要求。

而基于NVIDIA DGX Cloud提供的强大的算力基础,英伟达也基于此开发了一系列的应用模型,这些模型为特定领域的任务创建,通过专有的数据进行训练。英伟达在发布会上宣布了一个全新的NVIDIA AI Foundations模型,涵盖NVIDIA NeMo语言和NVIDIA Picasso图像、视频和3D等服务。

黄仁勋在介绍NVIDIA AI Foundations模型时表示,NeMo和Picasso服务会在NVIDIA DGX Cloud上运行,可以通过浏览器访问。开发人员可以通过API接口调用每项服务。

一旦模型部署完成,就可以使用NVIDIA AI Foundations模型在云服务上实现大规模的运算负载作业。每项云服务都包括六个要素:预训练模型、数据处理框架、矢量数据库和个性化、优化推理引擎、API,以及来自NVIDIA专家的支持,以帮助企业实现自定义模型的优化工作。

另外一个基于云服务的服务称为NVIDIA Picasso,这是一个可用于构建和部署生成式人工智能图像、视频和3D应用程序,具有从文本到图像、文本到视频和文本到3D动画的功能。英伟达在主题演讲中披露,他们将和Adobe扩大长期的合作关系,将创建下一代具有商业落地前景的生成式AI模型,而这套模型将由Adobe Creative Cloud和NVIDIA Picasso共同开发完成。

Nvidia已经想好了为ChatGPT做什么

当下大火的AI大语言模型,也没有逃过Nvidia的“技术黑魔法”的覆盖圈,在此次GTC 2023上,黄仁勋掏出了一个巨大的专门用于训练大型语言模型(LLM)的GPU——H100 NVL。

这是一个基于去年英伟达发布的H100的改进版本,它将两个H100 GPU通过NVLink拼接在一起,支持188 GB HBM3内存。卡名称中的“NVL”代表 NVLink,它通过外部接口(桥接器)以600 GB/s的速度连接两张H100。

但实际上如果在技术条件允许的前提下,通过NVLink协议可以将至多256 个H100连接在一起。

当然,这不是一个消费级的GPU产品,黄仁勋在主题演讲中明确表示,H100 NVL的推出,是为了服务于大型语言模型的服务提供商,这个专用的GPU计划于下半年推出。

除了H100 NVL之外,英伟达还发布了L4 GPU,这个GPU专门用于为AI生成视频提供硬件支持。英伟达表示,它处理AI生成视频的能力是CPU的120倍,能效提高了99%。

除了生成AI视频外,英伟达称这个GPU具有视频解码和转码的能力,可用于增强现实这样的细分场景。Google Cloud将会是首批集成L4的公司之一。谷歌计划在今天晚些时候通过其Vertex AI平台向客户提供L4的服务。

去年发布的超级CPU,一年后见到了实物

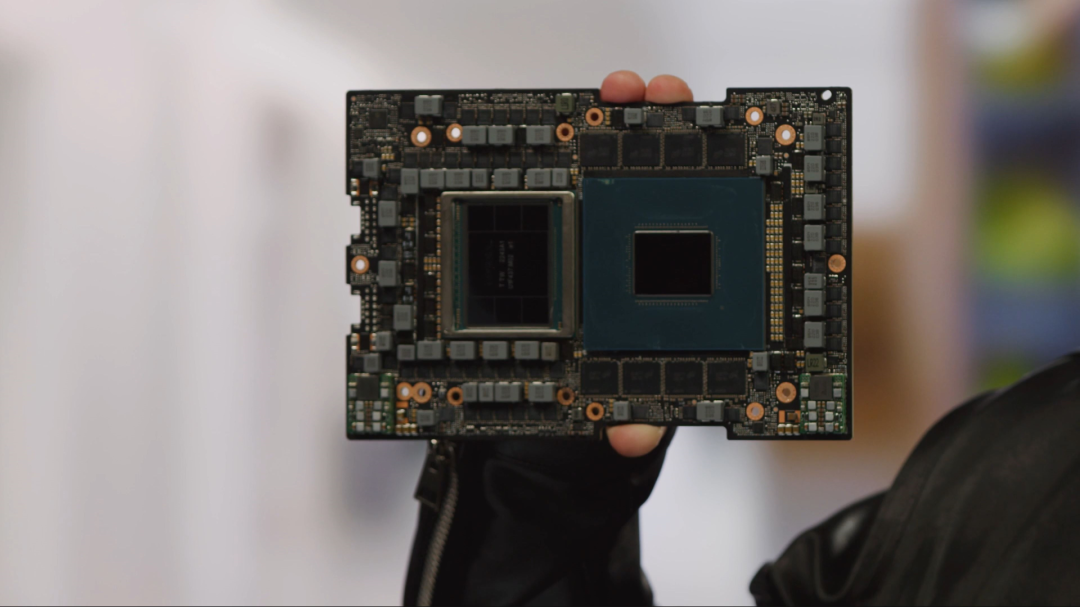

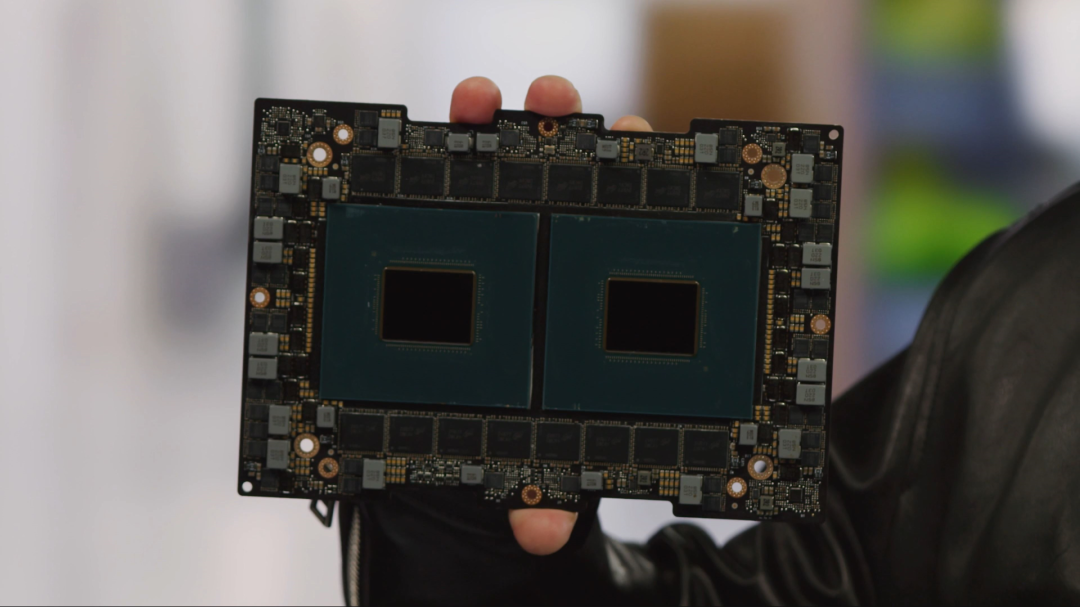

去年在GTC 2022上,英伟达发布了首款用于数据中心的CPU架构“Grace”,以及已经上市的高性能计算GPU架构“Hopper”。而基于这两种架构,打造了超级芯片,第一个是Grace CPU二合一,第二个是Grace CPU+Hopper GPU二合一。

不过这个超级芯片在过去的一年就始终没有问世,直到GTC 2023上,老黄终于揭开了它们的庐山真面目。

他展示了Grace CPU+Hopper GPU的二合一超级芯片,其中左侧较大的芯片是GPU,右侧较小的是CPU。黄仁勋透露CPU、GPU之间的通信带宽是传统PCIe总线的10倍之多。

同时也展示超级CPU二合一,基板加芯片占据了PCB的大部分面积。封装好的计算模组也一同亮相,长宽尺寸为8×5英寸,两个一组可以放入1U风冷服务器机架。

黄仁勋称,Grace相比传统x86 CPU,性能可领先30%,能效可领先70%,数据中心吞吐能力可领先1倍。Grace CPU目前已经出样,合作伙伴正在设计系统方案。但两款超级芯片的上市时间都没有明确信息。

小型的RTX 4000显卡发布,但跟游戏没任何关系

除了算力恐怖的GPU门,英伟达在此次GTC上也发布了一个小型的RTX 4000显卡,官方称之为RTX 4000 SFF,它使用了Ada Lovelace架构,整体的封装尺寸比目前市售的RTX4000系列显卡都要更小。

这块显卡并不是为了游戏玩家设计的,因此它并没有针对个人用户做进一步的优化。英伟达声称这块RTX 4000 SFF是为小型企业打造的,旨在为计算机辅助设计 (CAD)、图形设计、AI 应用程序和软件开发提供动力。

规格方面,RTX 4000 SFF拥有20GB的GDDR6显存,160位总线,以及6144个CUDA内核、192个Tensor内核和48个光线追踪内核。这些核心规格略低于已经上市的RTX 4070 Ti。但因为这块显卡更主要的目的是为了缩减尺寸和进行更商业的图像处理工作,英伟达主动降低了它的能耗,这块卡满载的功率只有70瓦。

英伟达还为笔记本电脑创造者带来了Ada Lovelace架构,推出了包括RTX 5000在内的多款显卡。其中旗舰级的RTX 5000配备16GB GDDR6显存以及9728个CUDA 内核。

依次向下,RTX 4000和RTX 3500都配备了12GB的GDDR6显存,RTX 4000具有7424个CUDA内核,RTX 3500则有5120个CUDA内核。RTX 3000和RTX 2000,分别具有4,608和3,072个CUDA内核,两者均配备8GB GDDR6显存。

英伟达表示新的显卡是为了游戏创作者而非游戏玩家打造的,从本月起,就会陆续有第三方厂商推出搭载这些GPU的工作站产品。

此外,NVIDIA还联合Quantum Machines 推出量子级运算系统“DGX Quantum”,英伟达表示这是首个结合GPU与量子运算的系統。该加速运算的系统将NVIDIA 的 Grace Hopper 超级芯片与 CUDA Quantum 开源软体平台,以及Quantum Machines的量子处理器OPX+ 结合,使其兼具量子运算与经典运算。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง