在这项工作中,提出了Vox-E,一个新的框架,利用扩散模型的表现力,对三维物体进行文本指导的体素编辑。

Vox-E: Text-guided Voxel Editing of 3D Objects

Etai Sella, Gal Fiebelman, Peter Hedman, Hadar Averbuch-Elor

[Tel Aviv University & Google Research]

- 大规模的文字引导的扩散模型由于能够合成传达复杂视觉概念的各种图像而获得了极大的关注。这种生成能力最近被用来进行文本到三维的合成。

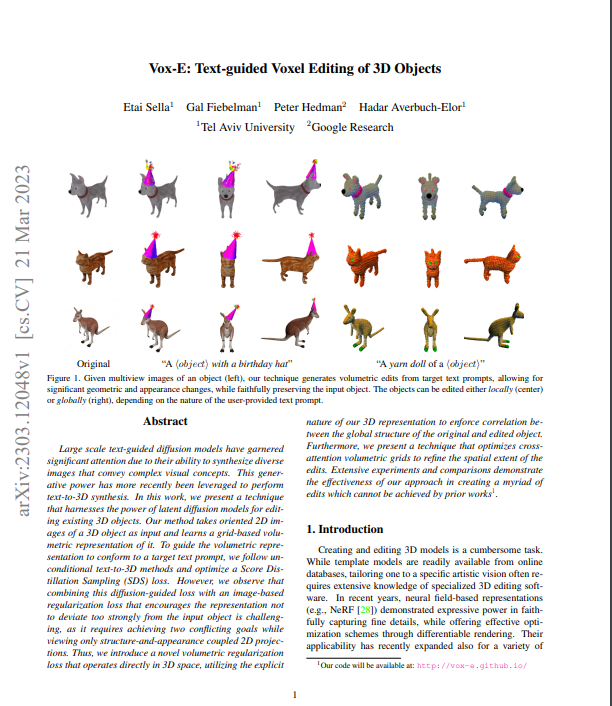

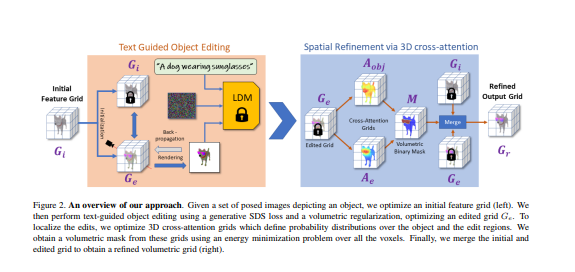

- 在这项工作中,提出了一种技术,利用潜在扩散模型的力量来编辑现有的三维物体。该方法将三维物体的定向二维图像作为输入,并学习它的基于网格的体积表示。为了引导体积表征符合目标文本提示,我们遵循无条件的文本到三维的方法,并优化得分蒸馏取样(SDS)损失。

- 然而,观察到,将这种扩散引导的损失与基于图像的正则化损失相结合,鼓励表征不要过于偏离输入对象,这是一个挑战,因为它需要实现两个相互冲突的目标,同时只查看结构和外观耦合的2D投影。因此,我们引入了一种新的体积正则化损失,它直接在三维空间运行,利用我们的三维表示的明确性质来强制执行原始和编辑对象的全球结构之间的相关性。此外,文章提出了一种优化交叉注意力的体积网格的技术,以细化编辑的空间范围。

- 广泛的实验和比较表明,我们的方法在创造无数的编辑方面是有效的,而这是先前的作品所不能实现的。

https://arxiv.org/pdf/2303.12048.pdf

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง