【推荐理由】自回归Transformer在视频生成方面取得了显著的成功。然而,由于自注意力的二次复杂度,Transformer被禁止直接学习视频中的长期依赖关系。本文所提出的Transformer实现了编码和解码的线性时间复杂度。

Towards End-to-End Generative Modeling of Long Videos with Memory-Efficient Bidirectional Transformers

Jaehoon Yoo, Semin Kim, Doyup Lee, Chiheon Kim, Seunghoon Hong

[KAIST, Kakao Brain]

【论文链接】https://arxiv.org/pdf/2303.11251.pdf

【项目链接】https://sites.google.com/view/mebt-cvpr2023

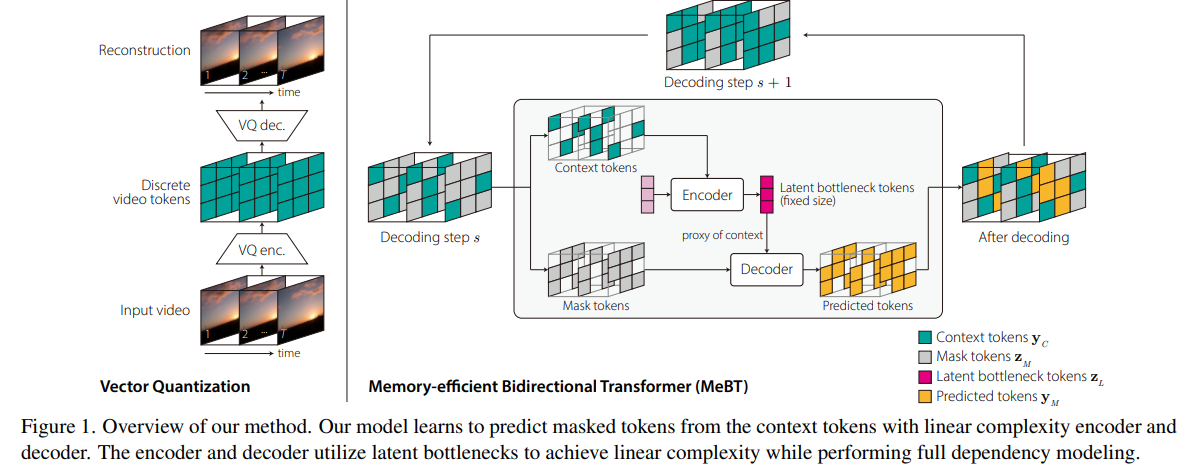

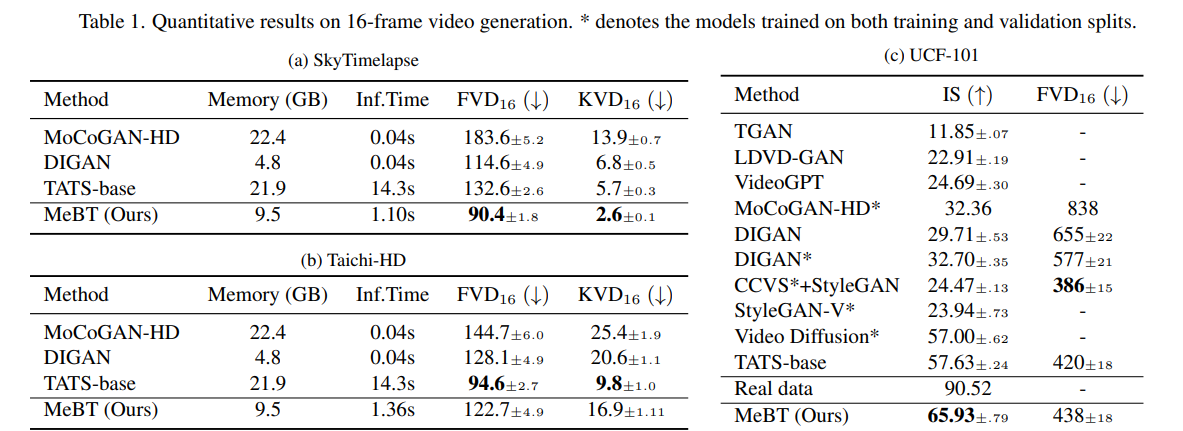

【摘要】自回归Transformer在视频生成方面表现出了非凡的成功。然而,由于自注意力的二次复杂度,Transformer被禁止直接学习视频中的长期依赖关系,同时由于自回归过程,存在慢推断时间和错误传播的问题。在本文中,我们提出了一种记忆高效的双向Transformer(MeBT),用于端到端地学习视频中的长期依赖关系并实现快速推断。基于双向Transformer的最新进展,我们的方法学习从部分观察到的补丁中并行解码整个时空体积的视频。通过将可观察上下文令牌投影到固定数量的潜在令牌中,并通过交叉注意力对其进行解码,我们的方法在编码和解码中均实现了线性时间复杂度。在双向建模和线性复杂度的支持下,我们的方法在生成中等长度视频的质量和速度方面都比自回归Transformer有了显著的改进。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง