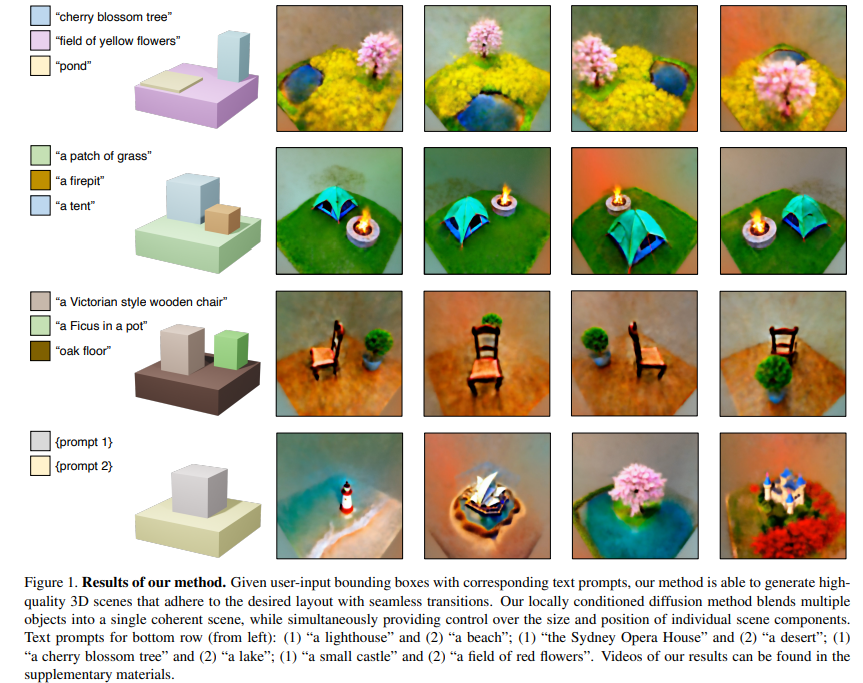

【推荐理由】本文展示了一种基于分数蒸馏采样的文本到 3D 合成流程,可以实现比相关基线更高保真度的组合式 3D 场景生成。同时,可以使用文本提示和边界框对语义部分进行控制。

Compositional 3D Scene Generation using Locally Conditioned Diffusion

[Stanford University]

【论文链接】https://arxiv.org/pdf/2303.12218.pdf

【项目链接】http://www.ryanpo.com/comp3d

【摘要】设计复杂的 3D 场景一直是一项繁琐的、需要领域专业知识的手动过程。新兴的文本到 3D 生成模型表现出使这项任务更加直观的巨大潜力,但现有的方法仅限于对象级别的生成。我们引入了本地条件扩散作为组合式场景扩散的方法,通过使用文本提示和边界框对语义部分进行控制,同时确保这些部分之间的过渡无缝。我们展示了一种基于分数蒸馏采样的文本到 3D 合成流程,可以实现比相关基线更高保真度的组合式 3D 场景生成。

关于作者Prof. Gordon Wetzstein: 谷歌学术引用量1.6w+ ,他是斯坦福计算成像实验室的负责人,也是斯坦福图像系统工程中心的教职联席主任。 在计算机图形学与视觉、人工智能、计算光学和应用视觉科学的交叉领域,Wetzstein 教授的研究在下一代成像、可穿戴计算和神经渲染系统方面具有广泛的应用。 Wetzstein 教授是 Optica 的fellow,并获得过无数奖项,包括 NSF 职业奖、Alfred P. Sloan 奖学金、ACM SIGGRAPH 重要新研究员奖、总统科学家和工程师早期职业奖 (PECASE)、 SPIE 早期职业成就奖、年度电子成像科学家奖、Alain Fournier 博士。 论文奖以及许多最佳论文和演示奖。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง