【推荐理由】以大规模图像集合为基础训练的图像扩散模型已成为最具多功能性的图像生成模型。本文研究如何利用这样的预训练图像模型进行文本引导的视频编辑。该方法无需训练,适用于各种广泛的编辑。

Pix2Video: Video Editing using Image Diffusion

Duygu Ceylan,Chun-Hao P. Huang, Niloy J. Mitra

[Adobe Research & University College London]

【论文链接】https://arxiv.org/pdf/2303.12688.pdf

【项目链接】https://duyguceylan.github.io/pix2video.github.io/

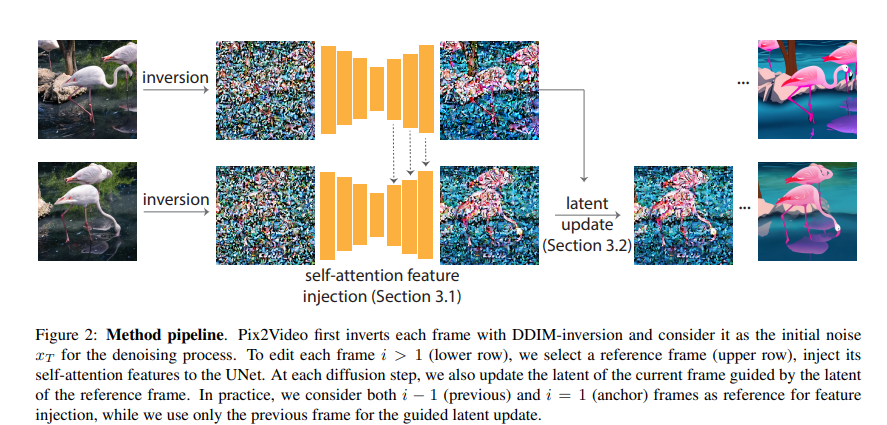

【摘要】图像扩散模型以其质量和多样性而成为最具多功能性的图像生成模型。它们支持反转真实图像和有条件的(例如文本)生成,使其成为高质量图像编辑应用程序的理想选择。本文研究如何利用这样的预训练图像模型进行文本引导的视频编辑。其中的关键挑战是在保留源视频内容的同时实现目标编辑。我们的方法通过两个简单的步骤实现:首先,使用预先训练的结构引导(例如深度)图像扩散模型对锚定帧进行文本引导编辑;然后,在关键步骤中,通过自注意力特征注入逐步将更改传播到未来帧,以适应扩散模型核心去噪步骤。然后,通过调整上一帧的潜在编码来巩固这些更改,并继续整个过程。该方法无需训练,适用于各种广泛的编辑。通过广泛的实验证明了该方法的有效性,并将其与四种不同的先前和平行努力进行了比较。作者们展示了文本引导视频编辑的实现方式,无需进行计算密集型预处理或视频特定的微调。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง