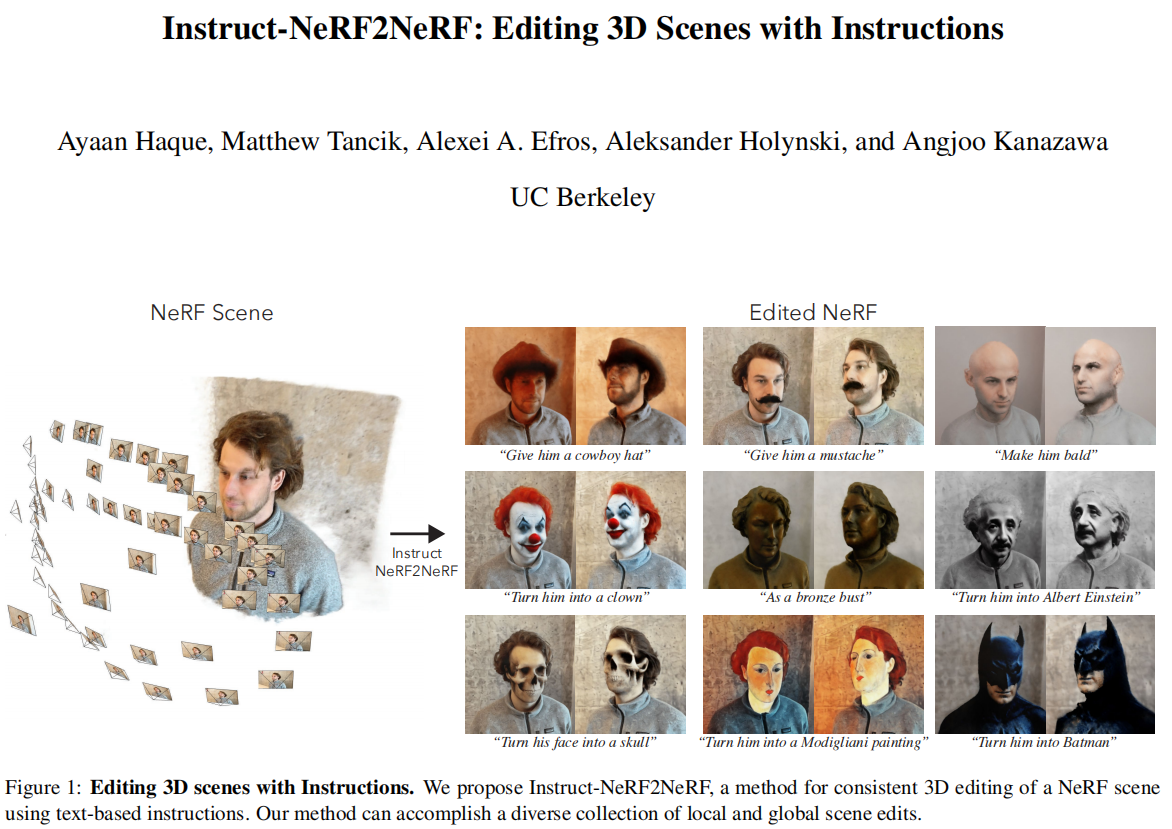

本文提出了一种用文本指令编辑NeRF场景的方法。给定场景的NeRF和用于重建它的图像集合,本文使用基于图像扩散模型(InstructPix2Pix)来迭代地编辑输入图像并优化底层场景,从而产生复合文本指令的3D场景。实验证明,Instruct-NeRF2NeRF能够编辑大规模的真实场景,并且能够完成比先前工作更真实、更有针对性的编辑。

Instruct-NeRF2NeRF通过在训练NeRF的同时迭代更新数据集图像来逐步更新重建的NeRF场景:

- 在训练图像的视角基础上渲染图像;

- 给出一个全局文本指令,将其由InstructPix2Pix编辑;

- 训练集图像被编辑后的图像替换。

- NeRF继续训练。

标题:Instruct-NeRF2NeRF: Editing 3D Scenes with Instructions

论文:https://arxiv.org/pdf/2303.12789.pdf

作者:Ayaan Haque, Matthew Tancik, Alexei A. Efros, Aleksander Holynski, Angjoo Kanazawa

平台:https://instruct-nerf2nerf.github.io/

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง