【推荐理由】本文研究了无条件合成无限自然场景的任务,实现了任意大的摄像机运动,并保持持久的3D世界模型。

Persistent Nature: A Generative Model of Unbounded 3D Worlds

Lucy Chai, Richard Tucker, Zhengqi Li, Phillip Isola, Noah Snavely

[MIT & Google Research & Cornell Tech]

【论文链接】https://arxiv.org/pdf/2303.13515.pdf

【项目链接】https://chail.github.io/persistent-nature/

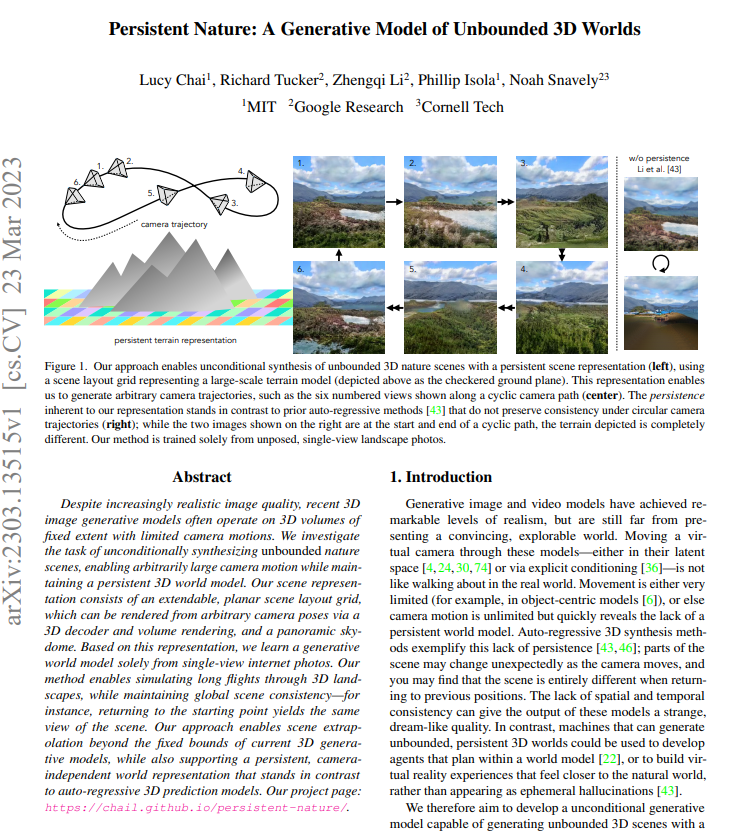

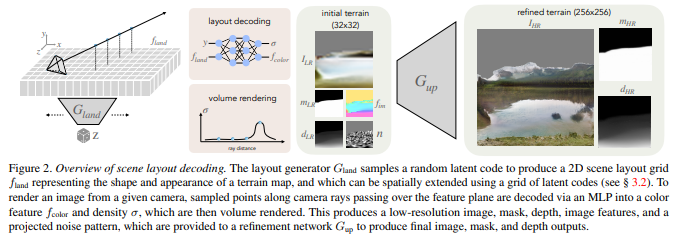

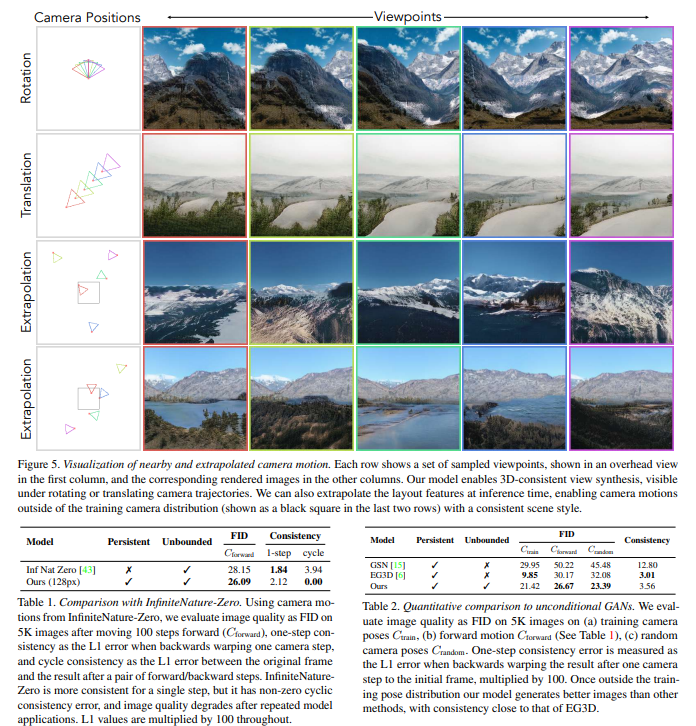

【摘要】尽管最近的3D图像生成模型的图像质量越来越逼真,但它们通常在固定范围的3D体积上运行,摄像机运动有限。我们研究了无条件合成无限自然场景的任务,实现了任意大的摄像机运动,并保持持久的3D世界模型。我们的场景表示包括可扩展的平面场景布局网格和全景天空圆顶,通过3D解码器和体积渲染可以从任意摄像机位置呈现。基于这种表示,我们仅从单视图互联网照片中学习生成世界模型。我们的方法使得可以在3D风景中模拟长时间的飞行,同时保持全局场景的一致性——例如,返回起点将产生相同的场景视图。我们的方法能够实现超越当前3D生成模型的固定范围的场景外推,并支持相对于摄像机的持续、独立的世界表示,与自回归的3D预测模型形成对比。

关于作者 Zhengqi Li:

他是Google Research的研究科学家,研究兴趣涵盖了3D/4D计算机视觉、基于图像的渲染和计算摄影,尤其是针对野外图像和视频的研究。

他在康奈尔大学获得了计算机科学博士学位,导师是Noah Snavely教授。他也是CVPR 2019最佳论文荣誉提名、2020年Google博士奖学金、2020年Adobe研究奖学金、2021年百度全球百强人工智能新锐和2023年CVPR最佳论文获得者之一。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง