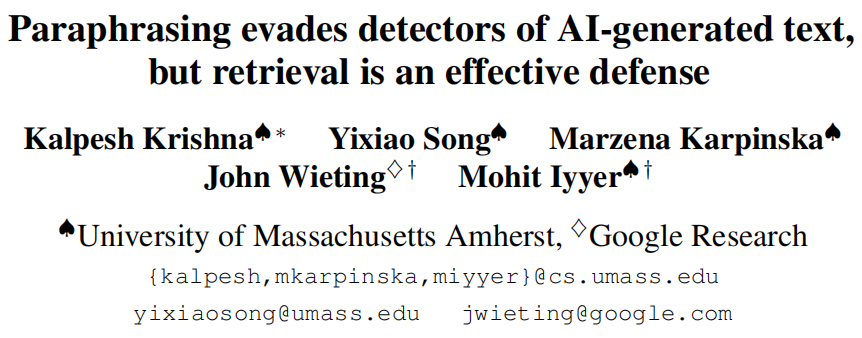

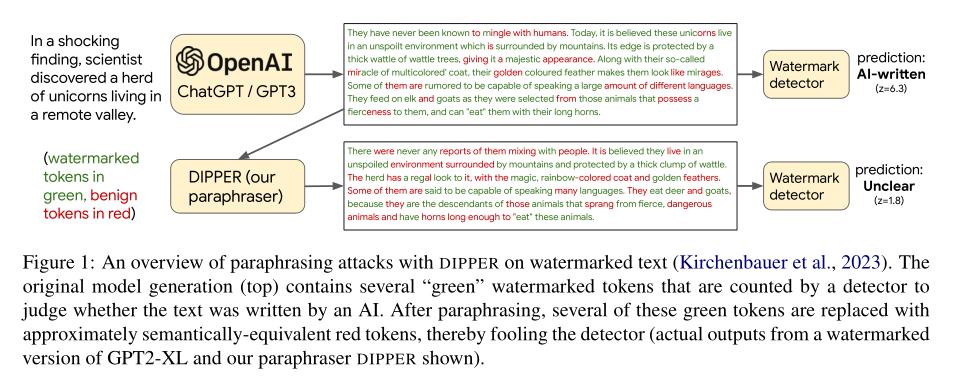

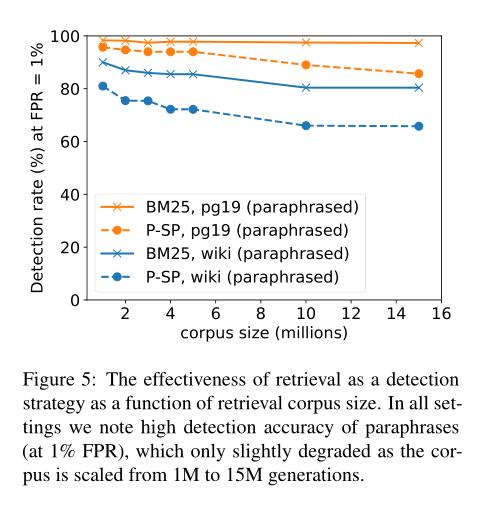

为了检测大型语言模型在恶意用途(如虚假内容创建或学术抄袭)中的部署,研究人员在近期提出了几种方法,以通过水印或统计异常来识别AI生成的文本。为了测试这些检测器,本文首先训练了一个11B参数的改写生成模型(DIPPER),可以将段落改写,也可以利用周围文本(例如用户编写的提示)作为上下文。DIPPER还使用标量旋钮来控制改写中的词汇多样性和重新排序的数量。使用DIPPER对三个大型语言模型(包括GPT3.5-davinci-003)生成的文本进行改写,可以成功逃避多个检测器,包括水印、GPTZero、DetectGPT和OpenAI的文本分类器。例如,DIPPER将DetectGPT的检测准确率从70.3%降至4.6%(在恒定的误报率为1%的情况下),而且不会明显修改输入语义。 为了提高对AI生成文本检测的抵御改写攻击的强度,本文介绍了一种简单的防御措施,依赖于检索语义相似的生成结果,并必须由语言模型API提供者维护。给定一个候选文本,本文的算法搜索先前由API生成的序列数据库,寻找在一定阈值范围内与候选文本匹配的序列。作者使用经过微调的T5-XXL模型的15M个生成序列的数据库进行实证验证,发现在不同设置下,它可以检测到80%至97%的改写生成,同时仅将1%的人工编写序列分类为AI生成。

标题:Paraphrasing evades detectors of AI-generated text, but retrieval is an effective defense

作者:Kalpesh Krishna, Yixiao Song, Marzena Karpinska, John Wieting, Mohit Iyyer

论文:https://papers.labml.ai/api/v1/redirect/pdf?paper_key=2cfe8cecc9f211edb95839eec3084ddd

代码:https://github.com/martiansideofthemoon/ai-detection-paraphrases

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง