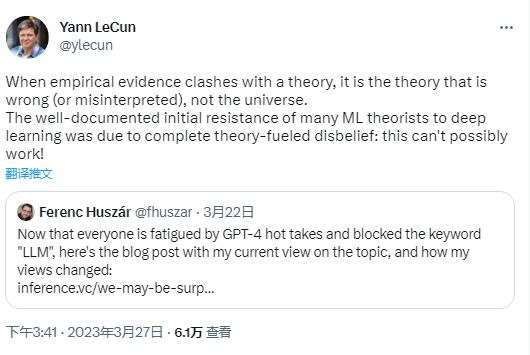

针对近期大火的大语言模型,学术界和工业界近期的观点仍然不一,针对这一问题,LeCun再次阐述自己的观点:

当实证证据与理论相冲突时,是理论错误(或被误解),而不是宇宙错误。许多机器学习理论家一开始对深度学习的抵抗完全是基于理论上的怀疑:这不可能行得通!

我们可能会再次感到惊讶:为什么我认真对待预训练语言模型?

在我2016年的一篇早期博客文章中,我宣称:”深度学习很简单,去学点更难的东西。”尽管观察有些公正,但现在我可以说,这篇文章是证明我明显低估了简单技术的影响力,并可能给出了反效果的建议。

我并不是唯一一个怀疑深度学习的人,事实上,我远远不是最极端的深度学习怀疑论者。我们中的许多人在贝叶斯机器学习、凸优化、核和统计学习理论中成长,自信地预测深度学习的不可避免的失败,并继续声称,深度网络只是在记忆训练数据,忽略了相反的证据。

这背后的原因是什么?除了早期DL的无趣充满hackiness之外,另一个重要原因是我们误用了统计学习理论中一些关键工作的一些直观理解。学习理论(如Vapnik-Chervonenkis或Rademacher范围的知名发现)的许多结果保证了当模型类足够小时的一般化。我们很多人在不正式理解这些结果的情况下,把它们误用成了”除非你的模型类简单,否则你无法进行泛化。”和深度学习是一个简单的模型类的想法相反。 Ergo,它不会/不能工作。因此,任何相反的证据都被当作挑选樱桃、随机种子黑客或过度拟合等成功的装饰而被驳回。

需要明确的是,尤其是在RL中,存在许多缺乏动机或难以再现的研究,因此一些怀疑是有根据的。为缓解怀疑,我仍然认为理论上有动机的怀疑是一件好事,而严谨性——这是早期深度学习所缺乏的——也很重要。但是,深度学习的某些方面显然不仅仅是过度拟合成功的装饰,我们中的许多人对这个普遍观点坚持了太久。

是什么改变了这种情况?在许多人的态度中,一个重要的转折点是2016年的一篇论文《理解深度学习需要重新思考泛化》。我对这篇论文的记忆方式是这样的:”深度网络具有最大Rademacher复杂性,因此,泛化理论预测深度学习不应该工作,但很明显它确实工作了,因此我们的理论是不够的。”现在看来,这几乎是微不足道的,但当时却代表了一次巨大的转折。需要修正的是理论,而不是深度学习。它为人们提供了一个巨大的机会,可以提出新的理论,发展新的直觉。我们还远远没有达到现代深度学习理论,但我们更了解正在发挥作用的组件。

现在,我看到了类似的抵制情况,不愿认真考虑预训练的语言模型,如GPT系列。许多我同事对LLM的看法在过去几年中并没有改变。一些人认为LLMs只擅长”反刍训练数据”。我还看到了类似的滥用和过度泛化理论性的论点。

例如,因果推理领域确定了从i.i.d.观察中推断因果结构的不可能性问题。我在我的因果推理博客文章中谈到过这个问题。许多人随后过度泛化了这个重要但狭窄的发现,认为”除非你增加一些额外的因果模型,否则机器学习模型绝对不会学习因果推理”。但是,这个结果实际上和LLM是否可以(从形式上)正确地推理完整提示中的因果结构有什么关系呢?事实上,LLMs确实是适用于i.i.d.数据的统计模型。但是,无法识别性结果只在我们将其应用于学习文本中连续标记之间的因果关系时才是相关的。但那些不是我们需要的因果关系。我们希望LLM”理解”或者看起来理解踢球会导致球移动这个因果关系。这种因果关系被编码在语言中,不必从i.i.d.观察数据中推断出来。

我的本能是拒绝将预训练LLM作为被定义为通用推理机的工具进行使用。2018年,我访问了OpenAI,在那里我看到了重要的GPT-2和GPT-3结果的预览:预训练LM通过零-shot提示工程能够解决它没有明确训练过的问题。我的第一反应是这不可能。当然,你能够比机会还要强,但这种方法永远不可能与专业解决方案竞争。我很有趣地试图说明我为什么会这样想。我的想法有两种:

即使我个人对机器学习中的免费午餐定理并不感兴趣,回想起来,我对GPT的”一个模型可以完成所有任务”方法的拒绝本质。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง