“LLaMA-Adapter:具有零初始注意力的语言模型的高效微调”的正式实施。

这个 repo 提出了LLaMA-Adapter,一种用于微调指令遵循LLaMA模型的轻量级自适应方法🔥,使用Stanford Alpaca提供的 52K 数据。

代码地址:https://github.com/ZrrSkywalker/LLaMA-Adapter

概述

效率比较:

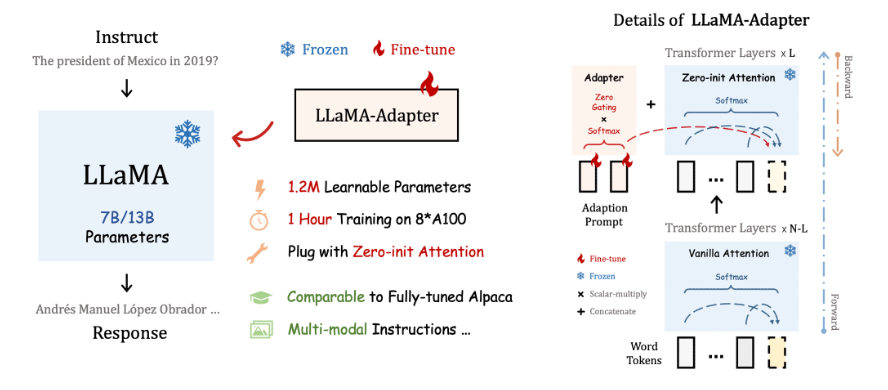

通过将适配器插入 LLaMA 的转换器,我们的方法仅引入1.2M可学习参数,并在1 小时内将 LLaMA 转换为指令跟随模型。我们提出了一种用于早期稳定训练的Zero-init Attention机制,并且可以简单地扩展到多模态输入指令,例如图像、音频和视频。经过微调后,LLaMA-Adapter 可以生成高质量的指令跟随语句,可与完全微调的Stanford Alpaca和Alpaca-Lora相媲美。

论文地址:https://arxiv.org/pdf/2303.16199.pdf

标题:LLaMA–Adapter: Efficient Fine-tuning of Language Models with Zero-init Attention

Renrui Zhang, Jiaming Han, Aojun Zhou, Xiangfei Hu, Shilin Yan, Pan Lu, Hongsheng Li, Peng Gao, Yu Qiao

[Shanghai Artificial Intelligence Laboratory & CUHK MMLab &University of California, Los Angeles]

摘要:本文提出了LLaMA-Adapter,这是一种轻量级的适应方法,可以将LLaMA有效地微调为指令跟随模型。LLaMA-Adapter使用52K个自我构造演示,在冻结的LaMA 7B模型上只引入了120万个可学习的参数,在8个A100 GPU上进行微调的成本不到1小时。具体来说,采用了一套可学习的适应性提示,并将其预置在较高转换层的输入文本标记上。然后,提出了一个具有零门控的零启动注意力机制,该机制可以自适应地将新的教学线索注入到LaMA中,同时有效地保留了其预训练的知识。通过有效的训练,LLaMA-Adapter产生了高质量的反应,与具有完全微调的7B参数的Alpaca相当。此外,我们的方法可以简单地扩展到多模态输入,例如图像,以图像为条件的LLaMA,它在ScienceQA上实现了卓越的推理能力。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง