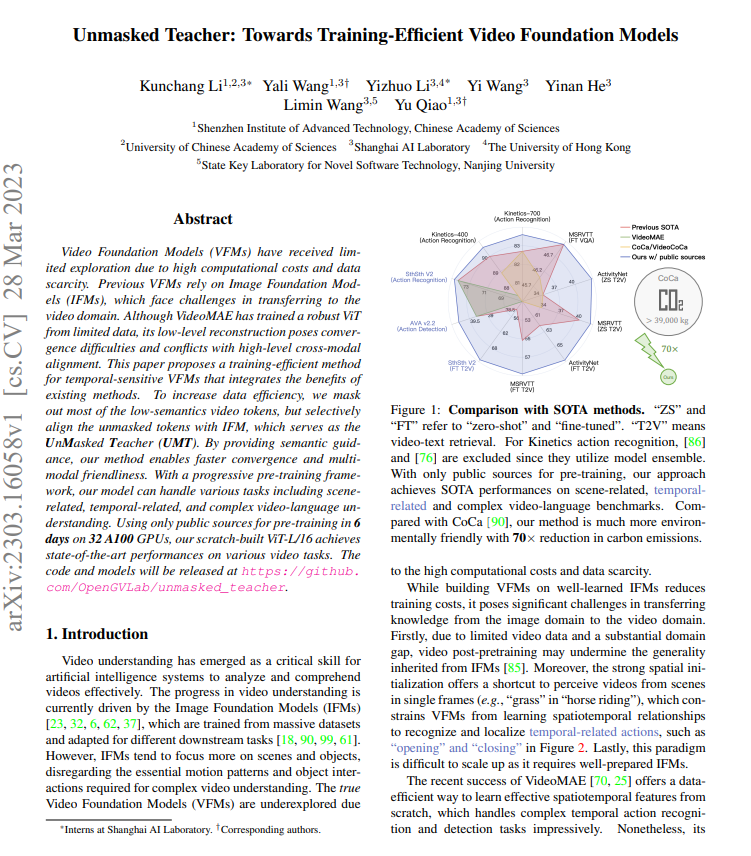

【推荐理由】本文提出了一个高效训练视觉大模型的方法,仅使用公共资源在 32 个 A100 GPU 上进行 6 天的预训练,从头构建的 ViT-L/16 在各种视频任务上实现了最先进的性能。

Unmasked Teacher: Towards Training-Efficient Video Foundation Models

Kunchang Li, Yali Wang, Yizhuo Li, Yi Wang, Yinan He, Limin Wang, Yu Qiao

[Shenzhen Institute of Advanced Technology, Chinese Academy of Sciences]

【论文链接】https://arxiv.org/pdf/2303.16058.pdf

【项目链接】https://github.com/OpenGVLab/unmasked_teacher

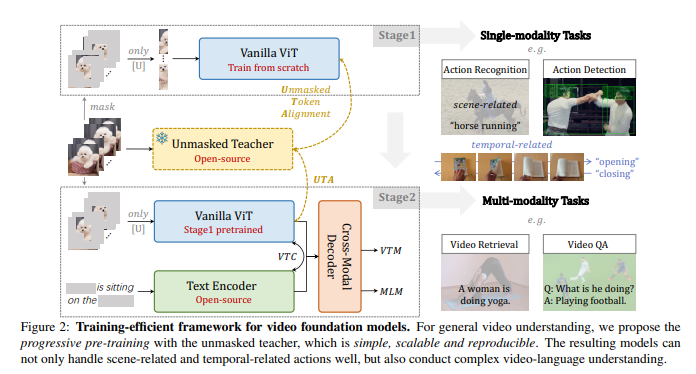

【摘要】由于计算成本高和数据稀缺,视频基础模型(VFMs)受到了有限的探索。以前的VFMs依赖于图像基础模型(IFMs),面临着转移到视频领域的挑战。虽然VideoMAE已经从有限的数据中训练出了一个强大的ViT,但其低级重建会导致收敛困难,并与高级跨模态对齐产生冲突。本文提出了一种训练高效的时间敏感VFMs方法,结合了现有方法的优势。为了增加数据效率,作者屏蔽了大部分低语义视频令牌,但是选择性地将未屏蔽的令牌与IFM对齐,IFM作为未屏蔽的教师(UMT)。通过提供语义指导,该方法使得收敛更快,同时也更加友好跨模态。通过渐进式预训练框架,此模型可以处理各种任务,包括与场景相关的、与时间相关的和复杂的视频语言理解。仅使用公共来源进行预训练,在32个A100 GPU上进行6天的零起点构建ViT-L/16,在各种视频任务上实现了最先进的性能。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง