总结:

本文介绍了一种新的方法,将预先训练的神经网络模型用作特征提取器,结合差分隐私算法实现大规模图像分类,并且保护用户隐私。实验表明,这种方法在大规模数据集上实现了优异的性能。该方法可以扩展到其他数据集和任务中,并为将差分隐私应用于深度学习提供了一种有前途的方法。

正文(英文原文)

大型深度学习模型已成为各种重要机器学习(ML)任务的核心。但是,研究表明,在没有任何保护的情况下,恶意行为者可以攻击多种模型,在模态间泄露训练示例的信息。因此,有必要防范这种信息泄露。

差分隐私(DP)提供了对抗试图提取关于训练数据的信息的攻击者的形式保护。深度学习中最流行的DP训练方法是差分隐私随机梯度下降(DP-SGD)。核心配方实现了DP中的共同主题:“混淆”算法的输出与噪声以遮盖任何单个输入的贡献。

在实践中,DP训练可能非常昂贵,甚至对于非常大的模型也可能无效。不仅是要求隐私保证的计算成本通常会增加,而且噪音也会成比例地增加。鉴于这些挑战,近年来一直很有兴趣开发方法,以启用高效的DP训练。目标是开发生产高质量大规模私有模型的简单实用方法。

ImageNet分类基准是实现此目标的有效测试平台,因为1)即使在非私有设置下,这是一项具有挑战性的任务,需要足够大的模型才能成功分类大量的各种图像,2)它是一个公共的,开放源码数据集,其他研究人员可以访问和使用以进行协作。通过这种方法,研究人员可以模拟需要在私有数据上进行大型模型训练并具有DP保证的实际情况。

为此,今天我们讨论我们在训练高效的大规模私有模型方面所做的改进。首先,在“使用大规模迁移学习进行有差异隐私约束的图像分类”中,我们在ImageNet-1k数据集的具有挑战性的任务上分享了强有力的结果。我们表明,通过大规模迁移学习和仔细选择的超参数的组合,即使在具有挑战性和高维模型的情况下,也确实可以显着减少私人和非私人性能之间的差距。然后在“Feature-based差分隐私图像分类”中,我们进一步表明,仅私有调整预训练模型的最后一层,并使用更先进的优化算法,进一步提高了性能,实现了新的优秀DP结果,覆盖了各种流行的图像分类基准,包括ImageNet-1k。为了鼓励进一步在这个方向上的发展,并使其他研究人员验证我们的发现,我们还发布了相关的源代码。

迁移学习和差分隐私

迁移学习背后的主要思想是重复使用解决一个问题的知识,然后将其应用于相关问题。当目标问题的数据有限或质量较低时,这是非常有用的,因为它允许我们利用从更大、更多样化的公共数据集中获得的知识。

在DP的背景下,迁移学习已经成为一种有前途的技术,通过利用从预训练任务中学到的知识,提高了私有模型的准确性。例如,如果一个模型已经针对一个相似的隐私敏感任务在一个大型公共数据集上进行了训练,那么它可以在一个更小且更具体的数据集上进行微调,以进行目标DP任务。更具体地说,首先在没有隐私问题的大型数据集上预训练模型,然后对敏感数据集进行私有调整。在我们的工作中,我们改进了DP迁移学习的有效性,并通过模拟对公开可用数据集(即ImageNet-1k、CIFAR-100和CIFAR-10)的私有训练来说明它的效果。

更好的预训练提高了DP性能

为了开始探索如何使迁移学习对不同隐私差异的图像分类任务有效,我们仔细研究了影响DP性能的超参数。令人惊讶的是,我们发现,在经过仔细选择的超参数的情况下(例如,将最后一层初始化为零并选择大批量大小),仅对预训练模型的最后一层进行私人微调,相对于基线,产生了显着的改进。仅对最后一层进行训练还显着提高了具有DP的高质量图像分类模型的成本效益比。

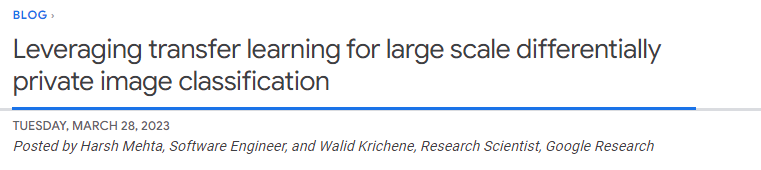

如下图所示,我们比较在ImageNet上最好的超参数建议在隐私和非隐私设置下的性能,以及在各种模型和预训练数据集大小之间的性能。我们发现,扩展模型并使用更大的预训练数据集可以减少由添加隐私保证而带来的准确性差距。通常,系统的隐私保证由正参数ε表示,较小的ε对应更好的隐私。在下图中,我们使用隐私保证ε = 10。

更好的优化器提高DP性能

有些令人惊讶的是,我们发现仅对预训练模型的最后一层进行私有调整提供了DP最佳实用性。虽然过去的研究[1、2、3]在训练大型模型时主要依赖于使用一阶差分隐私训练算法,如DP-SGD,但在仅从特征中学习最后一层的情况下,我们观察到计算负担通常足够低,可以允许使用更复杂的优化方案,包括二阶方法(例如牛顿或准牛顿方法),这些方法可能更准确,但也更消耗计算资源。

在“Feature-based差分隐私图像分类”中,我们系统地探索了损失函数和优化算法的影响。我们发现,虽然常用的逻辑回归在非私有设置中表现比线性回归更好,但在私有设置中情况则相反:最小二乘线性回归在隐私和计算角度上都比逻辑回归更有效,适用于典型范围的ε值([1,10]),对于更严格的epsilon值(ε<1)更有效。

我们进一步探索使用DP牛顿法解决逻辑回归的方法。我们发现,在高隐私模式下,这仍然不如DP线性回归表现优异。事实上,牛顿法涉及计算黑塞矩阵(捕捉二阶信息的矩阵),并且使这个矩阵差分隐私需要在逻辑回归中添加比在线性回归中更多的噪音,因为线性回归具有高度结构化的黑塞矩阵。

基于此观察,我们引入一种称为基于特征协方差的差分隐私SGD(DP-FC)的方法,其中我们仅将逻辑回归中的黑塞矩阵替换为私人特征协方差。由于特征协方差仅依赖于输入(既不依赖于模型参数也不依赖于类标签),因此我们能够在各类别和训练迭代之间共享它,从而大大减少需要添加的噪音。这使我们能够将使用逻辑回归的好处与使用线性回归的高效隐私保护相结合,从而实现了更好的隐私-效用权衡。

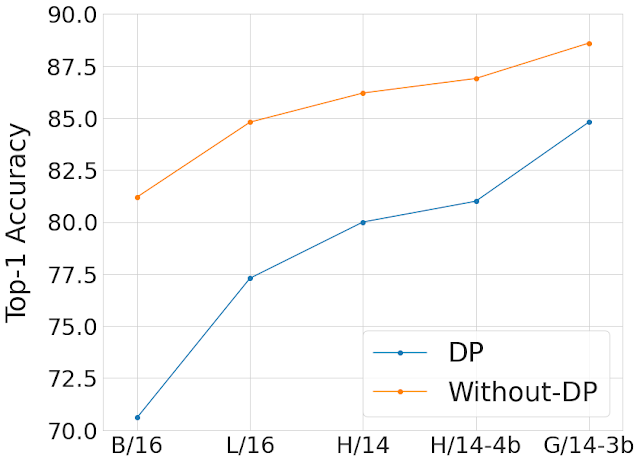

使用DP-FC,我们仅通过对从强大的预训练模型提取的特征进行DP微调,就在三个私有图像分类基准测试中大大超越了以前的最新结果,即ImageNet-1k、CIFAR-10和CIFAR-100。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง