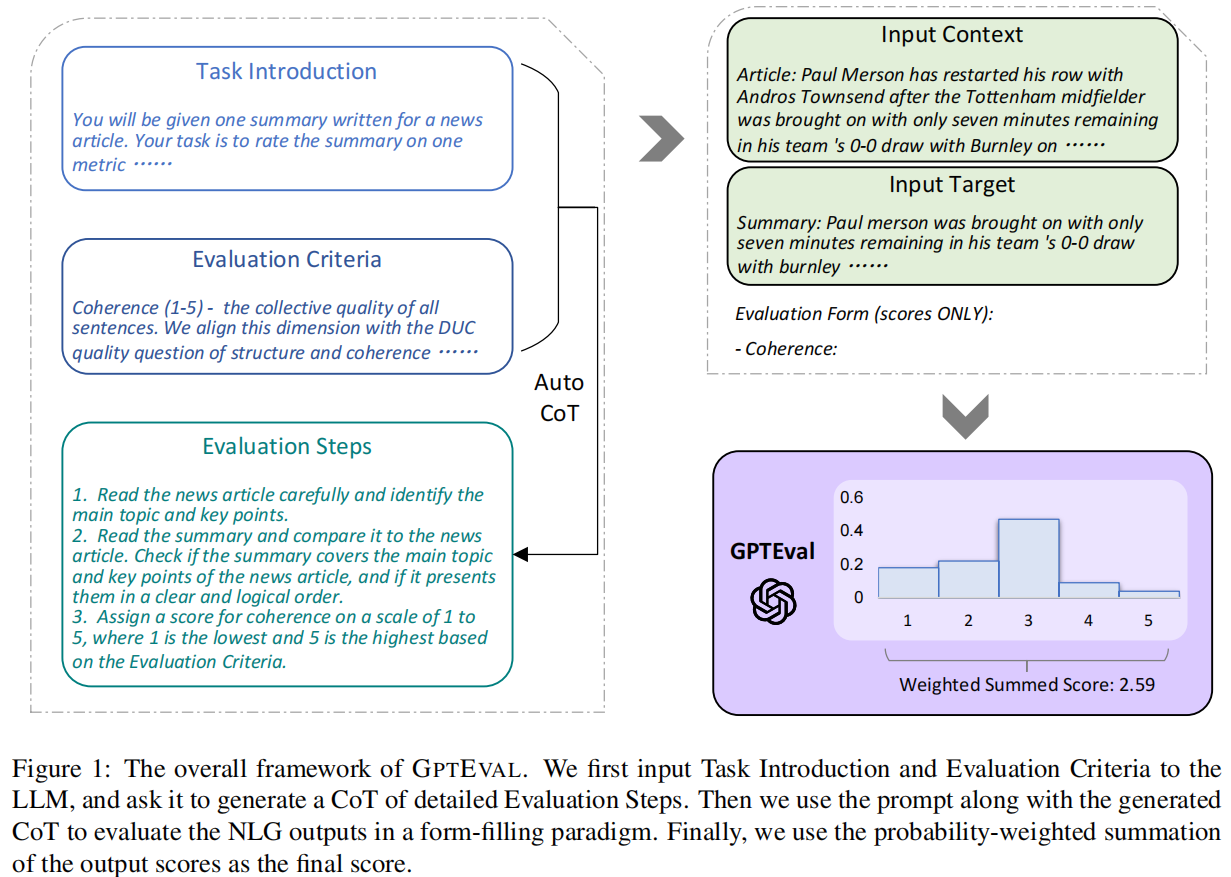

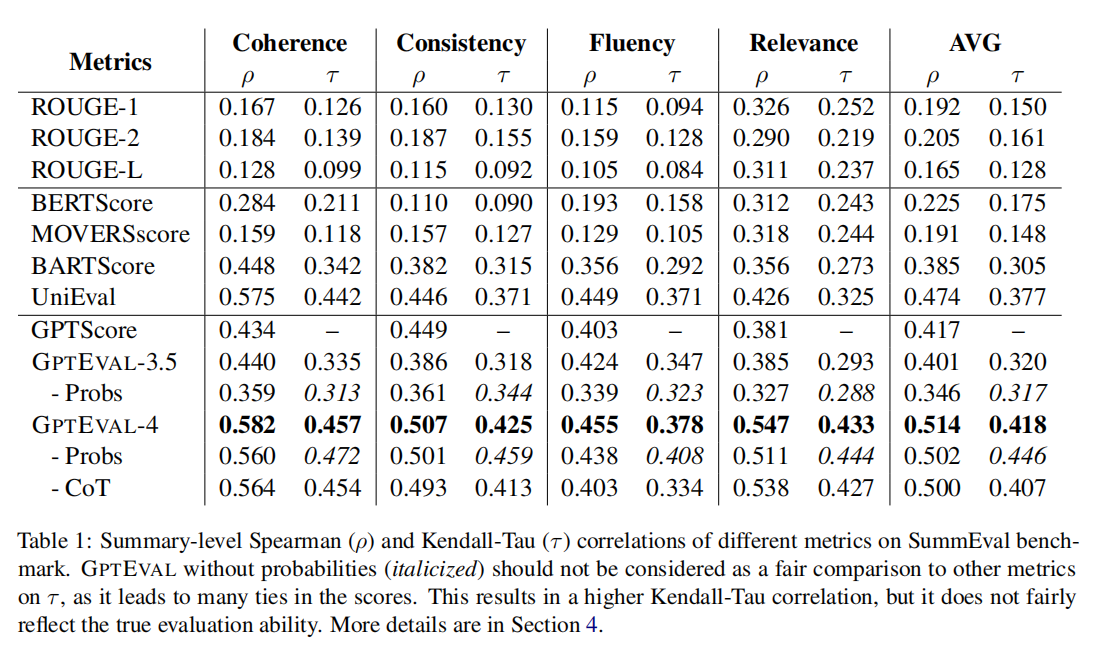

自然语言生成系统(NLG)生成的文本质量很难进行自动化评估。常规基于参考文本的度量方法,如BLEU和ROUGE,在需要创造性和多样性的任务中与人类判断的相关性相对较低。最近的研究建议使用大型语言模型(LLM)作为NLG评估的无参考度量方法,这样有助于适用于缺乏人类参考的新任务。然而,这些基于LLM的评估器仍然具有较低的人类相关性,而中型神经评估器则具有较高的人类相关性。在这项工作中,我们提出了GPTEval框架,该框架使用链式思考(CoT)和填充形式的范式与大型语言模型一起评估NLG输出的质量。我们在文本摘要和对话生成两个生成任务中进行了实验。我们展示了使用GPT-4作为骨干模型的GPTEval在摘要任务上实现了0.514的斯皮尔曼相关性,大幅优于所有之前的方法。我们还对基于LLM的评估器的行为进行了初步分析,并强调了基于LLM的评估器可能存在偏向于LLM生成文本的潜在问题。

标题:GPTEVAL: NLG Evaluation using GPT-4 with Better Human Alignment

作者:Yang Liu, Dan Iter, Yichong Xu, Shuohang Wang, Ruochen Xu, Chenguang Zhu

论文:https://arxiv.org/abs/2303.16634

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง