总结:

本文介绍了一种称为“长学习”的新颖学习策略,旨在加快机器学习的发展速度。长学习主要涉及两个方面:自我监督和增量学习。自我监督有助于减少人为监督的需要,增量学习可以让模型根据新数据快速地适应和更新。文章还介绍了一些长学习的应用,例如文本生成、图像生成和自然语言处理等。最后,文章指出长学习在未来将会成为机器学习领域的热点话题,并可能有助于解决目前机器学习面临的一些挑战。

原文标题:From Deep to Long Learning?(英文原文)

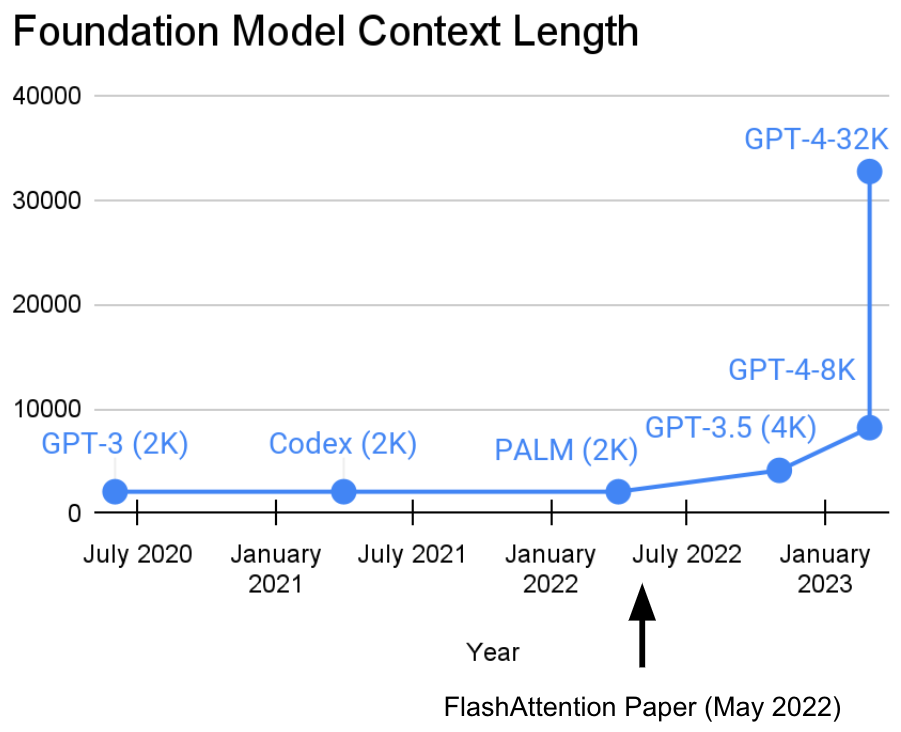

我们实验室最近两年来一直致力于增加序列长度。我们认为更长的序列能够使新的机器学习基础模型进入一个新的时代:它们可以从更长的上下文、多个媒体来源、复杂的演示以及更多数据中学习。在世界范围内,有大量的数据都等待着被学习!我们见证了这方面的进展,感到非常惊异。顺便说一下,我们很高兴能够通过 Tri Dao 和 Dan Fu 开发的 FlashAttention(代码、博客、论文)来推动序列长度提高的进程。他们已经证明了长度为32k的序列是可行的,并且在这个基础模型时代也是广泛可用的(我们听说OpenAI、Microsoft、NVIDIA和其他公司也在使用它,这太棒了!)。

基础模型的上下文长度最近一直在增加!接下来会发生什么呢?

正如GPT4新闻稿所指出的那样,这使得将近50页的文本作为上下文成为可能,而像Deepmind的Gato中的标记化/补丁思想则可以使用图像作为上下文。许多惊人的想法正在聚集在一起,太棒了!

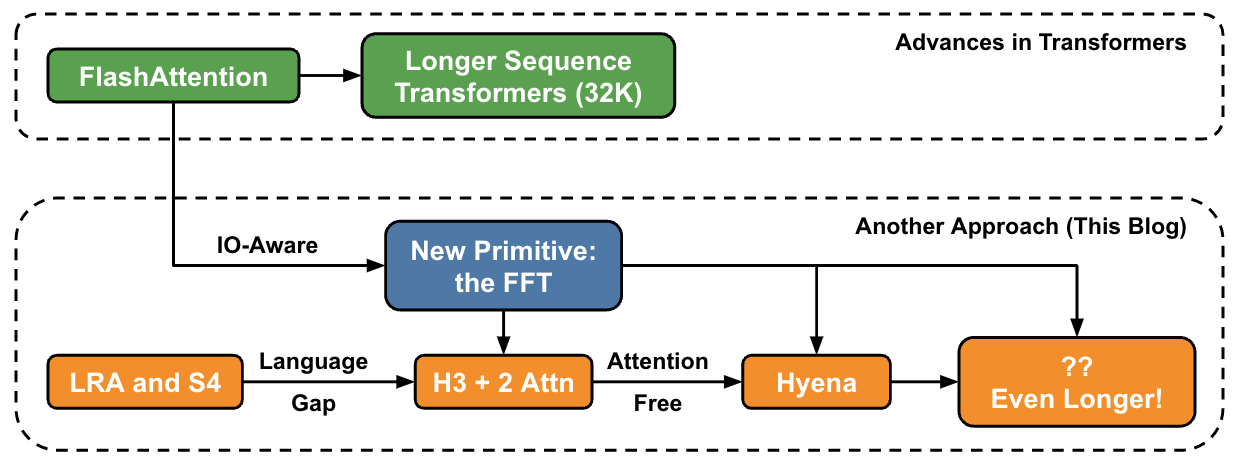

这篇文章介绍了另一种在高层次上提高序列长度的方法,并讨论了与一组新的基元的联系。

我们遇到的一个关键问题是,Transformer中的注意力层在序列长度上呈二次增长:从32k长度到64k长度并不是两倍费用,而是比注意力层大4倍。这促使我们研究几乎线性时间的序列模型。对于我们的实验室而言,这始于Hippo,接着是S4、H3,现在是Hyena。这些模型有望实现上百万的上下文长度,甚至可能达到十亿!

最近的历史和进展

Long Range Arena和S4

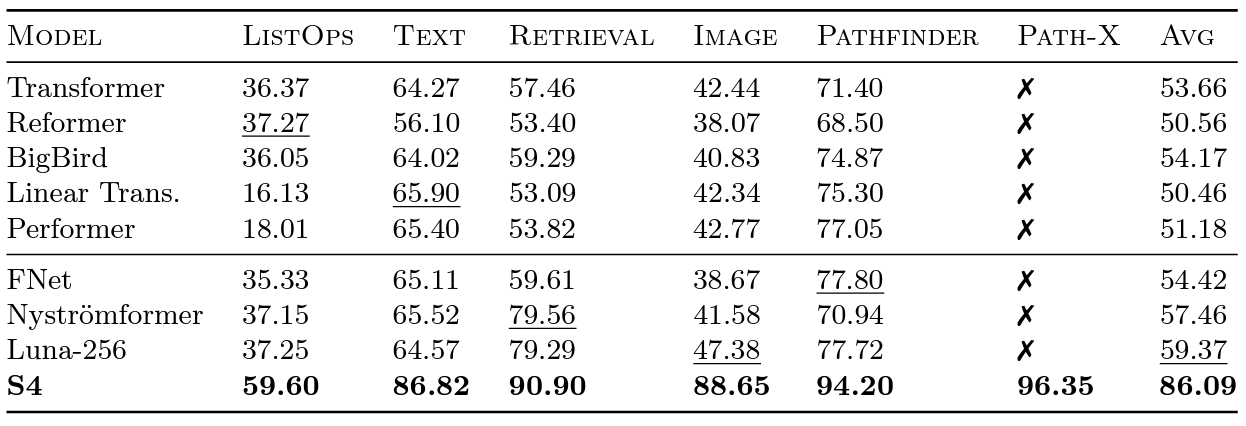

2020年,Google研究人员引入了Long Range Arena基准测试,以评估不同模型处理长期依赖关系的能力如何。LRA测试了一组任务,包括不同的数据类型和模态,例如文本、图像和数学表达式,序列长度最长可以达到16K(Path-X):将未经阻力生长的像素进行分类的图像。在缩放Transformer以适应更长序列的方面已经有了很多杰出的工作,但其中许多方法似乎都牺牲了准确性。这里有一个问题:所有这些Transformer方法及其变体都难以超越随机猜测。

接着,由不可思议的Albert Gu领导的S4应运而生!受到LRA基准测试结果的启发,Albert想要弄清楚如何更好地建模长期依赖性。基于正交多项式和递归模型以及卷积模型之间的关系的长期工作,我们引入了S4——一种基于结构状态空间模型(SSMs)的新序列模型。

关键是,SSMs在序列长度NN中以O(NlogN)的速度增长,而不是像注意力那样呈二次幂。 S4能够成功地模拟LRA中的长期依赖关系,并且还是首个在Path-X上获得高于平均表现(现在可以获得96.4%的准确性!)的模型。自从发布S4以来,我们非常兴奋地看到人们如何基于这些思想并使空间更加丰富:例如Scott Linderman小组的S5、Ankit Gupta的DSS(我们自己的后续合作S4D)、Hasani&Lechner的Liquid-S4等模型,当然,我们对Sasha Rush和Sidd Karamcheti的惊人的Annotated S4也非常感激!

顺便说一下:当我们发布FlashAttention时,我们能够增加Transformer的序列长度。我们发现,通过将序列长度增加到16K,Transformer也可以获得非微不足道的表现(63%)!

与语言之间的差距

但是,S4在语言建模方面还存在一些缺陷,最多可以达到5个复杂度点(作为上下文,125M模型和6.7B模型之间的差距)。为了解决这个问题,我们研究了像联想回忆一样的人造语言,以确定语言所需的属性。我们最终设计了Hyena,它是基于堆叠两个SSM并将它们的输出乘以乘法门的新层。

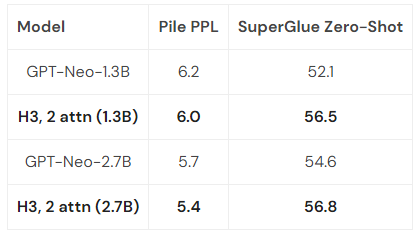

使用Hyena,我们替换了GPT-style Transformer中的几乎所有注意力层,训练了400B个标记的文本数据集,并在perplexity和downstream评估上与Transformer匹配:

由于Hyena的层是基于SSM构建的,因此它的计算量在序列长度上以O(NlogN)的速度增长。两个注意力层仍然使整个模型的计算量与NN呈N2,但稍后会进一步讨论此问题……

当然,我们不是唯一朝这个方向思考的人:GSS还发现,带门控的SSM可以很好地与语言建模中的注意力协同工作(这启发了H3),Meta发布了他们的Mega模型,该模型也将SSM与注意力结合起来,BiGS模型取代了伯特风格模型中的注意力,我们的RWKV朋友一直在寻找完全递归的方法。这方面的工作非常令人兴奋!

下一个进步:Hyena

这一行的下一个架构是Hyena – 我们想看看是否有可能摆脱H3中的最后两个注意力层,并获得一个几乎线性增长于序列长度的模型。结果,两个简单的见解使我们得出了答案:

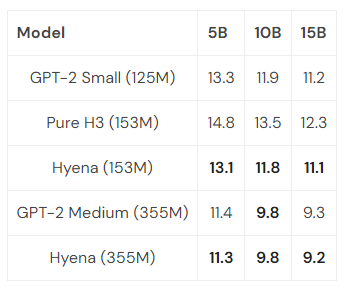

每个SSM可以被视为输入序列长度的卷积滤波器 – 因此,我们可以用输入序列的大小替换SSM,以获得相同计算量下更强大的模型。特别地,我们通过另一个小的神经网络来隐含地参数化卷积滤波器,借鉴了神经场文献中的强大方法以及CKConv/FlexConv的研究成果。此外,卷积可以在O(N log N)时间内计算出市序列长度 – 几乎线性扩展! H3中的门控行为可以泛化:H3取输入的三个投影,然后迭代地进行卷积并应用门控。在Hyena中,我们只需添加更多的投影和更多的门控,这有助于泛化更表现力的架构,并缩小到注意力之间的差距。 在Hyena中,我们提出了第一个完全近线性时间的卷积模型,可以在困惑度和下游任务上与Transformer匹配,并在初始规模实验中取得了有前途的结果。我们在PILE的子集上训练了小型和中型模型,并发现val PPL与Transformer相匹配:

一些优化后(稍后详细介绍),Hyena模型在2K的序列长度上比相同大小的Transformer略慢 – 但在更长的序列长度上会更快。

我们非常兴奋地看到这些模型可以达到多远,并激动地将它们扩展到PILE的全尺寸(400B个令牌):如果将H3和Hyena的最佳思想结合起来,会发生什么,我们还能走多远?

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง