在这项工作中,提出了从语言反馈中模仿学习(ILF),这是一种迭代算法,通过从语言反馈中学习,训练LM的行为符合人类的偏好。

Training Language Models with Language Feedback at Scale

Jérémy Scheurer, Jon Ander Campos, Tomasz Korbak, Jun Shern Chan, Angelica Chen, Kyunghyun Cho, Ethan Perez

[New York University & FAR AI & HiTZ Center & University of the Basque Country UPV/EHU & University of Sussex & Genentech & CIFAR LMB & Anthropic]

- 预先训练的语言模型经常产生不符合人类偏好的输出,如有害的文本或事实错误的总结。最近的工作是通过学习人类反馈的一种简单形式来解决上述问题:对模型生成的输出进行比较。然而,比较反馈只传达了关于人类偏好的有限信息。

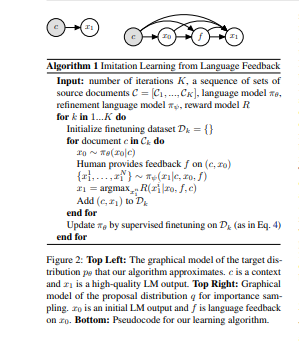

- 在本文中,介绍了从语言反馈中模仿学习(ILF),这是一种利用更多信息的语言反馈的新方法。ILF包括三个迭代应用的步骤:首先,在输入、初始LM输出和反馈上调节语言模型,以产生细化。第二,选择包含最多反馈的细化。第三,对语言模型进行微调,以最大限度地提高在输入情况下所选择的细化方案的可能性。

- 从理论上表明,ILF可以被看作是贝叶斯推理,类似于从人类反馈中强化学习。我们在一个精心控制的玩具任务和一个现实的总结任务中评估了ILF的有效性。

- 实验表明,大型语言模型能够准确地纳入反馈,而且用ILF进行的微调能够很好地扩展数据集的规模,甚至优于人类总结的微调效果。从语言和比较反馈中学习的效果优于单独学习的效果,达到了人类水平的总结性能。

https://arxiv.org/pdf/2303.16755.pdf

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง