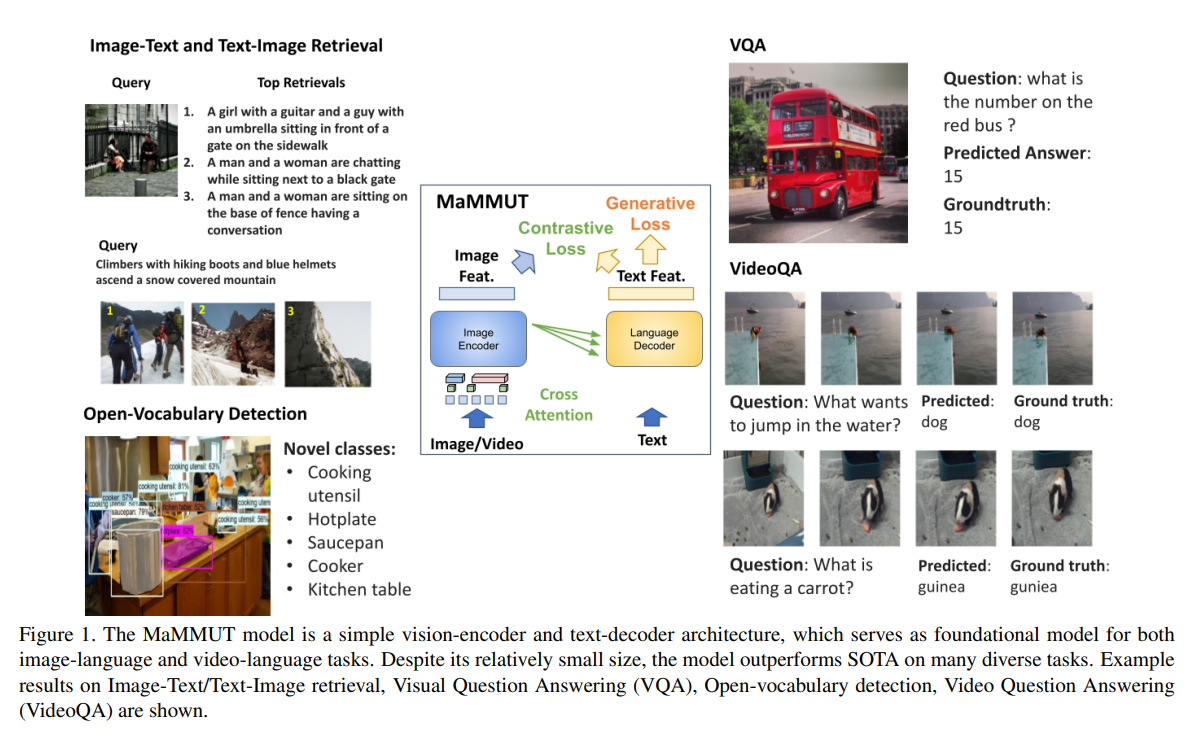

【推荐理由】本文用一个简单的联合框架整合了多种多模态任务。该框架具体由一个单独的视觉编码器和一个文本解码器组成。它能够通过一种新颖的两遍方法适应对比和生成学习。尤其是考虑到其规模,它在VQA和视频字幕生成方面展现出有竞争力的结果。

MaMMUT: A Simple Architecture for Joint Learning for MultiModal Tasks

Weicheng Kuo, AJ Piergiovanni, Dahun Kim, Xiyang Luo, Ben Caine, Wei Li, Abhijit Ogale, Luowei Zhou , Andrew Dai, Zhifeng Chen, Claire Cui, Anelia Angelova

[Google Research]

【论文链接】https://arxiv.org/pdf/2303.16839.pdf

【摘要】语言模型的发展已经从编码器-解码器转向了仅解码器的设计。此外,普遍认为最流行的两个多模态任务,生成任务和对比任务,往往会相互冲突,难以在一个架构中容纳,并且需要针对下游任务进行复杂的适应性调整。本文提出了一种新的训练范式,使用仅解码器的模型进行多模态任务的训练,这在联合学习这些不同的视觉语言任务方面十分有效。这是通过一个名为MaMMUT的简单模型实现的。它由一个单一的视觉编码器和一个文本解码器组成,能够通过文本解码器上的新型两次通行方法来适应对比和生成学习。作者证明了这些多样化目标任务的联合训练是简单、有效的,并且最大化了模型的权重共享。此外,相同的架构使得对开放词汇目标检测和视频语言任务的直接扩展变得容易。该模型能够解决各种任务,同时容量适中。该模型在图像-文本和文本-图像检索、视频问答和开放词汇检测任务上实现了SOTA,超过了更大、更广泛训练的基础模型。考虑到模型的大小,它在VQA和视频字幕生成方面显示出了有竞争力的结果。消融实验证实了此方法的灵活性和优势。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง