【推荐理由】视频掩码自编码器(VideoMAE)是一种可扩展且通用的自监督预训练器,用于构建视频基础模型。由于编码器中具有高掩码比率,因此VideoMAE非常高效。

VideoMAE V2: Scaling Video Masked Autoencoders with Dual Masking

Limin Wang,Bingkun Huang,Zhiyu Zhao,Zhan Tong,Yinan He, Yi Wang,Yali Wang,Yu Qiao

[State Key Laboratory for Novel Software Technology, Nanjing University, China&Shanghai AI Lab, China & Shenzhen Institute of Advanced Technology, CAS, China]

【论文链接】https://arxiv.org/pdf/2303.16727.pdf

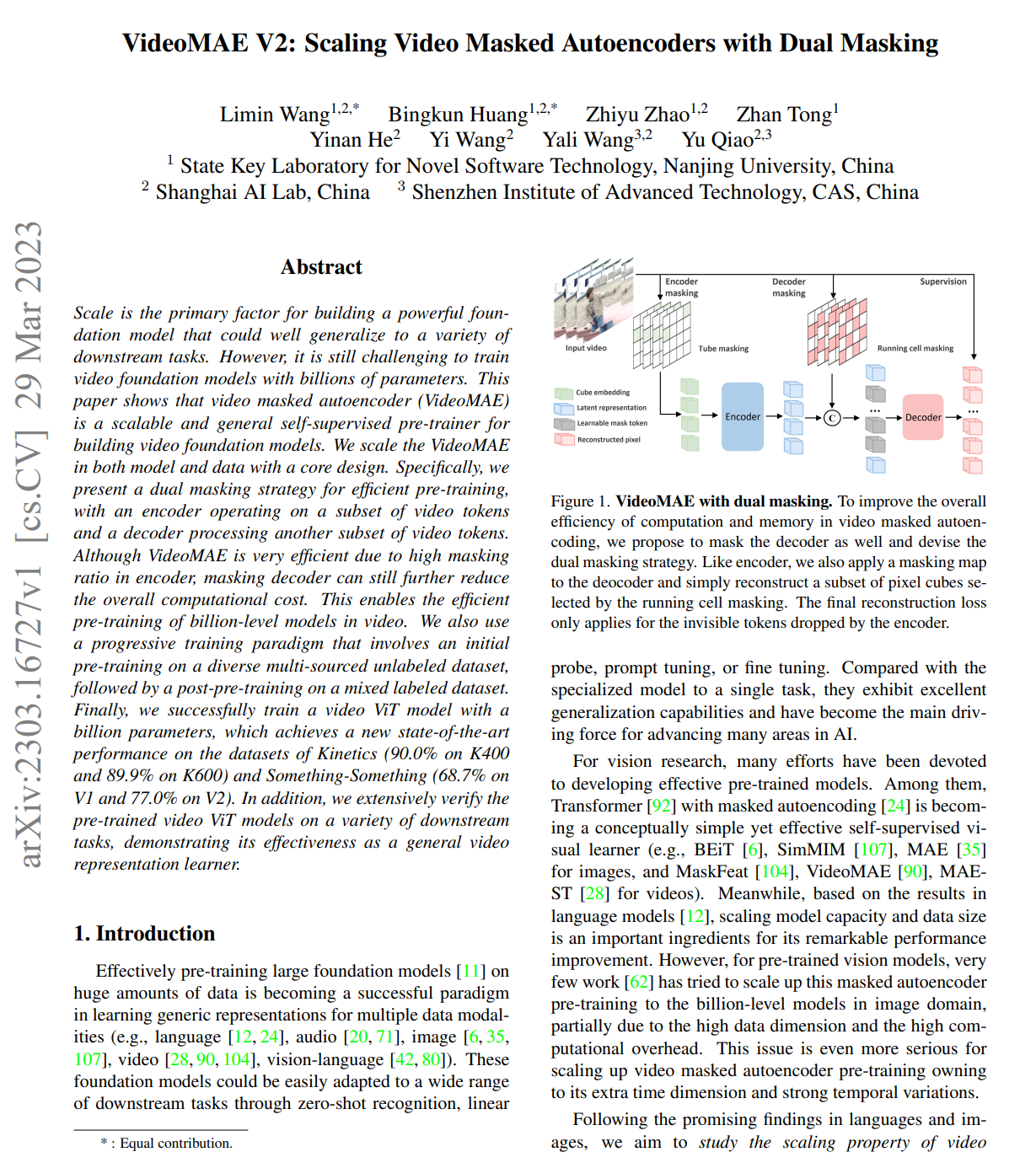

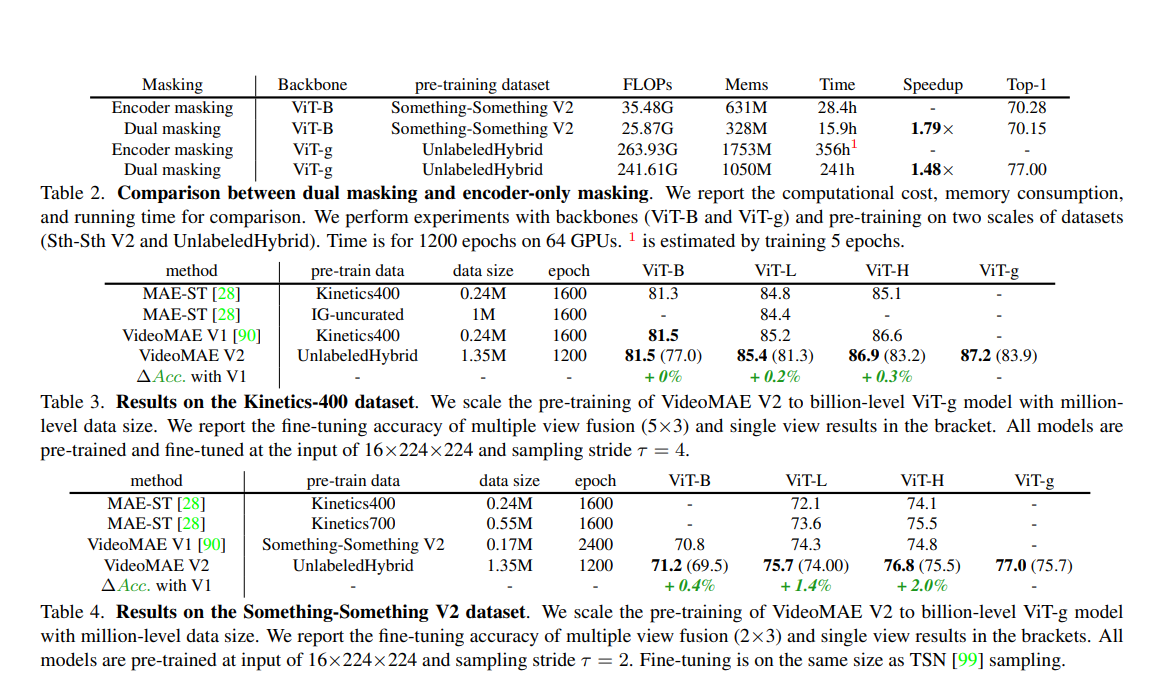

【摘要】规模是建立强大基础模型以适用于各种下游任务的主要因素。然而,训练数十亿参数的视频基础模型仍然具有挑战性。本文展示了视频遮掩自编码器(VideoMAE)作为可扩展且通用的自监督预训练器,用于构建视频基础模型。作者通过核心设计在模型和数据方面扩展了VideoMAE。具体而言,文章提出了一种双遮掩策略以实现高效的预训练,其中编码器处理一部分视频符号,解码器处理另一部分视频符号。尽管VideoMAE非常高效,因为编码器的高遮掩比率,但遮掩解码器仍然可以进一步降低总体计算成本。这使得可以高效地预训练视频中的十亿级模型。作者还使用了渐进式训练范式,包括在多样化的未标记数据集上进行初始预训练,然后在混合标记数据集上进行后预训练。最终,作者成功训练了一个拥有十亿参数的视频ViT模型,在Kinetics(K400上90.0%,K600上89.9%)和Something-Something(V1上68.7%,V2上77.0%)数据集上取得了新的最佳性能。此外,作者还广泛验证了预训练的视频ViT模型在各种下游任务中的有效性,证明其作为通用视频表示学习器的有效性。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง