【推荐理由】本文介绍了CodeGeeX,一个拥有130亿参数的多语言模型,用于代码生成。用户研究表明,CodeGeeX可以帮助83.4%的用户提高编码效率。

CodeGeeX: A Pre-Trained Model for Code Generation with Multilingual Evaluations on HumanEval-X

Qinkai Zheng, Xiao Xia, Xu Zou, Yuxiao Dong, Shan Wang, Yufei Xue, Zihan Wang, Lei Shen, Andi Wang, Yang Li, Teng Su, Zhilin Yang, Jie Tang

[Tsinghua University & Zhipu.AI]

【论文链接】https://arxiv.org/pdf/2303.17568.pdf

【项目链接】https://github.com/THUDM/CodeGeeX

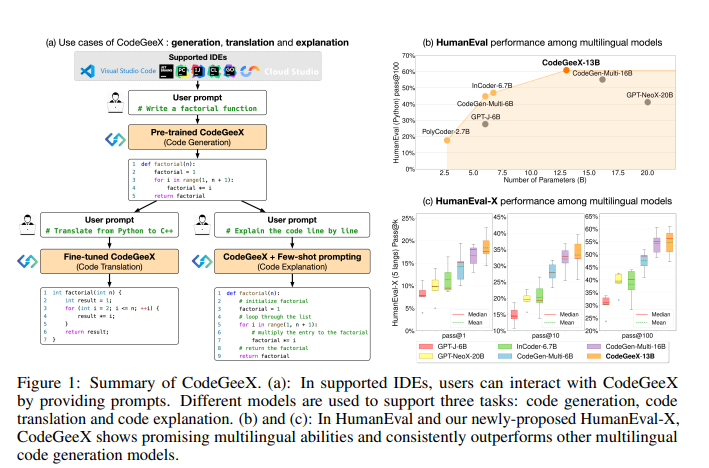

【摘要】大型预训练代码生成模型,如OpenAI Codex,可以生成语法和功能正确的代码,使程序员的编码更加高效,对人工通用智能的追求也更近了一步。在本文中,作者介绍了CodeGeeX,一个拥有130亿参数的多语言模型,用于代码生成。CodeGeeX在2022年6月的23种编程语言的8500亿个标记上进行了预训练。作者广泛的实验表明,CodeGeeX在HumanEval-X上的代码生成和翻译任务上优于类似规模的多语言代码模型。在HumanEval(仅限Python)的基础上,作者开发了HumanEval-X基准测试,通过手写C ++、Java、JavaScript和Go的解决方案来评估多语言模型。此外,作者在Visual Studio Code、JetBrains和Cloud Studio上构建了基于CodeGeeX的扩展,每周为数以万计的活跃用户生成47亿个标记。用户研究表明,CodeGeeX可以帮助83.4%的用户提高编码效率。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง