【推荐理由】本文使用软对齐方法改进多模态大模型CLIP,使其不需要image-text pair对训练。

SoftCLIP: Softer Cross-modal Alignment Makes CLIP Stronger

Yuting Gao, Jinfeng Liu, Zihan Xu, Tong Wu, Wei Liu, Jie Yang, Ke Li, Xing Sun

【论文链接】https://arxiv.org/pdf/2303.17561.pdf

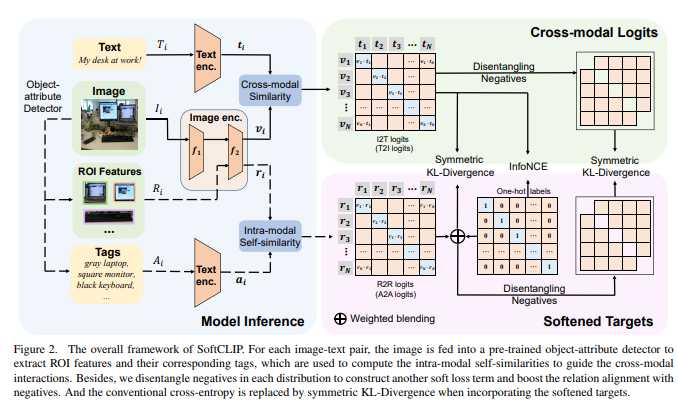

【摘要】在过去的两年中,视觉语言预训练在多个下游任务中取得了显著的成功。然而,获取高质量的图像文本对,其中对是完全独立的,仍然是一个具有挑战性的任务,常用的数据集中存在噪声。为了解决这个问题,本文提出了SoftCLIP,一种新颖的方法,通过引入一个软化的目标来实现软的跨模态对齐,该目标是从细粒度的内模态自相似性生成的。内模态指导有助于使两个对有一些局部相似性,并在两种模态之间建立多对多的关系。此外,由于正样本在软化的目标分布中仍然占主导地位,我们将负样本从分布中分离出来,以进一步提高跨模态学习中与负样本的关系对齐。大量实验证明了SoftCLIP的有效性。特别是,在ImageNet零样本分类任务中,使用CC3M/CC12M作为预训练数据集,SoftCLIP相对于CLIP基线带来了6.8%/7.2%的top-1准确率提升。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง