AvatarCraft: Transforming Text into Neural Human Avatars with Parameterized Shape and Pose Control

Ruixiang Jiang, Can Wang, Jingbo Zhang, Menglei Chai, Mingming He, Dongdong Chen, Jing Liao

[The Hong Kong Polytechnic University & City University of Hong Kong & Google & Netflix Microsoft Cloud AI ]

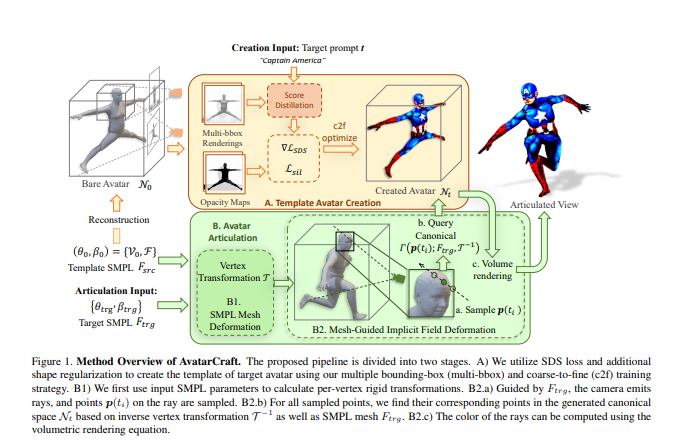

- 神经隐含场在表现3D场景和生成高质量的新观点方面非常强大,但使用这种隐含表示法来创建具有特定身份和艺术风格的3D人类头像,并使之易于动画化,仍然是一个挑战。

- 本文提出的方法,AvatarCraft,通过使用扩散模型来指导基于单一文本提示的神经化身的几何和纹理的学习来解决这一挑战。我们精心设计了神经隐含场的优化框架,包括从粗到细的多边界盒训练策略、形状正则化和基于扩散的约束,以产生高质量的几何和纹理。此外,我们通过对神经隐含场进行变形,用一个显式的扭曲场将目标人类网格映射到模板人类网格,使人类化身成为可动画的,两者都使用参数化人类模型表示。

- 这通过控制姿势和形状参数简化了生成的头像的动画和重塑。对各种文本描述的广泛实验表明,AvatarCraft在创建人类头像和渲染新的视图、姿势和形状方面是有效和强大的。

代码:https://avatar-craft.github.io

https://arxiv.org/pdf/2303.17606.pdf

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง