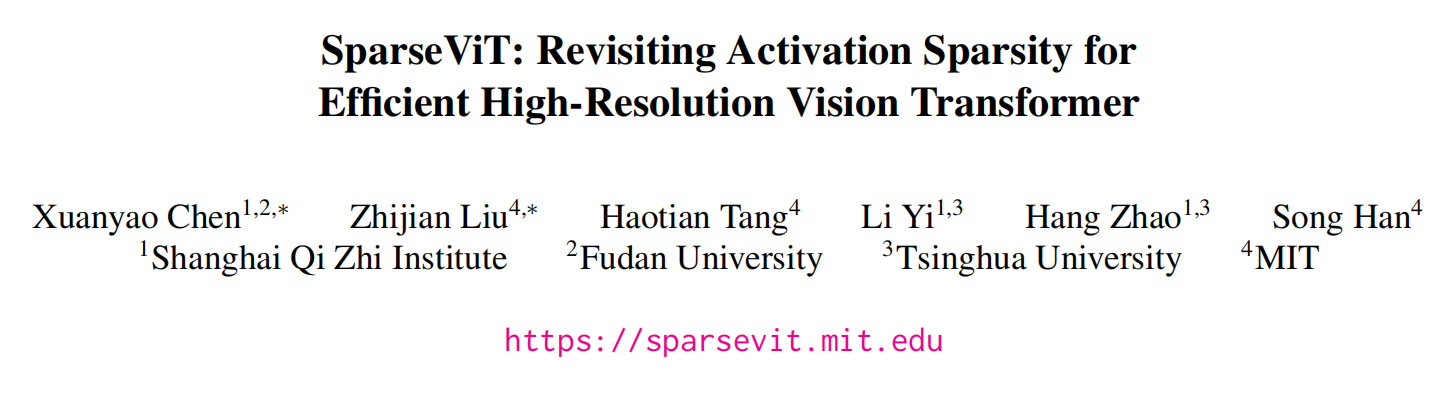

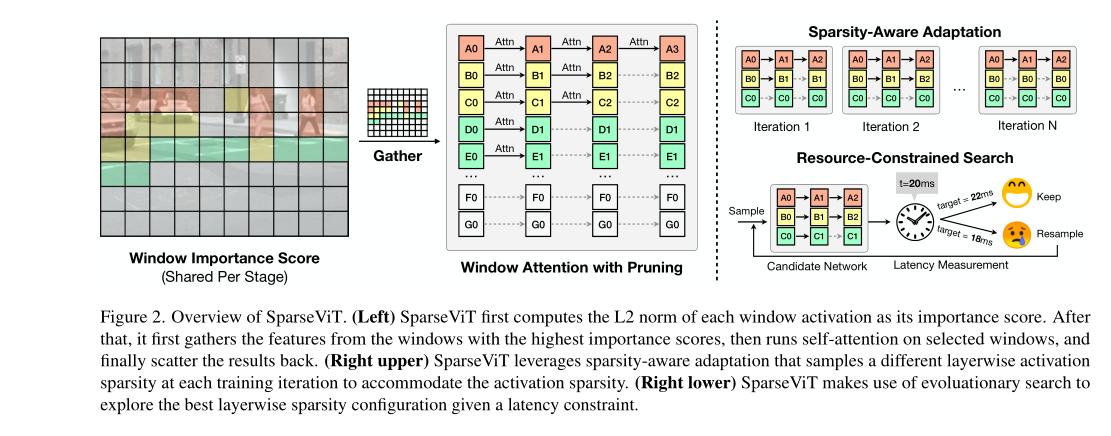

高分辨率图像可以让神经网络学习到更丰富的视觉表示,但这种改进的性能增强是以不断增长的计算复杂度为代价的,这阻碍了它们在延迟敏感的应用中的使用。由于并非所有像素都是相同的,跳过对不太重要的区域的计算可以提供一种简单有效的方式来减少计算。然而,这种方法难以在卷积神经网络中实现实际加速,因为它破坏了密集卷积工作负载的规律性。在本文中,本文介绍了SparseViT,它重新审视了最近基于窗口的视觉变换器(ViT)的激活稀疏性。由于窗口注意力自然地分批处理块,因此使用窗口激活裁剪进行实际加速变得可能:即通过不到60%的稀疏度实现约50%的延迟降低。由于不同层的敏感性和计算成本不同,不同的层应该分配不同的修剪比例。本文引入了稀疏感知自适应,并应用进化搜索来高效地在广阔的搜索空间中找到最佳的逐层稀疏配置。SparseViT在单目 3D 对象检测、2D 实例分割和2D 语义分割中比其密集对应物分别实现了1.5倍、1.4倍和1.3倍的加速,几乎没有损失精度。

SparseViT是一种新型的高分辨率视觉变换器,旨在重新审视激活稀疏性以实现高效率。该模型使用了一种名为“分层稀疏注意力”的技术,这种技术可以有效地减少模型中冗余的注意力计算。相比传统的稀疏模型,SparseViT在视觉效果和模型性能方面都取得了更好的结果。同时,这种模型可以用更少的计算资源来训练,从而提高了训练效率。因此,SparseViT具有广泛的应用前景,可用于图像分类、目标检测和语义分割等领域。

标题:SparseViT: Revisiting Activation Sparsity for Efficient High-Resolution Vision Transformer

作者:Xuanyao Chen, Zhijian Liu, Haotian Tang, Li Yi, Hang Zhao, Song Han

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง