乐观的科幻小说通常想象这样一个未来:人类创造艺术并追求充实的消遣,而人工智能机器人则处理枯燥或危险的任务。相比之下,今天的人工智能系统在表面上的创造性任务上显示出越来越复杂的生成能力。但是机器人在哪里?这种差距被称为Moravec 的悖论,即人工智能中最困难的问题涉及感觉运动技能,而不是抽象思维或推理。换句话说,“难的问题容易,容易的问题难”。

今天,我们宣布了两项重大进展,使通用人工智能代理能够执行具有挑战性的感觉运动技能:

-

人工视觉皮层(称为 VC-1):单一感知模型,首次支持多种感觉运动技能、环境和具体化。VC-1 接受了人们执行日常任务的视频的训练,这些视频来自 Meta AI 和学术合作伙伴创建的开创性Ego4D 数据集。VC-1 在虚拟环境中的 17 种不同的感觉运动任务上与最著名的结果相匹配或优于其表现。

-

一种称为自适应(感觉运动)技能协调 (ASC) 的新方法,它在机器人移动操作的挑战性任务(导航到一个物体、捡起它、导航到另一个位置、放置对象,重复)在物理环境中。

数据为这两项突破提供了动力。AI 需要数据来学习——具体来说,具体的 AI 需要捕捉与环境交互的数据。传统上,这种交互数据是通过收集大量演示或让机器人从头开始从交互中学习来收集的。这两种方法都过于耗费资源,无法扩展到一般的具身 AI 代理的学习。在这两项工作中,我们正在开发机器人学习的新方法,使用人类与现实世界互动的视频以及照片级真实模拟世界中的模拟互动。

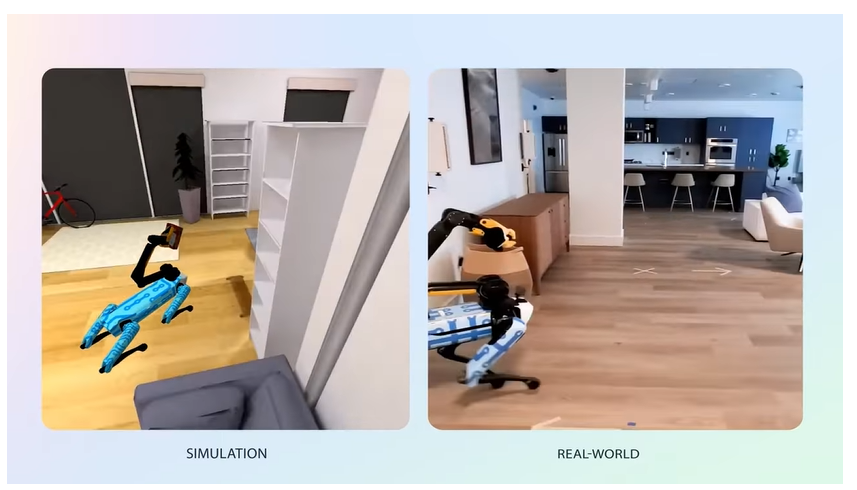

首先,我们通过从大量以自我为中心的视频中训练通用视觉表示模型(人工视觉皮层),为机器人构建了一种从现实世界中的人类交互中学习的方法。这些视频包括我们的开源 Ego4D 数据集,它展示了人们在做日常任务时的第一人称视角,比如去杂货店和做午餐。其次,我们已经建立了一种方法来预训练我们的机器人在模拟中执行长距离重排任务。具体来说,我们在 Habitat 环境中训练策略,并将策略零样本转移到真实的 Spot 机器人,以在不熟悉的现实世界空间中执行此类任务。

迈向具身智能的人工视觉皮层

视觉皮层是大脑的一个区域,它(与运动皮层一起)使有机体能够将视觉转化为运动。我们有兴趣开发人工视觉皮层——AI 系统中的模块,它使人工代理能够将相机输入转换为动作。

我们的 FAIR 团队与学术合作者一起,一直处于为从以自我为中心的视频数据集训练的具身 AI 开发通用视觉表示的最前沿。Ego4D 数据集特别有用,因为它包含来自世界各地的研究参与者进行日常生活活动(包括烹饪、清洁、运动和手工艺)的数千小时可穿戴相机视频。

例如,我们团队 ( R3M ) 之前的一项工作使用 Ego4D 视频帧内的时间和文本视频对齐来学习用于机器人操作的紧凑通用视觉表示。另一项工作 ( VIP ) 使用 Ego4D 框架来学习有效的可操作视觉表示,该表示还可以执行零样本视觉奖励规范来训练具体代理。这些说明了研究界(例如PVR、OVRL、MVP)对网络图像和以自我为中心的视频进行预训练视觉表示的更广泛趋势。

尽管之前的工作主要集中在一小部分机器人任务上,但用于具体化 AI 的视觉皮层应该能够很好地处理不同环境中不同实施例的各种感觉运动任务。虽然之前关于预训练视觉表示的工作让我们瞥见了可行的方法,但它们从根本上说是不可比较的,在不同的数据集上使用不同的方式预训练视觉表示,并在不同的具体 AI 任务上进行评估。缺乏一致性意味着无法知道哪些现有的预训练视觉表示是最好的。

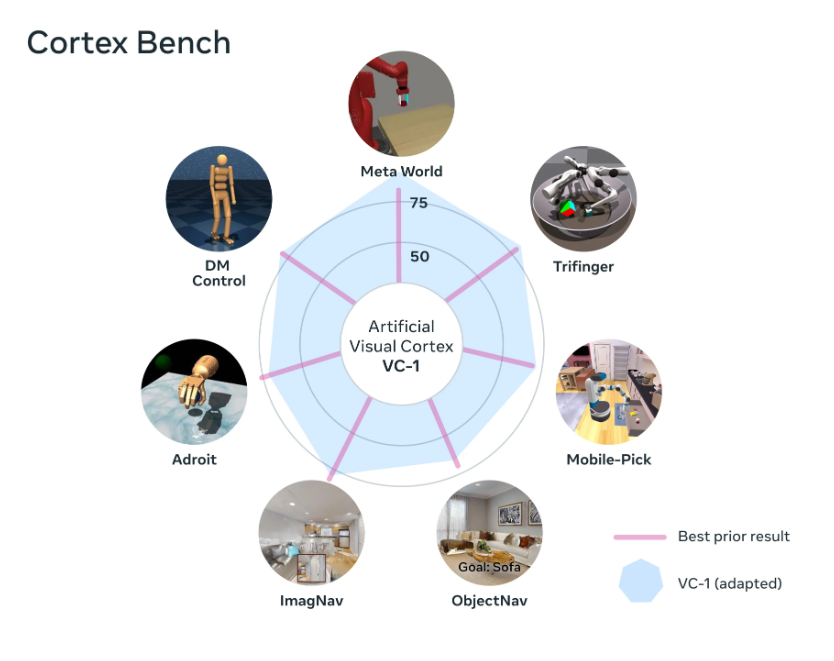

作为第一步,我们策划了 CortexBench,它由 17 种不同的模拟感觉运动任务组成,涵盖运动、导航、灵巧和移动操作,实施社区标准来学习每项任务的政策。视觉环境从平坦的无限平面到桌面设置,再到真实世界室内空间的逼真 3D 扫描。代理实施例从固定的手臂到灵巧的手,再到理想化的圆柱形导航代理,再到铰接式移动操纵器。学习条件从少样本模仿学习到大规模强化学习不等。这使我们能够对现有和新的预训练模型进行严格且一致的评估。在我们工作之前,CortexBench 中每个任务的最佳性能是通过专门为该任务设计的模型或算法实现的。相比之下,我们想要的是一种模型和/或算法,能够在所有任务上取得有竞争力的表现。生物有机体有一个通用的视觉皮层,这就是我们寻找具身代理的目的。

我们着手预训练一个可以在所有这些任务上表现良好的通用视觉皮层。预训练的一个关键选择是数据集的选择。完全不清楚一个好的 embodied AI 预训练数据集会是什么样子。在线提供了大量视频数据,但尝试这些现有数据集的所有组合是不切实际的。

我们从 Ego4D 作为我们的核心数据集开始,然后探索添加额外的数据集是否可以改进预训练模型。拥有以自我为中心的视频很重要,因为它可以让机器人学会从第一人称视角看东西。由于 Ego4D 主要关注烹饪、园艺和手工艺等日常活动,我们还考虑探索房屋和公寓的以自我为中心的视频数据集。最后,我们还研究了静态图像数据集是否有助于改进我们的模型。

总的来说,我们的工作代表了迄今为止对具身 AI 的视觉表征进行的最大、最全面的实证研究,涵盖了来自先前工作的 5 多个预训练视觉表征,以及 VC-1 的多次消融,这些 VC-1 在来自七个不同领域的 4,000 多个小时的以自我为中心的人类视频上进行了训练数据集,需要超过 10,000 GPU 小时的训练和评估。

今天,我们正在开源 VC-1,这是我们最好的视觉皮层模型,遵循 FAIR 的开放研究价值观,造福所有人。我们的结果显示 VC-1 表示在所有 17 项任务上匹配或优于从头开始学习。我们还发现,在与任务相关的数据上调整 VC-1 会导致它在 CortexBench 的所有任务上具有竞争力或优于最知名的结果。据我们所知,VC-1 是第一个视觉预训练模型,在如此多样化的具体化 AI 任务上,它已证明与最先进的结果具有竞争力。我们在相关研究论文中分享了我们的详细经验,例如缩放模型大小、数据集大小和多样性如何影响预训练模型的性能。

机器人移动操作的自适应技能协调

虽然 VC-1 在 CortexBench 中的感觉运动技能方面表现出色,但这些都是短期任务(导航、拾取物体、手持物体操作等)。下一代具身 AI 代理(部署在机器人上)还需要完成长期任务并适应新的和不断变化的环境,包括意外的现实世界干扰。

我们的第二个公告侧重于移动拾取和放置——机器人在新环境中进行初始化,并负责将物体从初始位置移动到所需位置,模拟整理房屋的任务。机器人必须导航到装有物体的容器,例如厨房柜台(已提供大致位置),搜索并拾取物体,导航到其所需的容器,放置物体,然后重复。

为了解决此类长期任务,我们和佐治亚理工学院的合作者开发了一种称为自适应技能协调 (ASC)的新技术,它由三个部分组成:

-

基本感觉运动技能库(导航、拾取、放置)

-

选择哪些技能适合在什么时间使用的技能协调策略

-

当感知到分布外状态时调整预训练技能的纠正策略

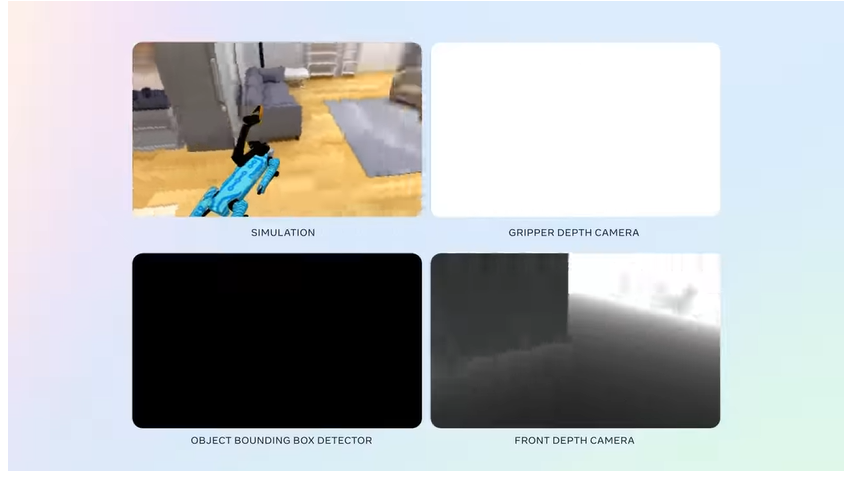

所有感觉运动策略都是“无模型的”。我们使用没有特定任务模块的传感器到动作神经网络,例如映射或规划。机器人完全在模拟中训练,并在没有任何真实世界训练数据的情况下转移到物理世界。

我们通过在新的/未知的现实环境中将 ASC 部署在波士顿动力公司的 Spot 机器人上来证明 ASC 的有效性。我们选择 Boston Dynamics Spot 机器人是因为它具有强大的传感、导航和操纵能力。然而,如今运营 Spot 需要大量的人为干预。例如,拾取一个物体需要一个人在机器人的平板电脑上点击该物体。我们的目标是构建能够通过波士顿动力 API 从板载传感和电机命令感知世界的 AI 模型。

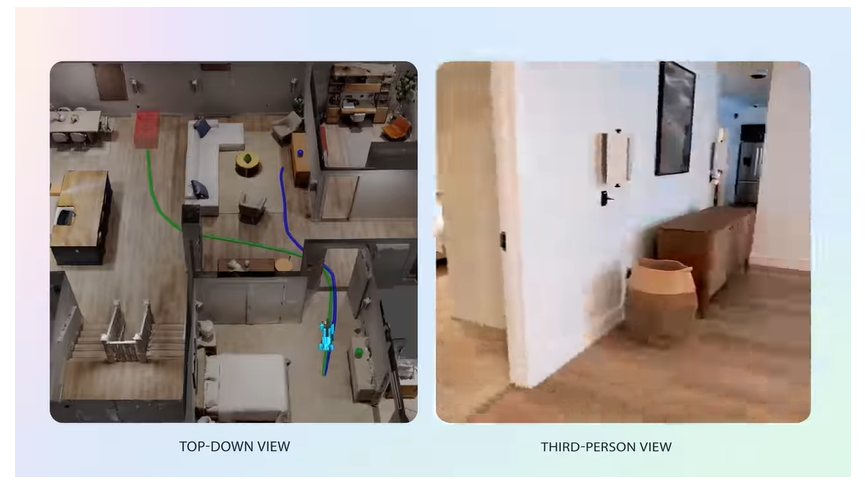

使用 Habitat 模拟器以及 HM3D 和 ReplicaCAD 数据集,其中包括 1,000 个家庭的室内 3D 扫描,我们教一个模拟 Spot 机器人在一个看不见的房子周围移动,捡起不合适的物体,并将它们放在正确的位置. 接下来,我们在现实世界 (sim2real) 中部署此策略零样本,而无需在现实世界中明确构建地图,而是依靠我们的机器人使用其学习的房屋外观概念。

当我们对我们的工作进行测试时,我们使用了两个截然不同的现实世界环境,在这些环境中,Spot 被要求重新布置各种物体——一个家具齐全的 185 平方米公寓和一个 65 平方米的大学实验室。总体而言,ASC 实现了近乎完美的性能,在 60 集中的 59 集中(98%)取得了成功,克服了硬件不稳定、拾取失败以及移动障碍物或阻塞路径等对抗性干扰。相比之下,由于无法从现实世界的干扰中恢复,任务和运动规划等传统基线仅在 73% 的情况下成功。我们还研究了对对抗性扰动的鲁棒性,例如改变环境布局、走在机器人前面以反复阻挡其路径,或在中间移动目标物体。

这为 sim2real 研究扩展到更具挑战性的现实世界任务开辟了道路,例如协助烹饪和清洁等日常任务,甚至是人机协作。我们的工作是朝着可扩展、强大和多样化的未来机器人助手迈出的一步,这些机器人助手可以在开箱即用的新环境中运行,并且不需要昂贵的现实世界数据收集。

重新思考 sim2real 传输

sim2real 学习中最重要的任务之一是建立真实反映机器人在现实世界中行为的仿真模型。然而,这具有挑战性,因为现实世界广阔且不断变化,而模拟器需要捕捉这种多样性。没有模拟器是现实的完美复制品,主要挑战是克服机器人在模拟和现实世界中的表现之间的差距。该领域的默认操作假设是,减少 sim2real 差距涉及创建高物理保真度的模拟器并使用它们来学习机器人策略。

在过去的一年里,我们对 sim2real 采取了一种违反直觉的方法。我们没有构建世界的高保真模拟,而是构建了一个抽象的 Spot 模拟器,它不在模拟中模拟低级物理,并学习可以在更高级别推理的策略(比如去哪里而不是如何去)移动腿)。我们将其称为运动学模拟,其中机器人被传送到一个位置,目标对象连接到机器人手臂上,当它靠近抓手并在视野中时。在现实世界中,波士顿动力控制器用于实现此高级策略所命令的操作。

在 sim2real 中预训练的机器人大多仅限于短距离任务和视觉导航,与环境没有任何交互。移动拾放是一个长周期任务,需要与环境交互,在导航、拾取、放置等不同阶段之间切换。这对强化学习来说通常是非常有挑战性的,需要演示,或者熟练的手-设计奖励。我们的高级抽象和运动学模拟使我们能够学习长期任务,奖励稀少,而无需对低级物理进行推理。

未来的探索领域

虽然我们还没有将视觉皮层应用于我们的物体重排机器人,但我们希望将其集成到一个系统中。现实世界中有如此多不可预测的变量,拥有强大的视觉表现和对展示许多不同活动和环境的大量以自我为中心的视频进行预训练将是朝着构建更好的机器人迈出的重要一步。

语音是我们特别感兴趣探索的一个领域。例如,可以集成自然语言处理而不是提供任务定义,这样某人就可以用他们的声音告诉他们的助手从餐厅拿走盘子并将它们移到厨房水槽。我们还想探索我们的机器人如何更好地与人相处,例如预测他们的需求并帮助他们完成多步骤任务,例如烤蛋糕。

这些只是需要更多研究和探索的众多领域中的一部分。我们相信,凭借在以自我为中心的视频中预先训练的强大视觉皮层和在模拟中预先训练的视觉运动技能,这些进步有一天可以成为人工智能体验的基石,在这种体验中,虚拟助手和物理机器人可以帮助人类并与虚拟和物理无缝交互世界。

阅读论文:自适应技能协调 (ASC)

论文摘要:我们介绍了自适应技能协调 (ASC)——一种完成长期任务的方法(例如,移动拾取和放置,包括导航到一个对象、拾取它、导航到另一个位置、放置它、重复)。ASC 由三个部分组成——(1) 一个基本的视觉运动技能库(导航、拾取、放置),(2) 一个技能协调策略,它选择什么时候适合使用哪些技能,以及 (3) 一个适应前的纠正策略- 当感知到分布外状态时训练有素的技能。ASC 的所有组件仅依赖于板载视觉和本体感知,无需访问预制地图或精确对象位置等特权信息,从而简化了现实世界的部署。我们在模拟的室内环境中训练 ASC,并在波士顿动力 Spot 机器人上的两个新颖的真实环境中零射击部署它。ASC 在移动拾取和放置方面实现了近乎完美的性能,在 59/60 (98%) 集中成功,而顺序执行技能仅在 44/60 (73%) 集中成功。它对交接错误、环境布局变化、动态障碍(例如人)和意外干扰具有鲁棒性,使其成为复杂、长期任务的理想框架。

阅读论文:视觉皮层

论文摘要:我们对 Embodied AI 的预训练视觉表示 (PVR) 或视觉“基础模型”进行了最大、最全面的实证研究。首先,我们策划了 CortexBench,它由 17 项不同的任务组成,涵盖运动、导航、灵巧和移动操作。接下来,我们系统地评估现有的 PVR,发现没有一个具有普遍优势。为了研究预训练数据规模和多样性的影响,我们将来自 7 个不同来源(超过 560 万张图像)的超过 4,000 小时的以自我为中心的视频与 ImageNet 相结合,使用掩码自动编码 (MAE) 在切片上训练不同大小的视觉转换器这个数据。与之前工作的推论相反,我们发现扩展数据集的大小和多样性并不能普遍提高性能(但平均而言)。我们最大的模型,名为 VC-1,平均优于所有先前的 PVR,但也没有普遍占据主导地位。最后,我们展示了 VC-1 的任务或特定领域的适应性带来了实质性的收益,VC-1(适应性的)比 CortexBench 中所有基准测试中最知名的结果具有竞争力或更好的性能。这些模型需要 10,000 多个 GPU 小时来训练,并且可以在我们的网站上找到以供研究社区使用。

获取视觉皮层代码

我们要感谢以下人员的贡献:

视觉皮层:Arjun Majumdar、Karmesh Yadav、Sergio Arnaud、Yecheng Jason Ma、Claire Chen、Sneha Silwal、Aryan Jain、Vincent-Pierre Berges、Pieter Abbeel、Jitendra Malik、Yixin Lin、Oleksandr Maksymets 和 Aravind Rajeswaran

自适应技能协调:Naoki Yokoyama、Alexander William Clegg、Eric Undersander、Sergio Arnaud、Jimmy Yang 和 Sehoon Ha

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง