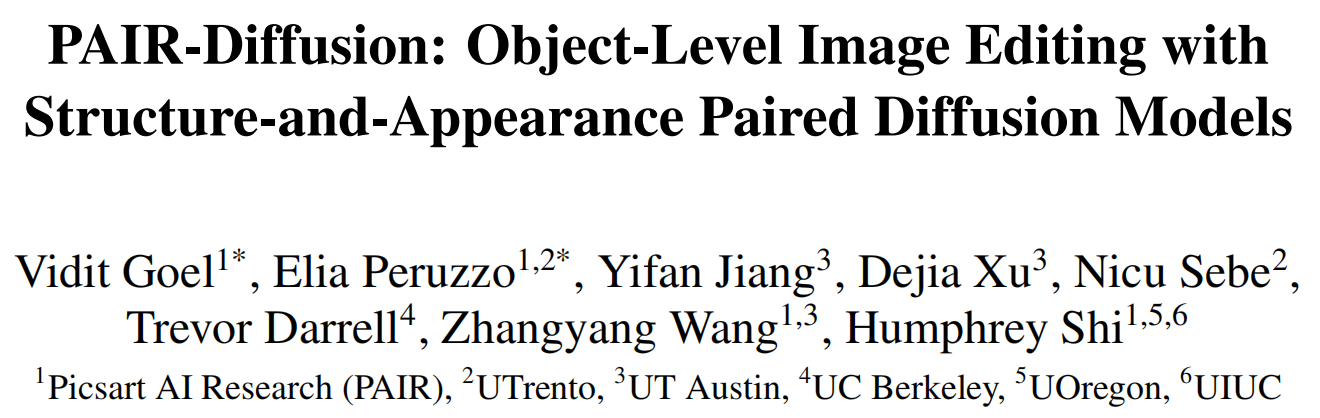

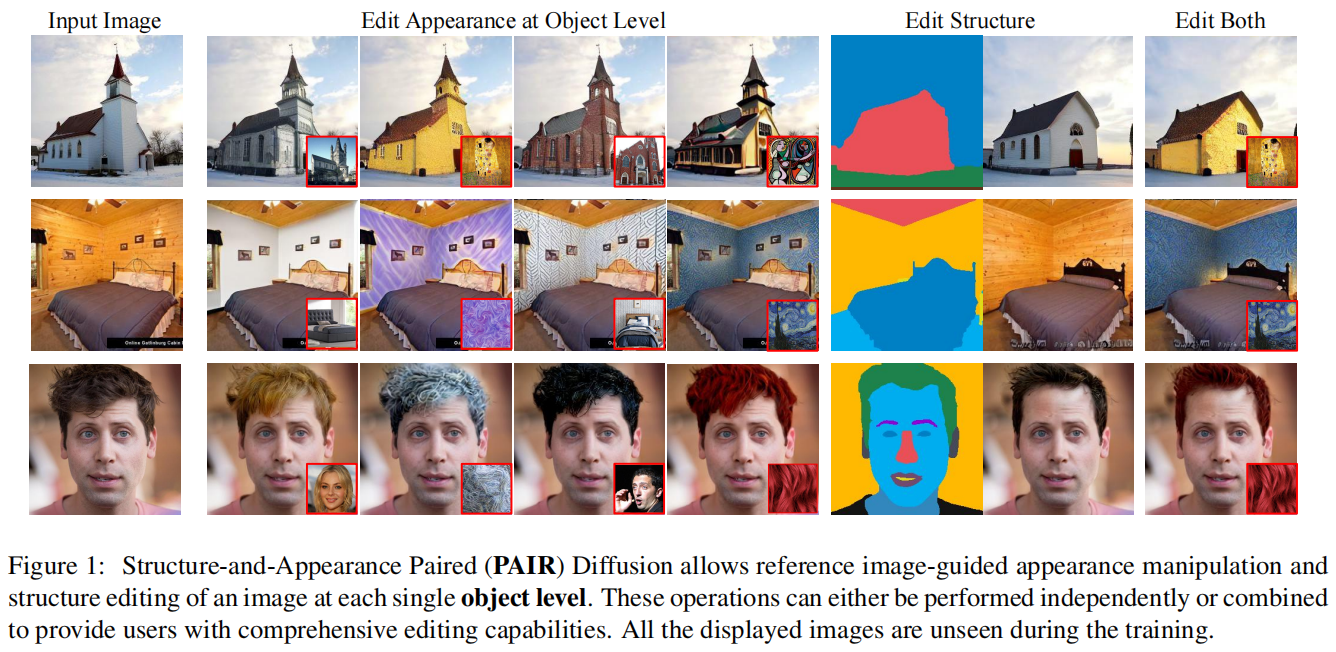

最近,使用扩散模型进行图像编辑已经经历了极快的增长。以前的作品有各种方法来控制和编辑图像。一些作品使用高级条件,如文本,而其他作品使用低级条件。然而,大多数作品都缺乏对图像中不同对象属性的细粒度控制,即对象级别的图像编辑。在本文中,作者将图像视为由多个对象组成,每个对象都由各种属性定义。在这些属性中,作者认为结构和外观是最直观和最有用的编辑目的。作者提出了结构和外观配对扩散模型(PAIR-Diffusion),该模型使用明确提取自图像的结构和外观信息进行训练。所述模型使用户可以在对象级别和全局级别将参考图像的外观注入到输入图像中。此外,PAIR-Diffusion允许编辑结构,同时保持图像各个组成部分的样式不变。作者在LSUN数据集和CelebA-HQ人脸数据集上进行了广泛的评估,并展示了在对象级别上对结构和外观的细粒度控制。作者还应用了该方法到Stable Diffusion,以在对象级别上编辑任何真实图像。

总结:本文提出了一种名为PAIR-Diffusion的图像编辑方法,利用结构和外观配对扩散模型进行对象级别的编辑。该方法使用深度学习技术来学习结构和外观的联合分布,并通过扩散过程来实现图像编辑。与现有方法相比,PAIR-Diffusion在编辑质量和效率方面都具有优势。该方法可以在不需要先前手动分割对象的情况下实现对象级别的编辑,并且可以保留图像的真实感和自然感。实验结果表明,该方法在各种图像编辑任务上都表现出色,并可以灵活地应用于不同类型的图像。

标题:PAIR-Diffusion: Object-Level Image Editing with Structure-and-Appearance Paired Diffusion Models

作者:Vidit Goel, Elia Peruzzo, Yifan Jiang, Dejia Xu, Nicu Sebe, Trevor Darrell, Zhangyang Wang, Humphrey Shi

代码:https://github.com/Picsart-AI-Research/PAIR-Diffusion

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง