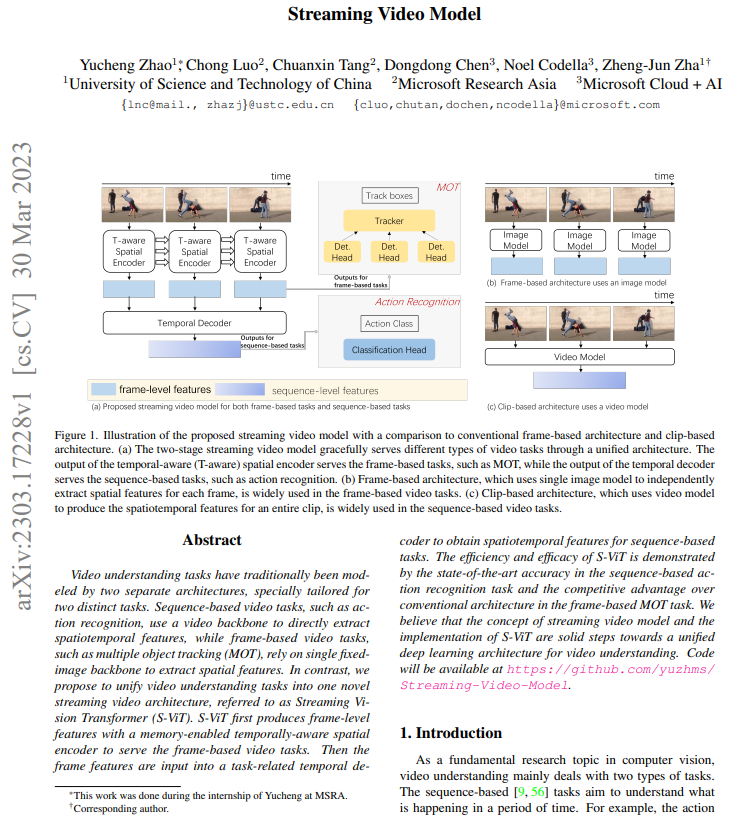

【推荐理由】传统视频理解任务通常由两种独立的架构进行建模,而本文将视频理解任务统一为一种新型的流式视频架构s-ViT,作者认为流式视频模型的概念和S-ViT的实现有利于实现视频理解的统一深度学习架构。

Streaming Video Model

Yucheng Zhao, Chong Luo, Chuanxin Tang, Dongdong Chen, Noel Codella, Zheng-Jun Zha

【论文链接】https://arxiv.org/pdf/2303.17228.pdf

【项目链接】https://github.com/yuzhms/Streaming-Video-Model

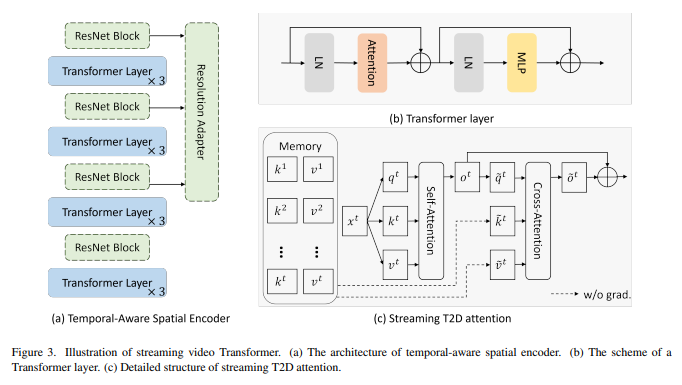

【摘要】传统上,视频理解任务通常由两种独立的架构进行建模,专门用于两个不同的任务。基于序列的视频任务(例如动作识别)使用视频主干直接提取时空特征,而基于帧的视频任务(例如多目标跟踪)则依赖于单个固定图像主干提取空间特征。相比之下,作者提出将视频理解任务统一为一种新型的流式视频架构,称为流式视觉Transformer(S-ViT)。S-ViT首先使用具有内存的时间感知空间编码器生成帧级特征,以服务于基于帧的视频任务。然后将帧特征输入到与任务相关的时间解码器中,以获取用于序列任务的时空特征。S-ViT的效率和功效通过在基于序列的动作识别任务中展示了最先进的准确性,以及在基于帧的MOT任务中展示了与传统架构相比的竞争优势来展示。作者相信流式视频模型的概念和S-ViT的实现是迈向视频理解的统一深度学习架构的坚实步伐。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง