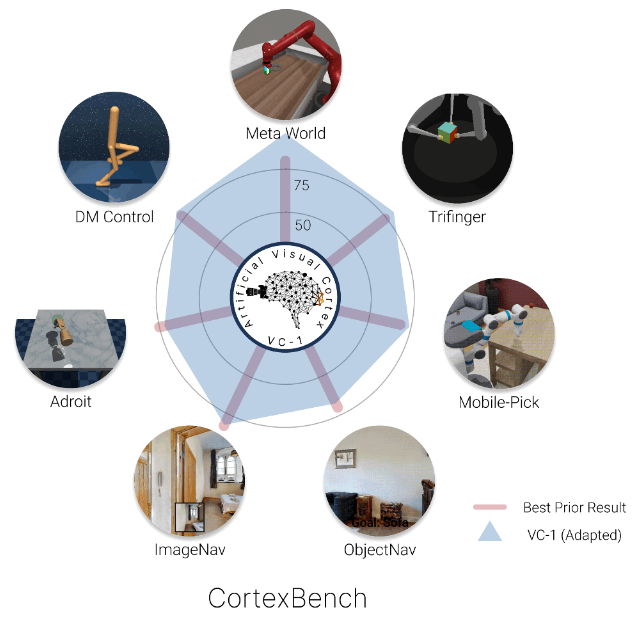

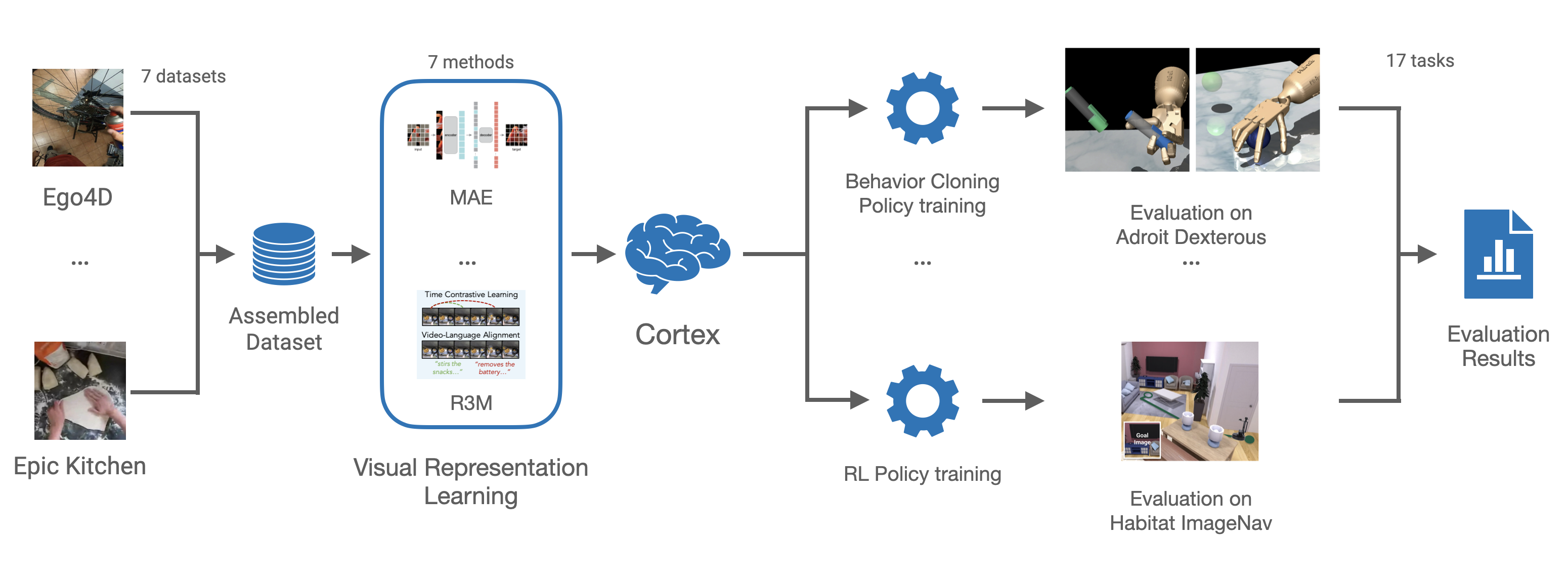

本文提出了最大、最全面的关于预训练视觉表示(PVRs)或视觉“基础模型”在身体感知人工智能方面的实证研究。首先,本文创建了CortexBench,包括17个不同的任务,涵盖了动作、导航、灵巧和移动操作等方面。接着,本文系统地评估了现有的PVRs,并发现没有一个是普遍优越的。为了研究预训练数据规模和多样性的影响,本文将来自7个不同来源的超过4,000个小时的自我中心视频(超过5.6M张图像)和ImageNet结合起来,利用Masked Auto-Encoding(MAE)在这些数据的切片上训练不同尺寸的视觉变压器。与之前的工作推断相反,本文发现数据集规模和多样性的扩展并不普遍提高性能(但平均而言确实如此)。本文最大的模型名为VC-1,在平均性能上优于所有先前的PVRs,但也并非普遍占优。最后,本文展示了VC-1的任务或领域特定适应会带来显著的增益,VC-1(适应)在CortexBench的所有基准测试中都可以达到竞争力或更好的表现。这些模型需要超过10,000个GPU小时来训练,并可在本文的网站上为研究社区提供使用。

标题:Where are we in the search for an Artificial Visual Cortex for Embodied Intelligence?

作者:Arjun Majumdar, Karmesh Yadav, Sergio Arnaud, Jason Ma, Claire Chen, Sneha Silwal, Aryan Jain, Vincent-Pierre Berges, Pieter Abbeel(引用10万+), Jitendra Malik(引用19万+), Dhruv Batra, Yixin Lin, Oleksandr Maksymets, Aravind Rajeswaran, Franziska Meier

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง