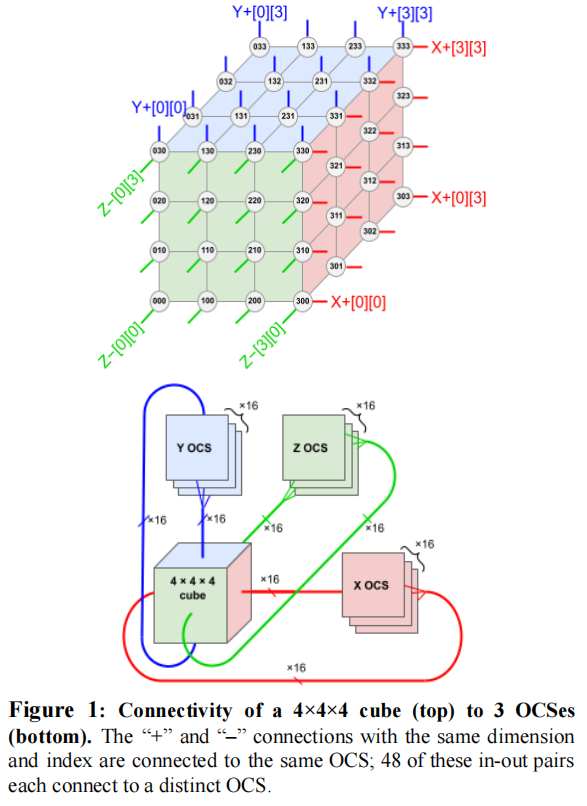

针对机器学习(ML)模型创新,生产工作负载发生了根本和快速变化。TPU v4是Google领域特定体系结构(DSA)的第五代,也是第三代适用于ML模型的超级计算机。光电电路交换机(OCSes)通过动态重新配置其互联拓扑结构,提高了规模、可用性、利用率、模块化、部署、安全、功率和性能;用户可以选择扭曲的3D环带形拓扑结构。OCSes和底层的光学元件比Infiniband更便宜、功耗更低、速度更快,占系统成本的<5%,系统功耗的<3%。每个TPU v4包括稀疏核心,这些数据流处理器可以将嵌入依赖的模型加速5倍至7倍,而只需使用5%的晶片面积和电源。自2020年以来已经部署的TPU v4的性能优于TPU v3,性能/瓦提高了2.7倍。TPU v4超级计算机的规模是TPU v3的4倍,因此总体速度约快10倍,这与OCS的灵活性帮助了大型语言模型。对于相似规模的系统而言,它比Graphcore IPU Bow快约4.3x-4.5x,比Nvidia A100快1.2x-1.7x,并且使用的功率比Nvidia A100低1.3x-1.9x。Google Cloud的节能型仓库规模计算机内部的TPU v4比典型的本地数据中心中的DSAs消耗的能量少约3倍,产生的CO2e少约20倍。

总结:

本文介绍了TPU v4,这是一种针对机器学习应用而设计的超级计算机。TPU v4配备了一种称为“光学重新配置技术”的新型处理器架构,该架构将计算和内存资源的分配进行了优化,从而提高了机器学习的效率和速度。此外,TPU v4还具备硬件支持嵌入式矩阵运算的功能,从而使得处理嵌入式向量数据变得更加高效。这篇论文详细介绍了TPU v4的架构、性能和优化策略,并探讨了它在机器学习和深度学习领域的应用前景。总的来说,TPU v4的出现代表了超级计算机在机器学习领域应用的新里程碑,具有重要的研究和实际应用价值。

作者:Norman P. Jouppi, George Kurian, Sheng Li, Peter Ma, Rahul Nagarajan, Lifeng Nai, Nishant Patil, Suvinay Subramanian, Andy Swing, Brian Towles, Cliff Young, Xiang Zhou, Zongwei Zhou, David Patterson

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง