【推荐理由】文章提出了一种新方法可以从单目RGB视频中学习高质量的隐式3D头像。该方法能够重建高质量的头像,具有更准确的表情依赖细节。

Learning Personalized High Quality Volumetric Head Avatars from Monocular RGB Videos

Ziqian Bai, Feitong Tan, Zeng Huang, Kripasindhu Sarkar, Danhang Tang, Di Qiu, Abhimitra Meka, Ruofei Du, Mingsong Dou, Sergio Orts-Escolano, Rohit Pandey, Ping Tan, Thabo Beeler, Sean Fanello, Yinda Zhang

【论文链接】https://arxiv.org/pdf/2304.01436.pdf

【项目链接】https://augmentedperception.github.io/monoavatar/

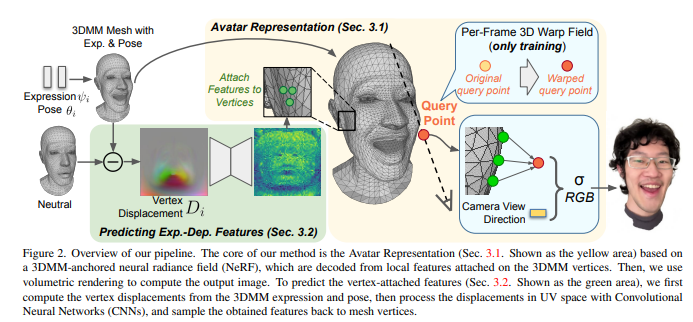

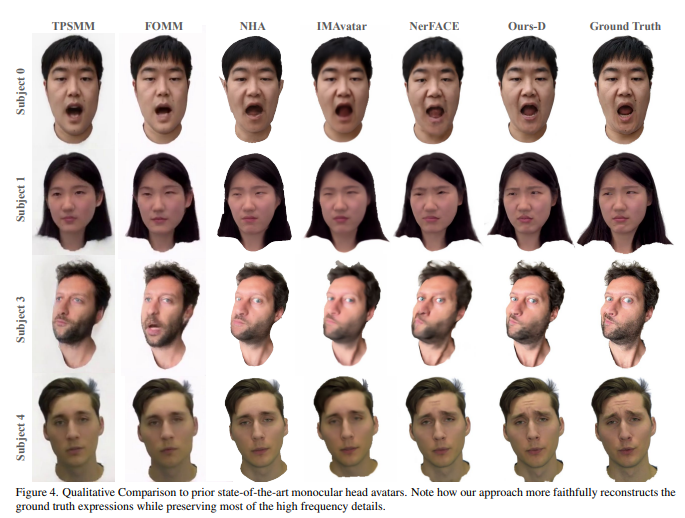

【摘要】本文提出了一种方法,可以从野外捕获的单眼RGB视频中学习高质量的隐式3D头像。学习的头像由参数化面部模型驱动,以实现用户可控的面部表情和头部姿势。我们的混合管道结合了3DMM的几何先验和动态跟踪,以及神经辐射场,以实现精细的控制和逼真的效果。为了减少过度平滑和改善模型外表情的综合,我们建议预测锚定在3DMM几何上的局部特征。这些学习特征由3DMM变形驱动,并在3D空间中进行插值,以产生指定查询点的体积辐射。文章进一步表明,在UV空间中使用卷积神经网络是关键的,可以整合空间上下文并产生代表性的局部特征。广泛的实验表明,本方法能够重建高质量的头像,具有更准确的表情相关细节,对训练之外的表情具有良好的泛化能力,并且与其他最先进的方法相比,在定量上呈现出更优的渲染效果。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง