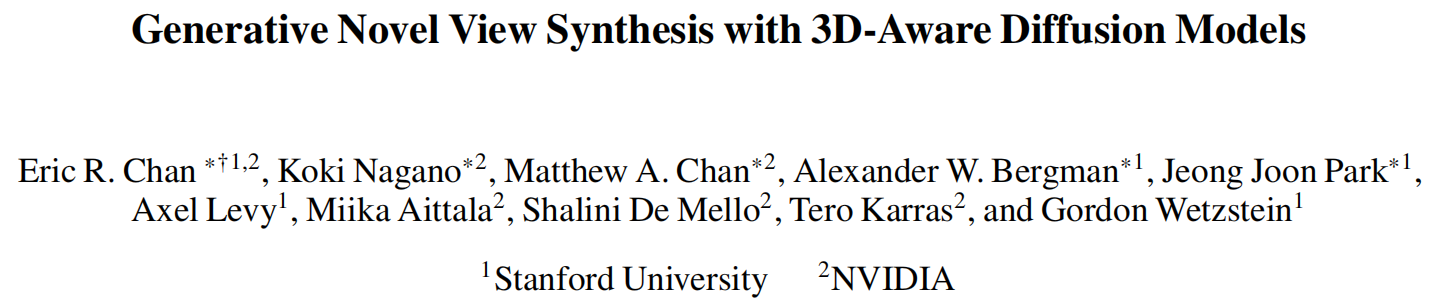

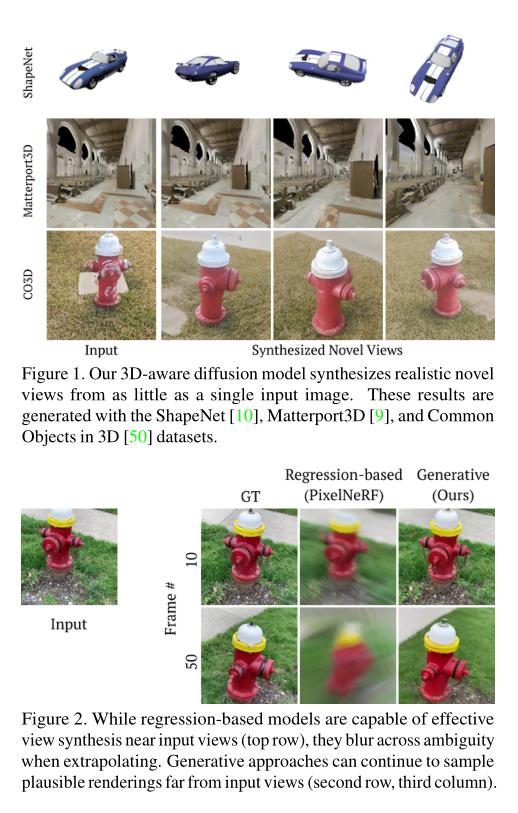

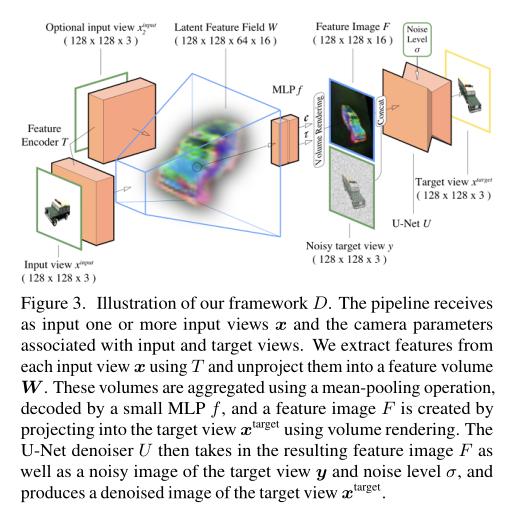

本文提出了一种基于扩散模型的方法,用于从一张输入图像中生成具有三维感知的新视角合成,甚至只需要一张图像。本文的模型从可能的合乎逻辑的渲染分布中进行采样,即使存在歧义,也能够生成多样化而可信的新视角。为了实现这一点,本文的方法利用现有的2D扩散骨干,但是关键在于通过一个三维特征体积引入了几何先验。该潜在特征场捕捉了可能的场景表示分布,并提高了本文的方法生成具有视角一致性的新渲染图像的能力。除了生成新视角,本文的方法还具有自回归地合成三维一致序列的能力。本文展示了在合成渲染和房间规模场景方面达到了最先进的结果。本文还展示了在具有挑战性的真实世界对象中产生了引人注目的结果。

总结:

该研究提出了一种新的方法,用于基于单张图像生成逼真的三维场景视图。该方法使用3D感知扩散模型(3D-aware diffusion models)来学习生成器和噪声得分函数,从而在保证逼真性和一致性的同时,实现高效的图像生成。在这个方法中,生成器使用条件生成技术,将三维表示与二维视图联系起来。而噪声得分函数则用于将生成器中的噪声与外部条件结合起来。为了充分考虑三维场景的结构信息,研究还提出了一种可微可逆的视图变换,从而使得生成器可以在不同视角下生成真实的三维场景视图。该方法在多组真实场景数据集上进行了实验,结果表明其在视觉质量、多样性和计算复杂度方面均优于现有的方法。

标题:Generative Novel View Synthesis with 3D-Aware Diffusion Models

作者:Eric R. Chan, Koki Nagano, Matthew A. Chan, Alexander W. Bergman, Jeong Joon Park, Axel Levy, Miika Aittala, Shalini De Mello, Tero Karras, Gordon Wetzstein

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง