【推荐理由】本文提出了一个新颖的任务,通过音乐文本集成驱动的3D舞蹈生成。 实验表明,该方法可以生成基于文本和音乐条件的逼真和连贯的舞蹈动作,同时保持与两个单一模态相当的性能。

TM2D: Bimodality Driven 3D Dance Generation via Music-Text Integration

Kehong Gong, Dongze Lian, Heng Chang, Chuan Guo, Xinxin Zuo, Zihang Jiang, Xinchao Wang

[National University of Singapore & Tsinghua University & University of Alberta]

【论文链接】https://arxiv.org/pdf/2304.02419.pdf

【项目链接】https://garfield-kh.github.io/TM2D/

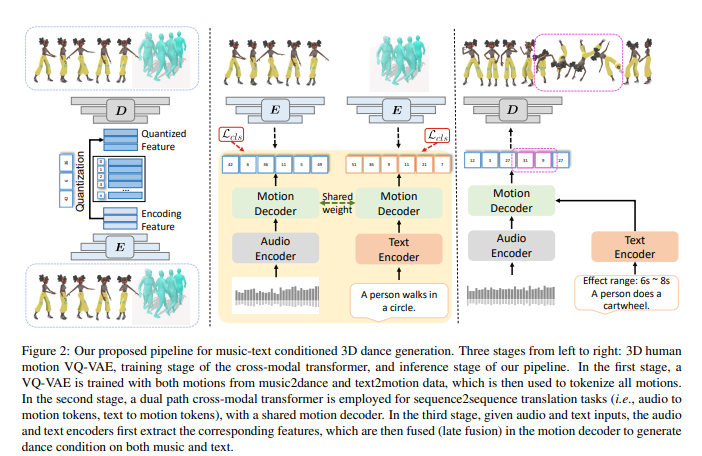

【摘要】本文提出了一个新颖的任务,即生成同时融合文字和音乐两种模态的3D舞蹈动作。与现有的使用单一模态(如音乐)生成舞蹈动作的作品不同,本文的目标是生成更丰富的舞蹈动作,以文字提供的指示信息为指导。然而,缺乏同时具有音乐和文字模态的配对运动数据限制了生成同时融合两者的舞蹈动作的能力。为了解决这个挑战,作者提出利用3D人体运动VQ-VAE将这两个数据集的运动投影到由量化向量组成的潜在空间中,有效地将来自不同分布的运动令牌混合到一起进行训练。此外,文章提出了跨模态变换器,将文本指令集成到运动生成结构中,以生成同时融合两者的3D舞蹈动作,而不会降低基于音乐的舞蹈生成的性能。为了更好地评估生成动作的质量,作者引入了两个新颖的指标,即运动预测距离(MPD)和冻结分数,以衡量生成动作的连贯性和冻结百分比。广泛的实验表明,该方法可以生成基于文字和音乐的真实和连贯的舞蹈动作,并保持与两种单一模态相当的性能。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง