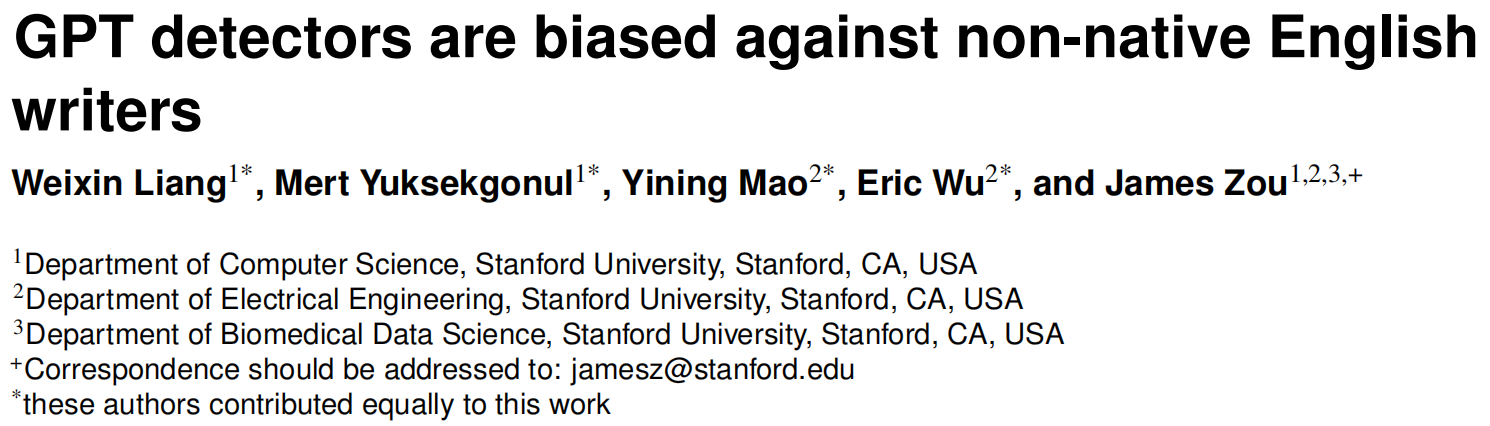

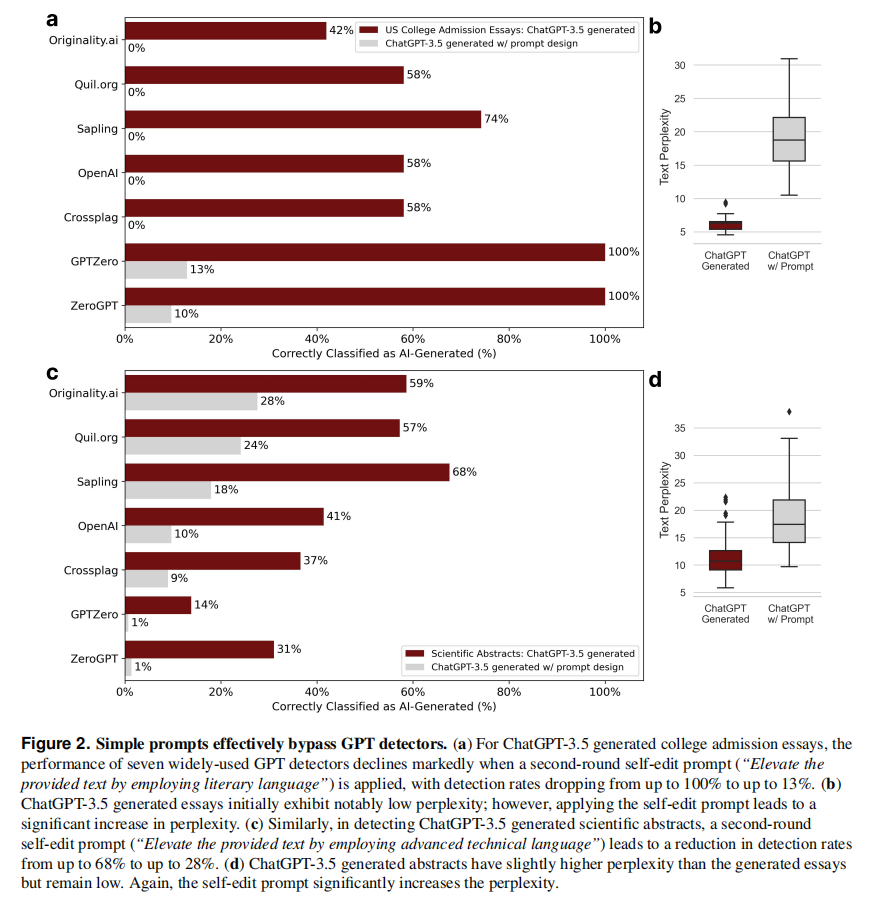

生成式语言模型的快速采用已经带来了数字交流方面的实质性进展,同时也引起了人们对人工智能生成内容潜在滥用的担忧。虽然已经提出了许多检测方法来区分人工智能和人类生成的内容,但这些检测器的公正性和鲁棒性仍然未得到充分探讨。在本研究中,我们使用来自母语和非母语英语写作者的写作样本评估了几种广泛使用的GPT检测器的性能。我们的研究结果显示,这些检测器一致地将非母语英语写作样本误分类为人工智能生成的,而母语写作样本则能够被准确识别。此外,我们证明简单的提示策略不仅能够缓解这种偏见,而且还能有效地绕过GPT检测器,这表明GPT检测器可能无意中惩罚语言表达受限的作者。我们的研究呼吁人们广泛讨论ChatGPT内容检测器部署的伦理意义,并警告人们在评估或教育设置中谨慎使用这些检测器,特别是当它们可能会无意中惩罚或排除非母语英语说话者参与到全球讨论中时。

标题:GPT detectors are biased against non-native English writers

作者:Weixin Liang, Mert Yuksekgonul, Yining Mao, Eric Wu, James Zou

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง