【推荐理由】本文对视频语言预训练模型(VidL)进入了深入的研究,揭示了VidL模型设计中最重要的因素。包括:时间建模、视频到文本多模态融合、屏蔽建模目标和图像和视频的联合训练。

VINDLU : A Recipe for Effective Video-and-Language Pretraining

Feng Cheng,Xizi Wang,Jie Lei,David Crandall,Mohit Bansal,Gedas Bertasius

[UNC Chapel Hill & Indiana University]

【论文链接】https://arxiv.org/pdf/2212.05051.pdf

【项目链接】https://github.com/klauscc/VindLU

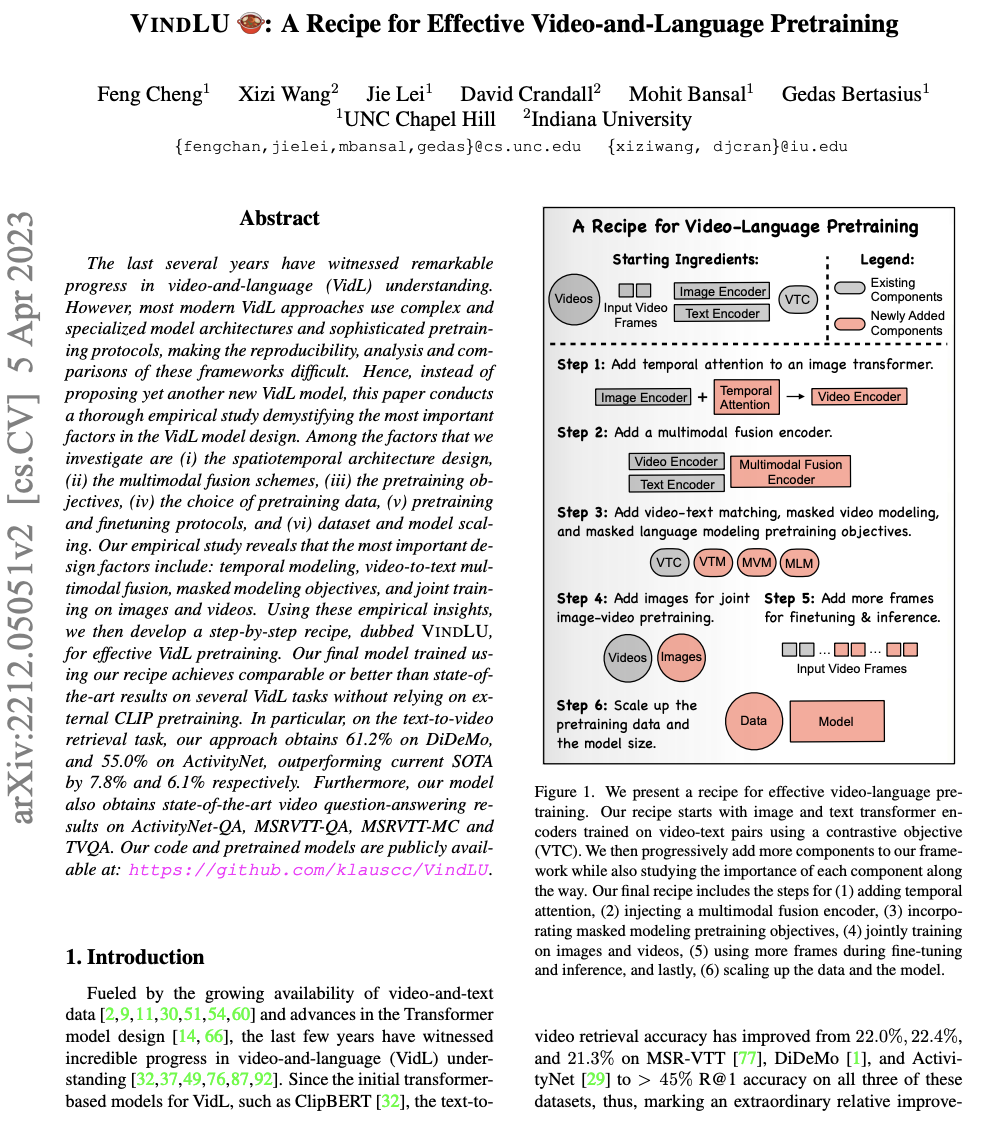

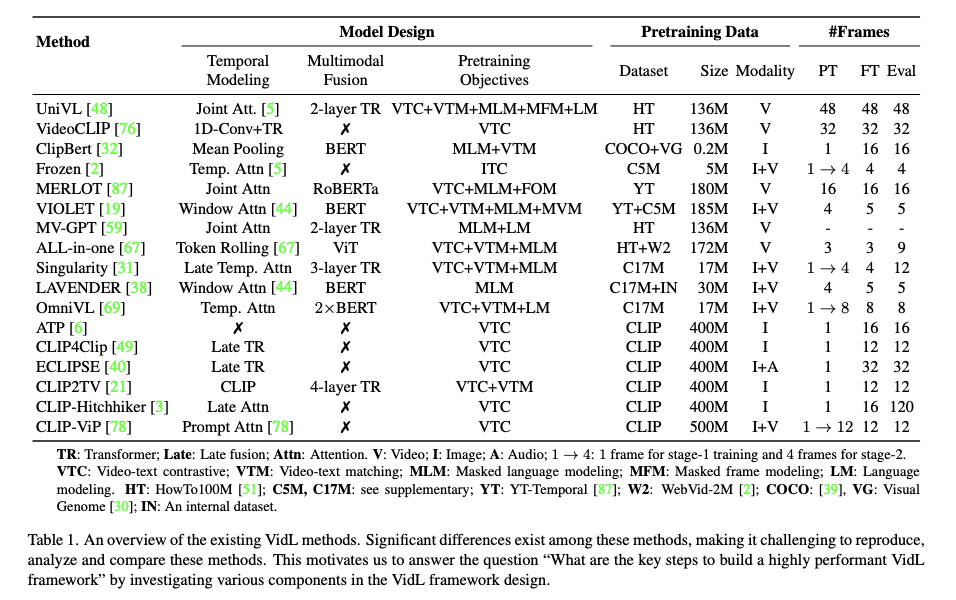

【摘要】近几年来,在视频与语言(VidL)理解方面取得了显著进展。然而,大多数现代的VidL方法使用复杂和专门的模型架构以及复杂的预训练方案,使得这些框架的可重复性、分析和比较变得困难。因此,本文不是提出另一种新的VidL模型,而是进行了深入的经验研究,揭示了VidL模型设计中最重要的因素。我们调查的因素包括(i) 时空架构设计,(ii) 多模态融合方案,(iii) 预训练目标,(iv) 预训练数据选择,(v) 预训练和微调协议,以及 (vi) 数据集和模型缩放。文章的实证研究揭示了最重要的设计因素包括:时间建模、视频到文本多模态融合、屏蔽建模目标和图像和视频的联合训练。基于这些经验的见解,作者制定了一个逐步实践的配方,称为VINDLU,用于有效的VidL预训练。本文使用该配方训练的最终模型,在几个VidL任务上达到了可以与最先进的结果相媲美甚至更好的表现,而无需依赖外部的CLIP预训练。特别是在文本到视频检索任务上,我们的方法在DiDeMo上取得了61.2%的准确率,在ActivityNet上达到了55.0%的准确率,分别比目前的SOTA高出7.8%和6.1%。此外,该模型还在ActivityNet-QA、MSRVTT-QA、MSRVTT-MC和TVQA等任务上获得了最先进的视频问答结果。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง