标题:Neural Volumetric Memory for Visual Locomotion Control

作者:

腿部运动的体积记忆

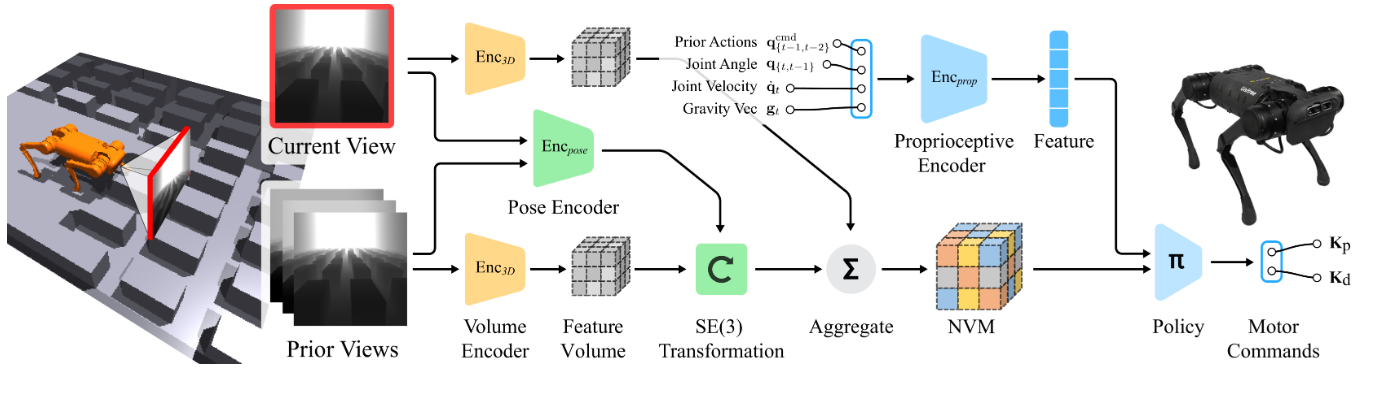

使用以自我为中心的相机视图的腿部运动本质上是一个部分观察到的问题。为了使控制问题切实存在,我们的机器人需要聚合来自先前帧的信息并正确推断其下方的遮挡地形。在运动过程中,直接安装在机器人底盘上的摄像头会发生大而虚假的姿态变化,这使得将各个帧集成到一个连贯的表示中变得非常重要。为了解释这些相机姿势变化,我们提出了神经体积记忆 (NVM) — 场景特征的 3D 表示格式。它以一系列视觉观察作为输入,并输出表示周围 3D 结构的单个 3D 特征体积。

通过自我监督学习 NVM

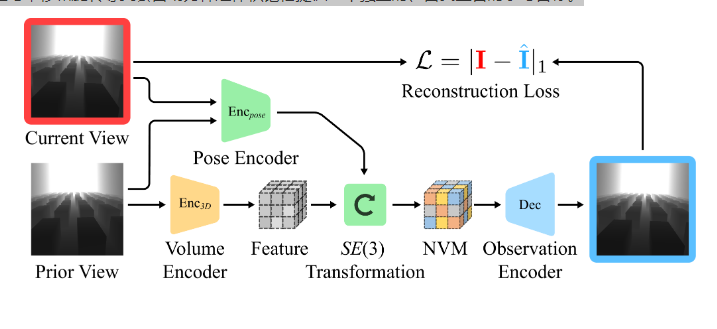

虽然行为克隆目标足以产生一个好的策略,但与平移和旋转等变会自动为神经体积记忆提供一个独立的、自我监督的学习目标。

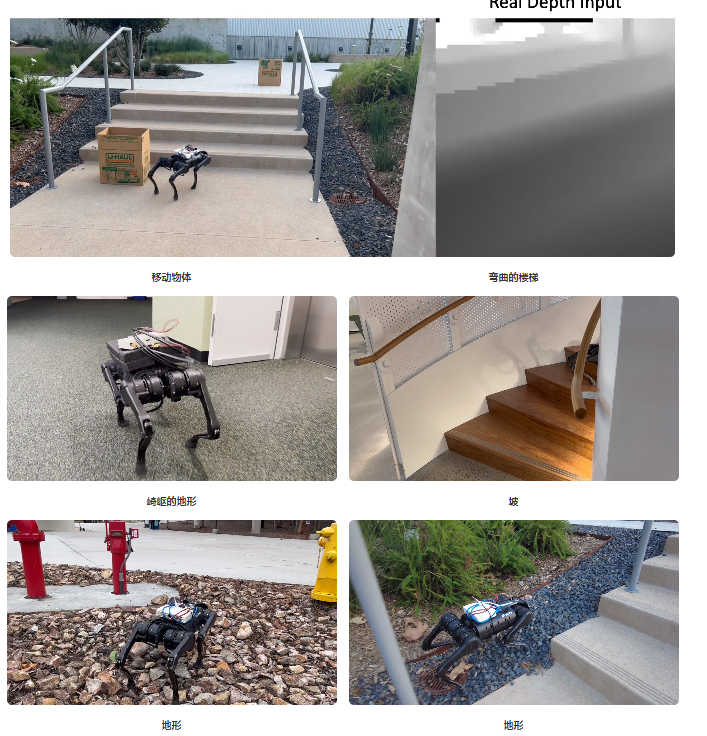

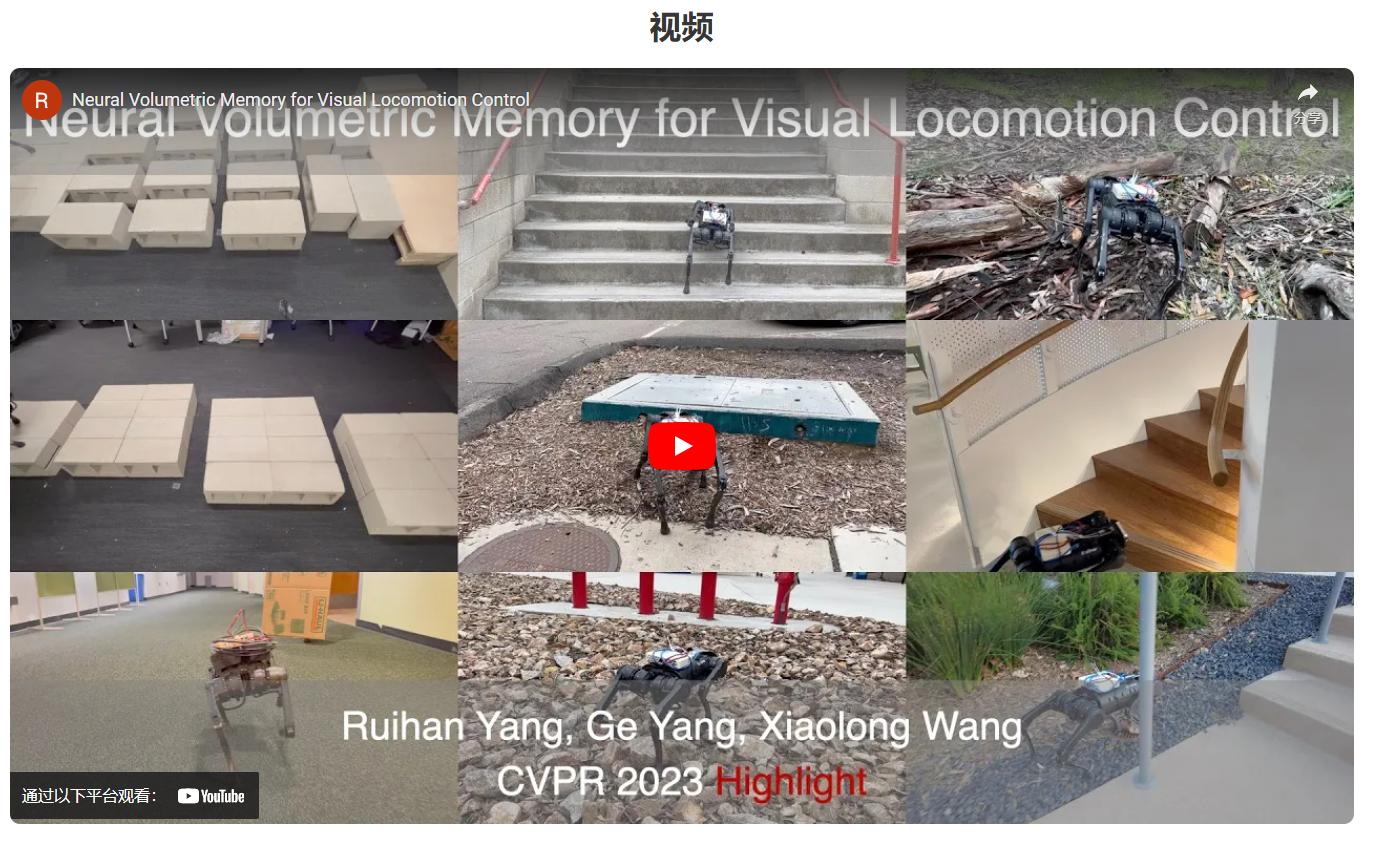

现实世界中的可视化

我们对所有不同的场景使用相同的策略。

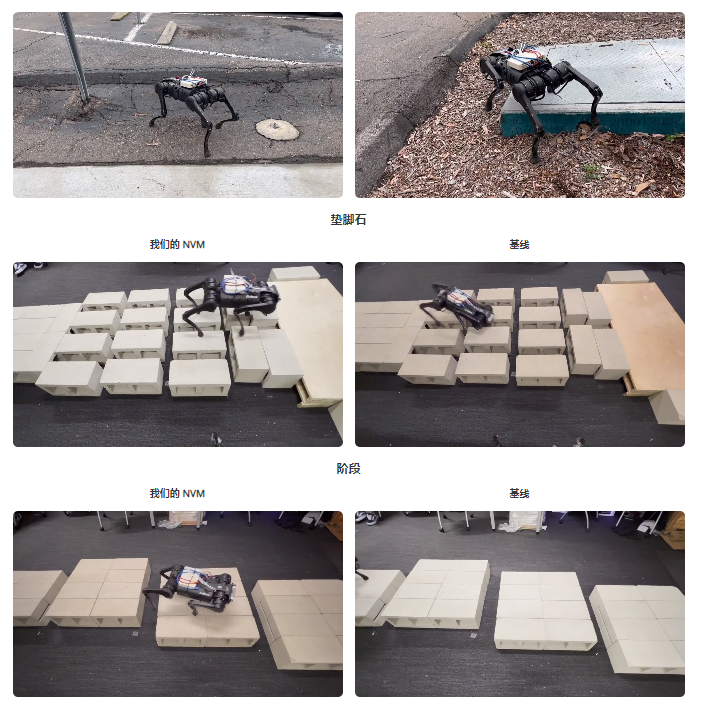

为了在模拟之外的不同真实世界场景中验证我们的方法,我们在有垫脚石的室内场景和野外场景中进行了真实世界的实验。

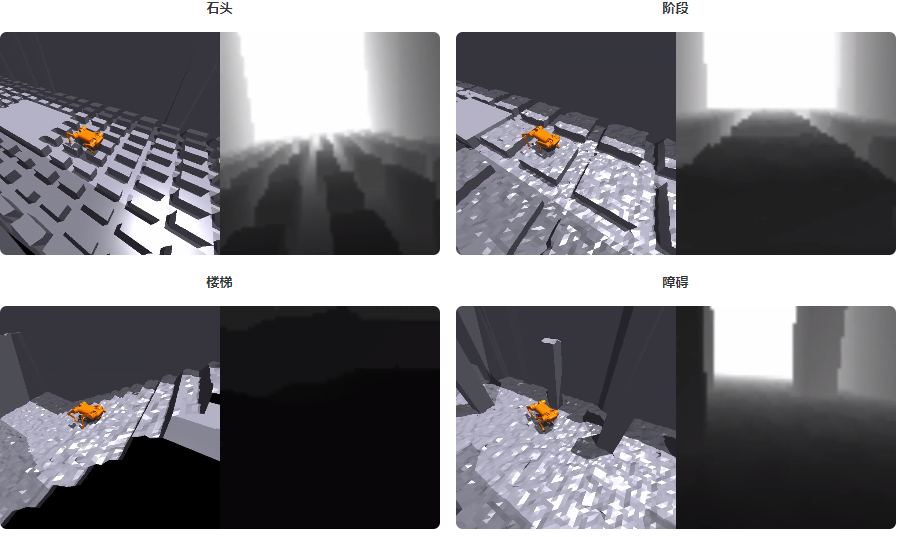

我们在不同现实场景中的 NVM 代理

有障碍的楼梯

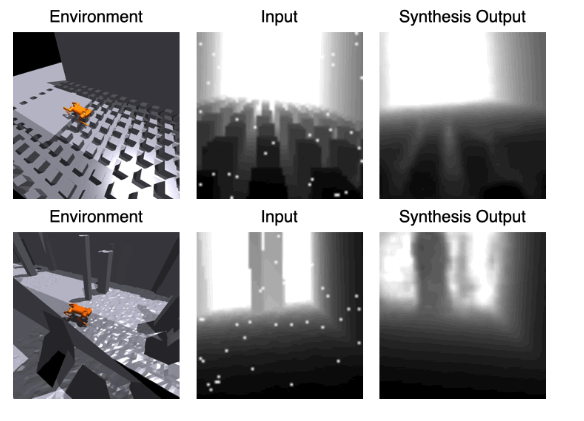

学习解码器的视觉重建

我们在自我监督任务中可视化合成的视觉观察。对于每个元组,第一个图像显示机器人在环境中移动,第二个图像是输入视觉观察,第三个图像是使用 3D 特征量和估计的相对相机的合成视觉观察。对于输入视觉观察,我们对图像应用大量数据增强以提高模型的鲁棒性。

模拟中的可视化

为了了解通过我们的方法学习的策略在模拟环境中的行为方式,我们将一组具有代表性的事件和通过我们的方法学习的策略做出的相应决策可视化。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง