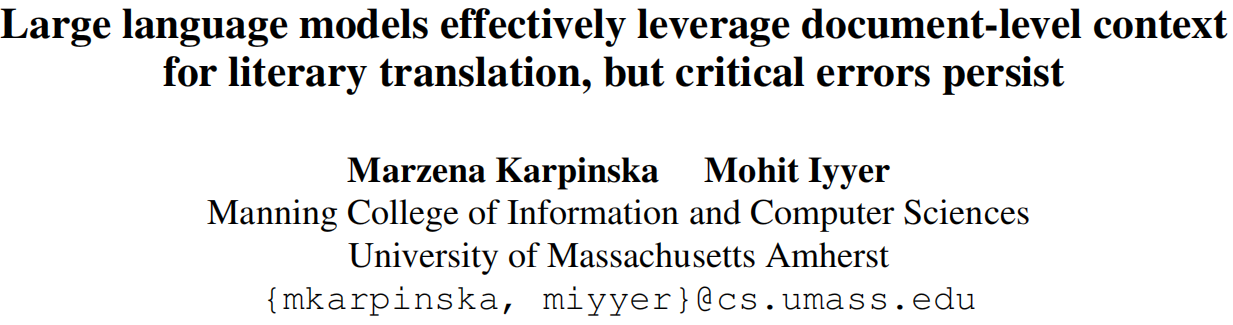

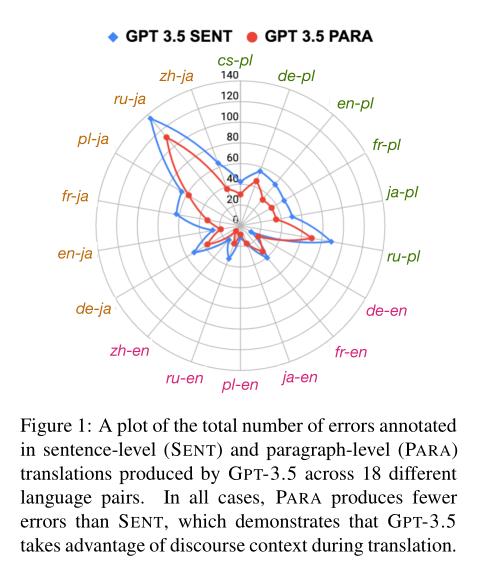

大型语言模型(LLM)在广泛的句子级翻译数据集上具有竞争力。然而,它们在段落和文档翻译方面的能力尚未被探索,因为对于这些设置来说评估是昂贵且困难的。我们通过严格的人类评估表明,直接要求GPT-3.5(text-davinci-003)LLM一次翻译整个文学段落(例如,从小说中)会比标准的逐句翻译在18种语言的语言对(例如,日语、波兰语和英语的翻译)上产生更高质量的翻译。我们的评估大约需要350小时的注释和分析工作,通过聘请能够流利掌握源语言和目标语言的翻译人员,并要求他们提供跨度级别的错误注释以及哪个系统的翻译更好的偏好判断来进行。我们观察到,基于话语层面的LLM翻译比基于句子级别的方法有更少的错误、语法错误和风格不一致。然而,关键性的错误仍然存在,包括偶尔的内容遗漏,人工翻译人员的干预仍然是必需的,以确保作者的声音保持完整。为促进未来文学文档级翻译评估的研究,我们公开发布了我们的数据集和错误注释。

总结:

该论文表明,大型语言模型(LLM)在文学翻译方面有效地利用了文档级上下文,但仍存在关键性错误。通过严格的人类评估,研究者发现,直接要求LLM一次翻译整个文学段落(而不是逐句翻译)可以提高翻译的质量。但是,虽然基于话语层面的LLM翻译比基于句子级别的方法有更少的错误、语法错误和风格不一致,但仍然存在内容遗漏等关键性错误,因此人工翻译人员的干预仍然是必需的。该论文公开了数据集和错误注释,以促进未来文学文档级翻译评估的研究。

作者:Marzena Karpinska, Mohit Iyyer

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง