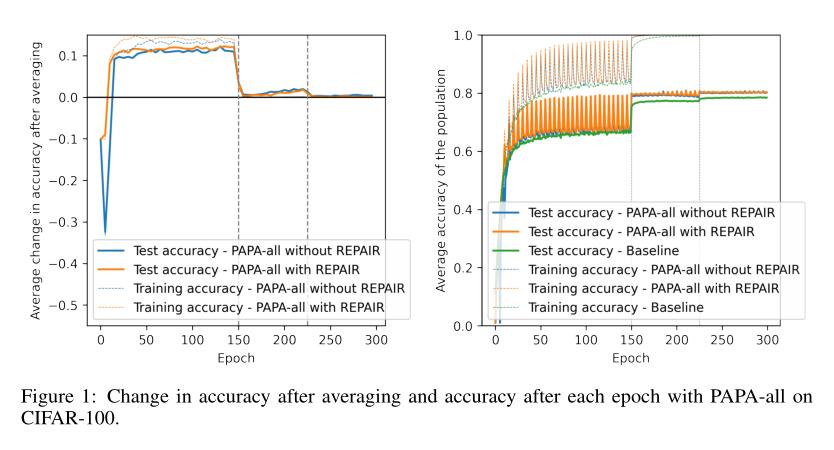

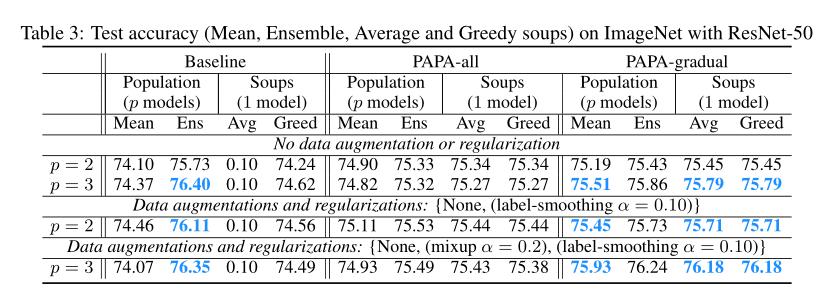

集成方法通过将多个模型的预测相结合以提高性能,但在推理时需要付出显著更高的计算代价。为避免这些代价,可以通过平均它们的权重(模型汤)将多个神经网络组合成一个网络。然而,这通常比集成方法表现更差。 在权重或特征空间中,只有当权重足够相似(在网络之间)才能进行有效的平均,同时又足够不同,以从组合中获得益处时,权重平均才是有益的。基于这个想法,我们提出了PopulAtion Parameter Averaging(PAPA)方法:将集成的广泛性与权重平均的效率结合起来。PAPA利用多样化的模型群体(通过在不同的数据顺序,增强和正则化方案上进行不同的训练),而且偶尔(不太频繁,不太稀少)用群体的平均权重替换网络的权重。PAPA缩小了平均和集成之间的性能差距,在CIFAR-10上将模型群的平均精度提高了1.1%,在CIFAR-100上提高了2.4%,而在ImageNet上提高了1.9%。与训练独立的非平均模型相比,表现更优。

总结:

PopulAtion Parameter Averaging(PPA)是一种分布式机器学习训练方法,它通过集合多个模型的权重来产生一个新的模型。该模型聚合过程使用全局模型和本地模型的平均值来平衡全局和本地计算的能力。该方法可以实现比传统集中式训练更优的模型,同时也具有较低的通信和计算成本。顾名思义,PPA是通过对群体的参数进行加权平均来实现模型的进化,最终得到一个比单个模型更具性能和鲁棒性的模型。该方法在推理应用和机器学习培训方面具有广泛的应用。

标题:PopulAtion Parameter Averaging (PAPA)

作者:Alexia Jolicoeur-Martineau, Emy Gervais, Kilian Fatras, Yan Zhang, Simon Lacoste-Julien

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง