【推荐理由】本文将预训练视觉大模型在没有任何音频预训练的情况下成功推广到视听数据。

Vision Transformers are Parameter-Efficient Audio-Visual Learners

Yan-Bo Lin, Yi-Lin Sung, Jie Lei, Mohit Bansal (LXMERT作者之一), Gedas Bertasius

[Department of Computer Science, UNC Chapel Hill]

【论文链接】https://arxiv.org/pdf/2212.07983.pdf

【项目链接】https://genjib.github.io/project_page/LAVISH/

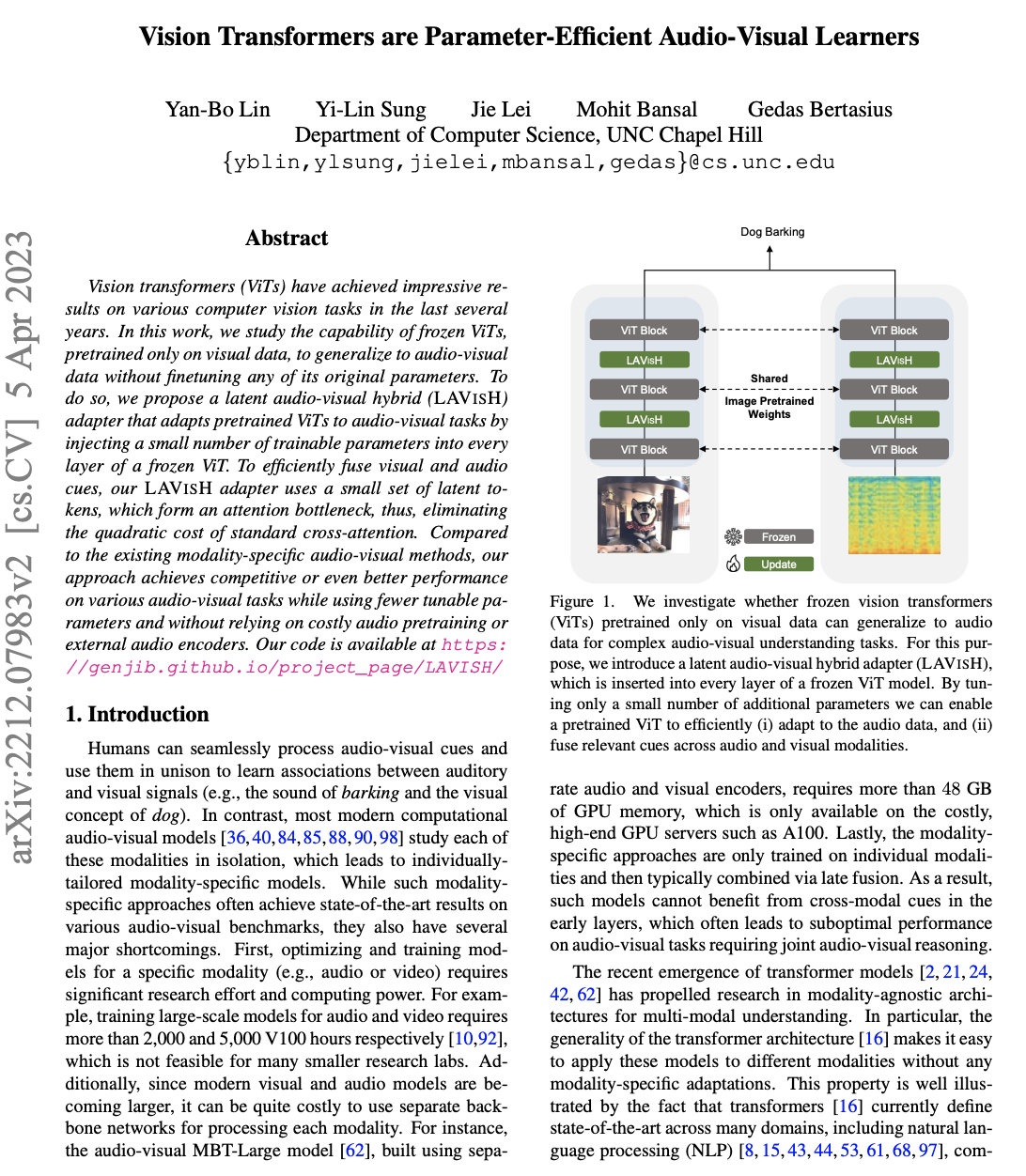

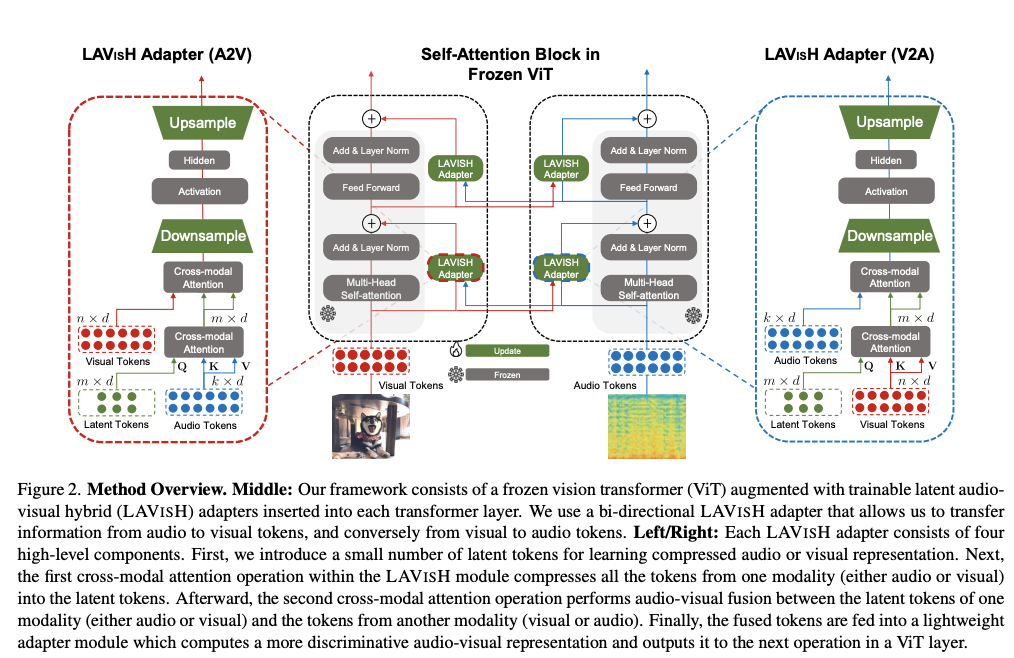

【摘要】在过去的几年中,深度学习在各种计算机视觉任务上取得了显著的成果。本文研究了仅预训练于视觉数据的冻结ViTs在不微调任何原始参数的情况下推广到视听数据的能力。为此,作者提出了一种名为LAVISH的潜在音频-视觉混合适配器,通过向冻结的ViT的每一层注入少量可训练参数来适应预训练的ViTs到视听任务。为了有效地融合视觉和音频提示,文章的LAVISH适配器使用一小组潜在令牌,形成一个注意力瓶颈,从而消除标准交叉注意力的平方成本。与现有的模态特定的音频-视觉方法相比,该方法在使用更少的可调参数且不依赖于昂贵的音频预训练或外部音频编码器的情况下,在各种音频-视觉任务上实现了竞争性甚至更好的性能。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง