【推荐理由】文章提出了一种高效灵活的多模态融合方法,专门为融合单模态预训练transformer而设计。实验结果表明,该方法在可训练参数少于3%,并且训练内存使用量节省高达66%的情况下,可以实现与其他几种多模态大模型微调方法相当的性能。

Efficient Multimodal Fusion via Interactive Prompting

Yaowei Li, Ruijie Quan, Linchao Zhu, Yi Yang

[ReLER, AAII, University of Technology Sydney & CCAI, Zhejiang University]

【论文链接】https://ffmpbgrnn.github.io/publications/pdf/prompt.pdf

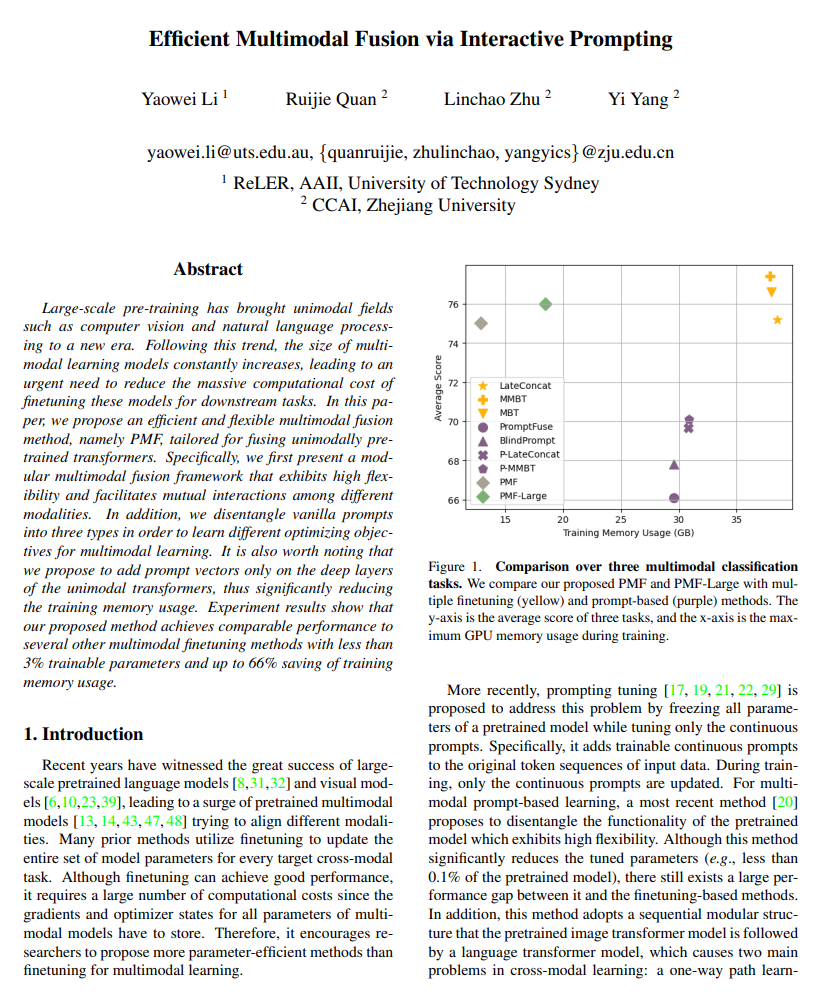

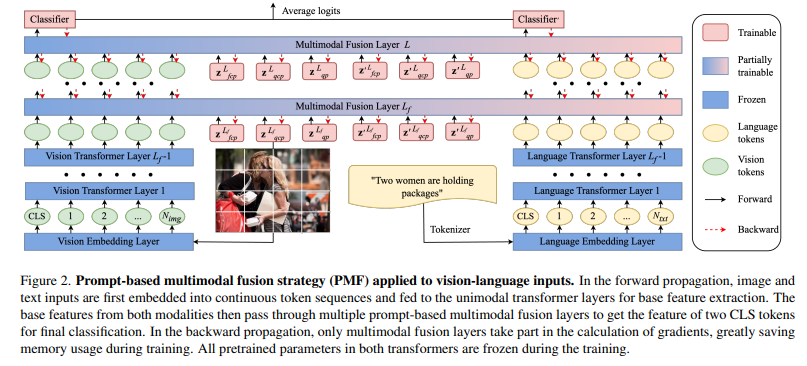

【摘要】大规模预训练技术已经将计算机视觉和自然语言处理等单模态领域带入了一个新时代。随着多模态学习模型的不断增大,迫切需要减少微调这些模型用于下游任务所需的巨大计算成本。本文提出了一种高效灵活的多模态融合方法PMF,专门为融合单模态预训练transformer而设计。具体来说,文章首先提出了一个模块化的多模态融合框架,它具有高度的灵活性,并促进了不同模态之间的相互作用。此外,文章将普通提示分解为三种类型,以便学习不同的多模态学习优化目标。值得注意的是,本文建议仅在单模态transformer的深层中添加提示向量,从而显著减少了训练内存使用。实验结果表明,本文提出的方法在可训练参数少于3%,并且训练内存使用量节省高达66%的情况下,可以实现与其他几种多模态微调方法相当的性能。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง