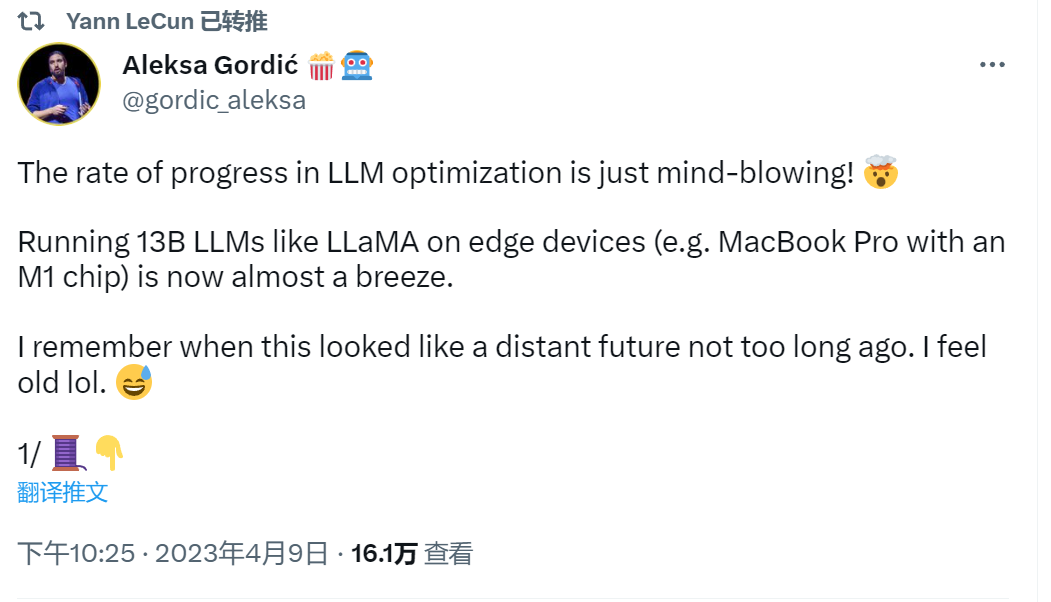

今日,ML & NLP 研究者,前谷歌DeepMind / 微软ML工程师Aleksa Gordić在推特上发布了一条关于大规模语言模型(LLMs)优化的观点帖子。这条内容还得到了图灵奖得主 Yann LeC++un 的转发。

以下是其详细观点:

1. 在边缘设备(例如带有M1芯片的MacBook Pro)上运行像LLaMA这样的13B LLM现在几乎是轻而易举的事。很快我们就能在移动设备上本地运行13B+ LLMs,这只是时间问题。

2. 使所有这些成为可能的第一个重要开源软件工作是由@ggerganov完成的,他的llama.cpp项目(C++ LLaMA端口)。该项目在几周内积累了将近21k的star。

3. 在这里查看:https://github.com/ggerganov/llama.cpp

最新的优化使加载LLaMA快了大约10-100倍!(诀窍是使用mmap)

请查看@JustineTunney的博客以了解更多信息:https://justine.lol/mmap/

同时,也可以查看这个很酷的演示:https://twitter.com/ggerganov/status/1640022482307502085

4. “在机器学习中的1小时就像其他技术领域的7年”这一说法变得越来越真实了。

结论:在机器学习世界中成为优秀的软件工程师变得越来越重要了。

5. 我一直认为在机器学习中拥有良好的软件工程背景是一个了不起的起点(对我来说似乎很明显)- 现在比以往任何时候都更为真实。在未来的一段时间里,主要推动创新的将是建造者,而不是机器学习科学家。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง