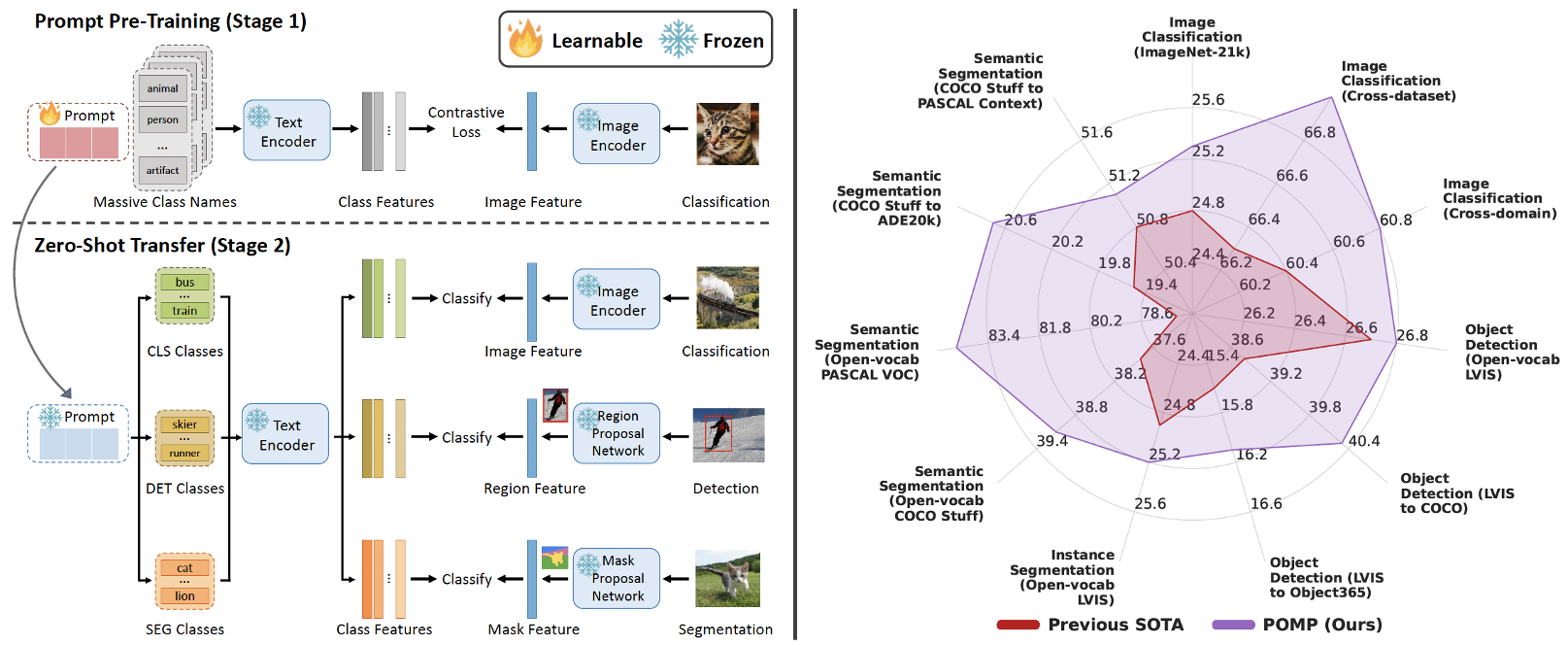

这项工作提出了POMP,一种用于视觉语言模型的提示预训练方法。POMP具有内存和计算效率,可以使学习到的提示压缩具有超过两万个类别的丰富视觉概念的语义信息。一旦预先训练完成,具有强可转移能力的提示可以直接插入各种视觉识别任务,包括图像分类、语义分割和目标检测,以增强零样本方式下的识别性能。经验评估表明,POMP在21个下游数据集上实现了最先进的性能,例如在10个分类数据集上的平均准确性为67.0%(与CoOp相比增加了3.1%),在开放词汇Pascal VOC分割上的84.4 hIoU(与ZSSeg相比增加了6.9)。

总结:

本文介绍了一种使用2万个类别的PROMPT预训练的方法,用于开放词汇量的视觉识别。该方法使用PROMPT生成器作为模型输入,可以为训练数据中的每个类别生成一个针对性的提示,以提高模型的泛化能力。实验结果表明,在几种不同的视觉识别任务中,该方法都能够取得优于现有方法的性能,并且对于具备大规模类别的任务来说,该方法效果更为显著。该方法为视觉识别领域的开放词汇量问题提供了新的解决思路。

标题:Prompt Pre-Training with Over Twenty-Thousand Classes for Open-Vocabulary Visual Recognition

作者:Shuhuai Ren, Aston Zhang, Yi Zhu, Shuai Zhang, Shuai Zheng, Mu Li, Alex Smola, Xu Sun

代码:https://github.com/amazon-science/prompt-pretraining

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง