【推荐理由】本文展示了一种提示系统,它能够为冻结的LLM(GPT-3、GPT-3.5和GPT-4)模型提供带有不确定性的上下文学习回归,允许预测而无需特征或架构调整。 虽然该方法未能超越所有基线,但它不需要任何训练、特征选择和额外的计算,同时保持了令人满意的性能。

Bayesian Optimization of Catalysts With In-context Learning

Mayk Caldas Ramos, Shane S. Michtavy, Marc D. Porosoff, Andrew D. White

[University of Rochester]

【论文链接】https://arxiv.org/pdf/2304.05341.pdf

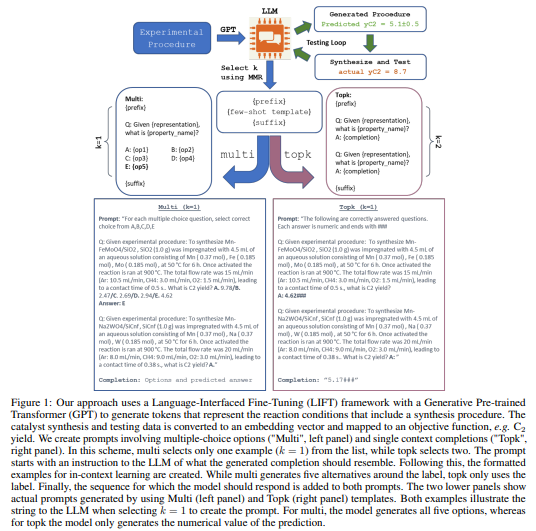

【项目链接】https://github.com/ur-whitelab/BO-LIFT

【摘要】大型语言模型(LLMs)能够使用零个或仅有少量的示例进行准确分类(即上下文学习)。文章展示了一个提示系统,它能够在使用冻结的LLM(如GPT-3、GPT-3.5和GPT-4)模型时实现具有不确定性的回归,从而允许进行无需特征或架构调整的预测。通过结合不确定性,该方法使得使用自然语言进行贝叶斯优化催化剂或分子的优化成为可能,消除了训练或模拟的需要。在这里,作者使用催化剂的合成过程来进行优化以预测其性质。使用自然语言工作可以缓解合成难度,因为字面合成过程是模型的输入。文章展示了,随着数据通过示例选择被收集,上下文学习可以超越模型上下文窗口(最多可以一次处理的标记数),从而使模型扩展得更好。虽然该方法并没有胜过所有基线,但它不需要任何训练、特征选择和最小计算,同时保持了令人满意的性能。文章还发现,对于文本嵌入,高斯过程回归在贝叶斯优化中表现良好。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง