标题:RRHF: Rank Responses to Align Language Models with Human Feedback without tears

作者:Zheng Yuan, Hongyi Yuan, Chuanqi Tan, Wei Wang, Songfang Huang, Fei Huang

[Alibaba DAMO Academy & Tsinghua University]

简介:

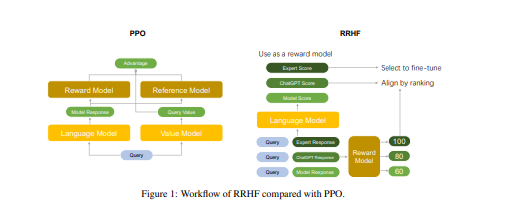

人类反馈强化学习 (RLHF) 促进了大型语言模型与人类偏好的对齐,显着提高了人类与这些模型之间的交互质量。InstructGPT 通过几个阶段实现 RLHF,包括监督微调 (SFT)、奖励模型训练和近端策略优化 (PPO)。然而,PPO 对超参数很敏感,并且在其标准实现中至少需要四个模型,这使得它很难训练。

相比之下,我们提出了一种称为 RRHF 的新型学习范式,它对不同采样策略生成的响应进行评分,并通过排名损失学习使它们与人类偏好保持一致。RRHF 可以像微调一样有效地将语言模型输出概率与人类偏好对齐,并且在调优期间只需要 1 到 2 个模型。此外,RRHF 可以被认为是 SFT 和奖励模型的扩展,同时在编码、模型计数和超参数方面比 PPO 更简单。整个对齐过程可以在一次 RRHF 培训课程中完成。我们使用 LLaMA 和 Alpaca 在有用和无害的数据上评估 RRHF,展示了与 PPO 相当的性能。

https://arxiv.org/pdf/2304.05302.pdf