【推荐理由】本文提出了SELFormer,这是一种基于Transformer架构的化学语言模型,SELFormer在两百万种药物样品上进行了预训练,为设计和发现具有所需特征的新型药物候选物开辟了新的可能性。

SELFormer: Molecular Representation Learning via SELFIES Language Models

Atakan Yüksel, Erva Ulusoy, Atabey Ünlü, Gamze Deniz, Tunca Doğan

[Hacettepe University]

【论文链接】https://arxiv.org/pdf/2304.04662.pdf

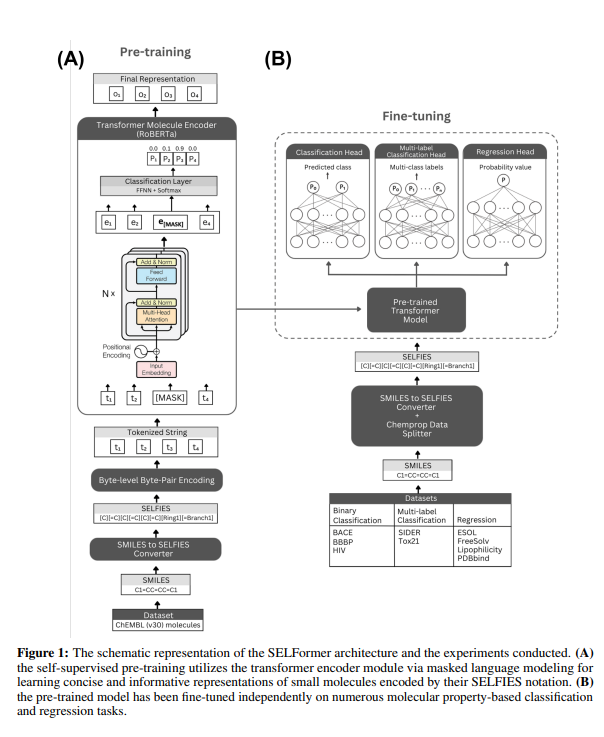

【摘要】自动计算化学空间的方法对于药物发现和材料科学等许多领域的研究至关重要。最近,利用表示学习技术生成复杂数据的紧凑且信息丰富的数值表达式已成为一种主要方法。一种有效学习分子表示的方法是通过自然语言处理(NLP)算法处理化学品的基于字符串的表述。目前,大多数方法都利用SMILES表述来实现;然而,SMILES存在许多与有效性和稳健性相关的问题,这可能会阻止模型有效地揭示数据中隐藏的知识。本研究提出了SELFormer,一种基于Transformer架构的化学语言模型,它将100%有效、紧凑且表达力强的SELFIES表述作为输入,学习灵活且高质量的分子表示。SELFormer在200万种药物样品上进行了预训练,并进行了各种分子属性预测任务的微调。我们的性能评估表明,SELFormer在预测分子的水溶性和不良药物反应方面优于所有竞争方法,包括基于图形学习的方法和基于SMILES的化学语言模型。作者还通过降维可视化了SELFormer学习到的分子表示,结果表明即使是预训练模型也可以区分具有不同结构特征的分子。文章将SELFormer作为一个编程工具,共享其数据集和预训练模型。总体而言,我们的研究表明,在化学语言建模的背景下使用SELFIES表述的好处,并为设计和发现具有所需特征的新药物候选物开辟了新的可能性。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง