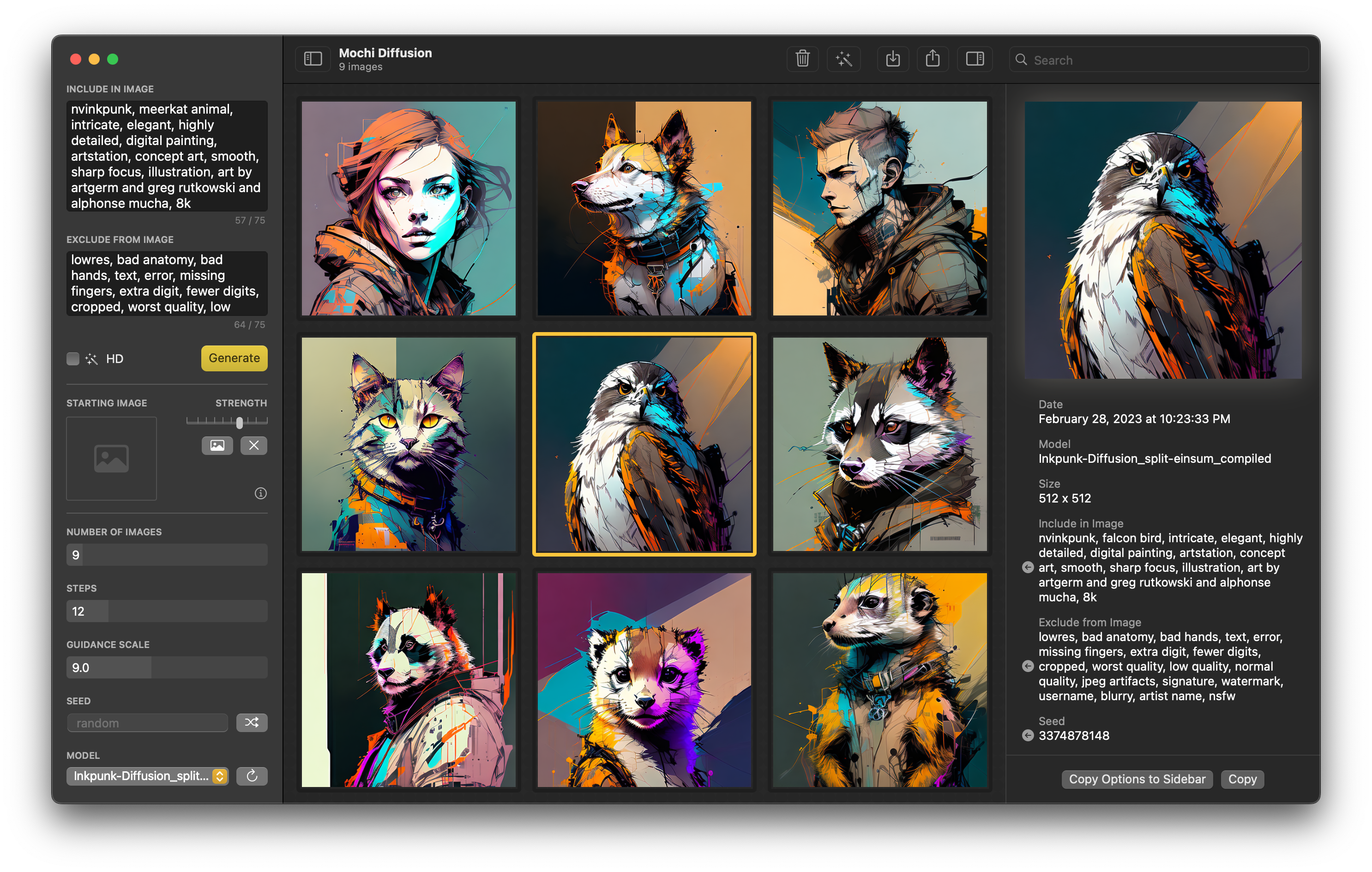

Mochi Diffusion 可在 Mac 上原生运行 Stable Diffusion,本应用内置 Apple 的 Core ML Stable Diffusion 框架 ,以实现在搭载 Apple 芯片的 Mac 上用极低的内存占用发挥出最优性能。

功能

- 极致性能和极低内存占用 (使用神经网络引擎时 ~150MB)

- 在所有搭载 Apple 芯片的 Mac 上充分发挥神经网络引擎的优势

- 生成图像时无需联网

- 图像转图像(也被称为 Image2Image)

- 在图像的 EXIF 信息中存储所有的关键词(在访达的“显示简介”窗口中查看)

- 使用 RealESRGAN 放大生成的图像

- 自动保存 & 恢复图像

- 自定义 Stable Diffusion Core ML 模型

- 无需担心损坏的模型

- 使用 macOS 原生框架 SwiftUI 开发

下载

在 发行 页面下载最新版本。

运行

在初次运行模型时, 神经网络引擎可能需要约2分钟编译缓存,后续运行速度会显著提高。

计算单元

CPU 和神经网络引擎能很好地平衡性能和内存占用CPU 和 GPU在 M1 Max/Ultra 及后续型号上可能更快,但会占用更多内存

你需要根据不同的计算单元选择对应的模型 (详情见模型部分)。

模型

需要自行转换或下载 Core ML 模型以使用 Mochi Diffusion。

这里上传了几个已经转换好的模型

- 转换 或下载 Core ML 模型

split_einsum版本适用于包括神经网络引擎在内的所有计算单元original版本仅适用于CPU 和 GPU

- 默认情况下,应用程序的模型文件夹将创建在您的主目录下。 可以在“设置”下自定义此位置

- 在模型文件夹中,你可以新建一个文件夹,用自己想在应用内显示的名字为其重命名,再将转换好的模型放到文件夹中

- 你的文件夹路径应该像这样:

<主目录>/

└── MochiDiffusion/

└── models/

├── stable-diffusion-2-1_split-einsum_compiled/

│ ├── merges.txt

│ ├── TextEncoder.mlmodelc

│ ├── Unet.mlmodelc

│ ├── VAEDecoder.mlmodelc

│ ├── VAEEncoder.mlmodelc

│ └── vocab.json

├── ...

└── ...

兼容性

- Apple 芯片的 Mac (M1 及后续)

- macOS Ventura 13.1 以上

- Xcode 14.2 (自行构建)

隐私

所有计算均在本地完成并绝对不会上传任何数据。

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง