标题:RECLIP: Resource-efficient CLIP by Training with Small Images

作者:Runze Li, Dahun Kim, Bir Bhanu, Weicheng Kuo

[University of California Riverside & Google Research, Brain Team]

简介:

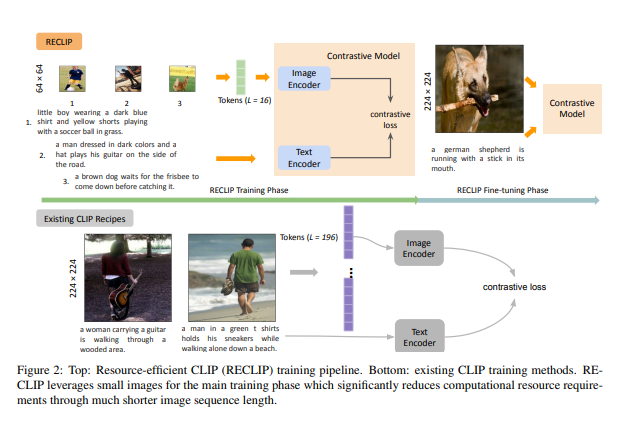

我们提出了RECLIP(资源效率型CLIP),这是一种简单的方法,可以将CLIP(对比性语言图像预训练)的计算资源占用降到最低。受计算机视觉中从粗到细的概念的启发,我们利用小图像来有效地学习大规模的语言监督,并在最后用高分辨率的数据来微调模型。

由于视觉变换器的复杂性在很大程度上取决于输入图像的大小,我们的方法在理论上和实践上都大大降低了训练资源的要求。使用相同的批次大小和训练历时,RECLIP以比基线少6到8倍的计算资源和7到9倍的FLOPs实现了极具竞争力的零点分类和图像文本检索精度。与最先进的对比学习方法相比,RECLIP展示了5-59美元/次的训练资源节省,同时保持了极具竞争力的零次分类和检索性能。我们希望这项工作能够为更广泛的研究界铺平道路,在更多资源友好的环境中探索语言监督预训练。

https://arxiv.org/pdf/2304.06028.pdf

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง