Segment Everything Everywhere All at Once

Xueyan Zou, Jianwei Yang, Hao Zhang, Feng Li, Linjie Li, Jianfeng Gao, Yong Jae Lee

一作威斯康星大学,微软研究实习生邹雪妍

二作微软研究院高级研究员杨建伟

https://arxiv.org/pdf/2304.06718.pdf

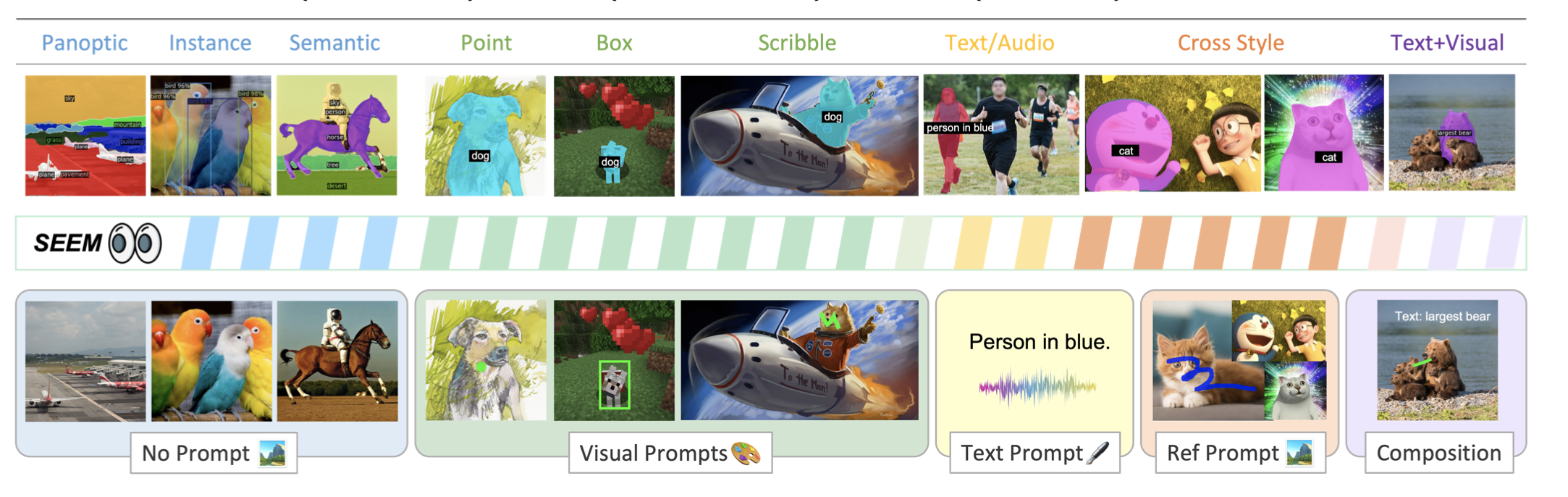

尽管对交互式人工智能系统的需求越来越大,但在视觉理解(如分割)方面,关于人与人工智能的交互的全面研究还很少。受为LLMs开发的基于提示的通用界面的启发,本文提出了SEEM,一个可提示的交互式模型,用于在图像中一次将所有东西都分割开来。

SEEM有四个目标:i)通用性:通过引入一个通用的提示引擎,用于不同类型的提示,包括点、框、涂鸦、面具、文本和另一个图像的参考区域;ii)组合性:通过学习视觉和文本提示的联合视觉-语义空间,在推理中快速组成查询,如图1所示;iii)互动性: iii)交互性:通过面具引导的交叉注意力,将可学习的记忆提示用于保留对话历史信息;以及iv)语义意识:通过使用文本编码器来编码文本查询和用于开放词汇分割的面具标签。

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง