DreamPose: Fashion Image-to-Video Synthesis via Stable Diffusion

Johanna Karras, Aleksander Holynski, Ting-Chun Wang, Ira Kemelmacher-Shlizerman

[University of Washington & UC Berkeley & NVIDIA]

DreamPose: 基于Stable Diffusion的时尚图像-视频合成

本文提出一种基于扩散的方法,使用姿态和图像引导合成具有人体和面料运动的时尚视频,称为DreamPose,并在时尚视频动画方面取得了最先进的结果。

要点:

- 动机:在给定人体姿态和服饰图像的情况下生成逼真的时尚视频,从而拓展时尚服装行业的创新和营销空间。

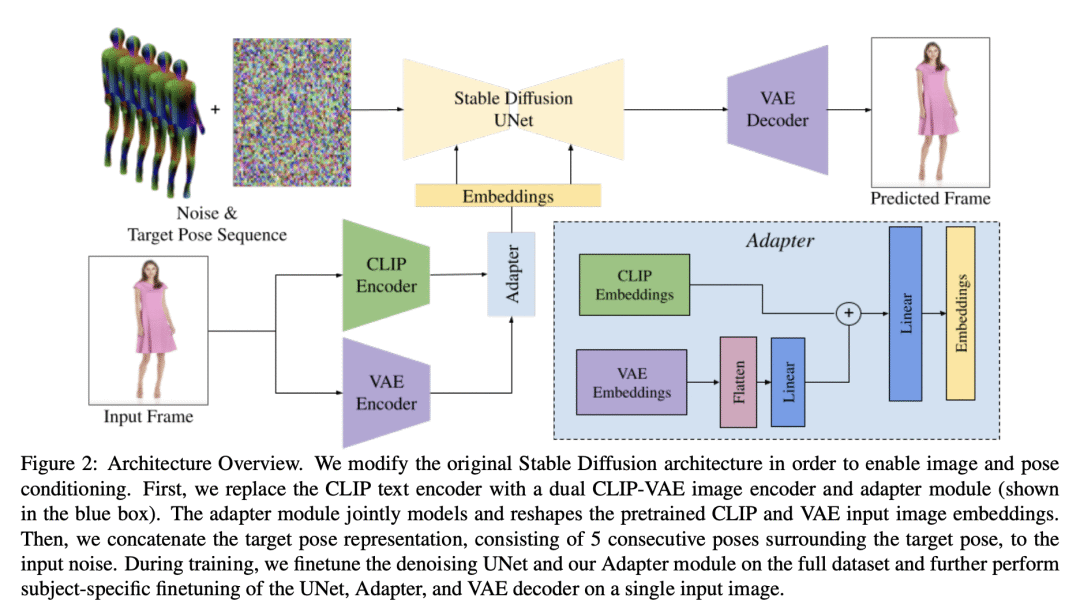

- 方法:提出一种基于扩散过程的方法DreamPose,通过将经过预训练的Stable Diffusion模型转化为姿态和图像引导的视频合成模型,用一种新的微调策略、一组支持增加调节信号的结构变化以及鼓励时序一致性的技术,可以生成同时包含人体和布料动作的视频。

- 优势:提出一种简单而有效的姿态调节方法,可以大大提高帧之间的时序一致性;还提出了一个分裂式CLIP-VAE编码器,可以提高对调节图像的输出保真度;以及一种微调策略,可以有效平衡图像保真度和对新姿态的泛化能力。所提出的 DreamPose 方法在时尚视频动画方面取得了最先进的结果。

- 结论:提出了一种新的基于扩散的方法 DreamPose,可以通过静态图像生成逼真的时尚视频,扩展了时尚服装行业的营销和创新空间。

https://arxiv.org/abs/2304.06025

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง