提出了一个名为AGIEval的基准测试,用于评估大型基础模型在人类认知水平任务上的表现。

AGIEval: A Human-Centric Benchmark for Evaluating Foundation Models

Wanjun Zhong, Ruixiang Cui, Yiduo Guo, Yaobo Liang, Shuai Lu, Yanlin Wang, Amin Saied, Weizhu Chen, Nan Duan

[Microsoft]

段楠博士,微软亚洲研究院首席研究员,自然语言计算团队研究经理,中国科学技术大学兼职博导,天津大学兼职教授,中国计算机协会(CCF)杰出会员,主要从事自然语言处理、代码智能、多模态智能、机器推理等研究,多次担任NLP/AI学术会议程序主席、评测主席、资深领域主席和领域主席,发表学术论文100余篇,持有专利20余项。

AGIEval: 以人为中心的基础模型评估基准

要点:

- 动机:评估大型基础模型在人类认知水平任务上的表现,以推动模型更接近人类认知,应用于更广泛的人类任务。

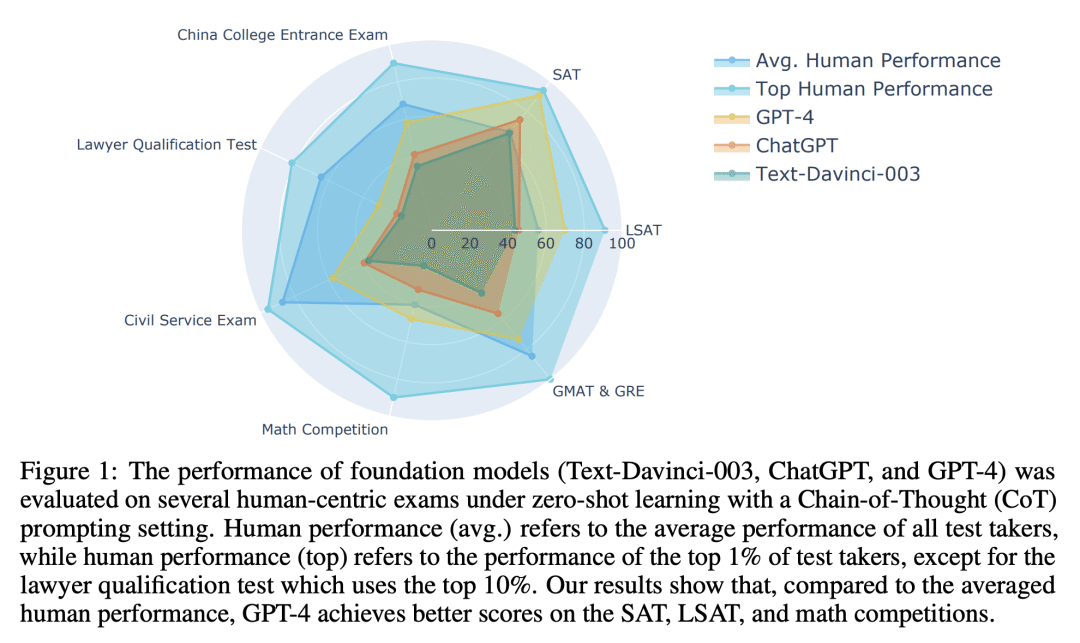

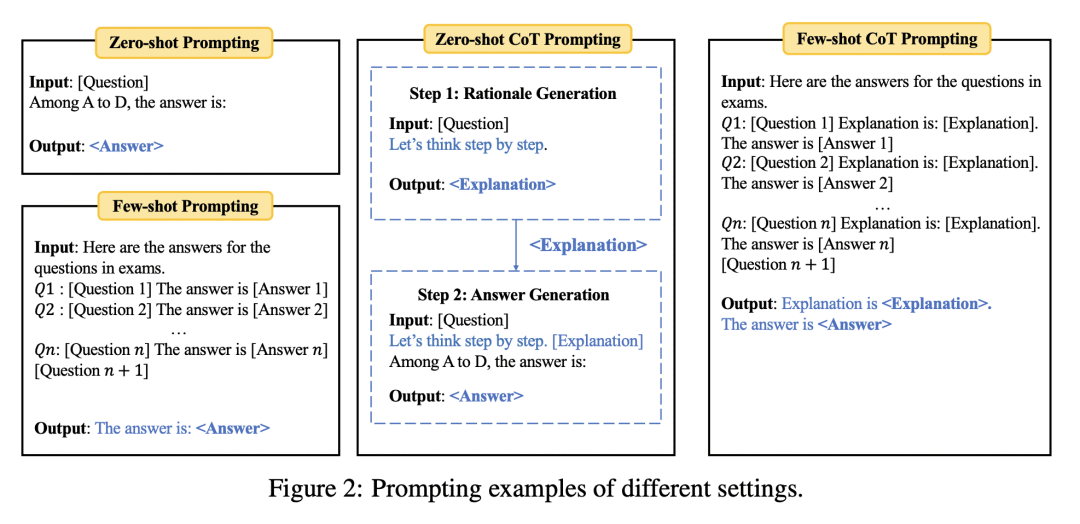

- 方法:引入AGIEval基准测试,评估大型基础模型在各类人类标准化考试的表现,包括SAT、LSAT、数学竞赛等。

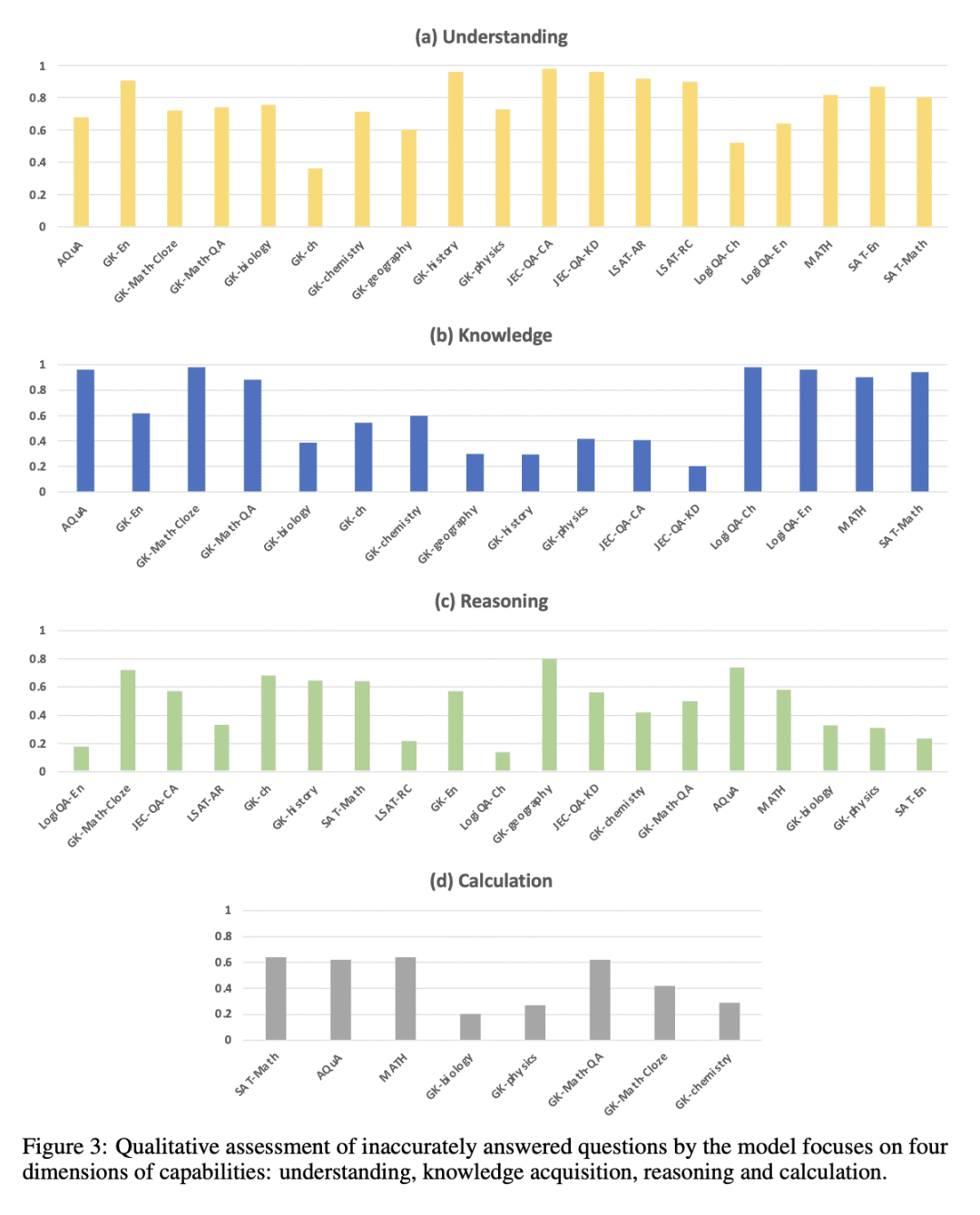

- 优势:通过人类标准化考试的评估,为大型基础模型的表现提供更有意义、更全面的评估方法。研究发现GPT-4在某些任务上超越了人类平均水平,展示出大型基础模型的强大性能。同时,研究人员分析了模型的能力,提出了未来研究方向。

结论:AGIEval基准测试可以评估大型基础模型在人类认知水平任务上的表现,GPT-4在某些任务上超越了人类平均水平。未来研究应该进一步探究如何使大型基础模型更接近人类认知。

https://arxiv.org/abs/2304.06364

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง