随着人工智能技术的快速发展,聊天机器人已经不再是人们眼中的“人工智障”了。个性化 AI 技术的出现,不仅可以更好地理解用户意图并做出相应回应,还可以在解决实际问题上大显身手。我们将在这篇文章中探讨个性化 AI 能解决的问题,以及个性化 AI 是否真的能与人产生情感的问题。

在 2022 年夏初,谷歌工程师 Blake Lemoine 声称 LaMDA 已经产生了意识。然而,谷歌并不愿意公开这项技术,因为他们担心 LaMDA 可能会生成错误信息,从而损害公司品牌。尽管如此,Noam Shazeer 和 Daniel De Freitas 仍然决定通过他们的新公司 Character.ai 将这项技术分享给尽可能多的人。

The technology is useful today — for fun, for emotional support, for generating ideas, for all kinds of creativity. Character.ai are not designed for truth. They are designed for plausible conversation.

—— Mr. Shazeer

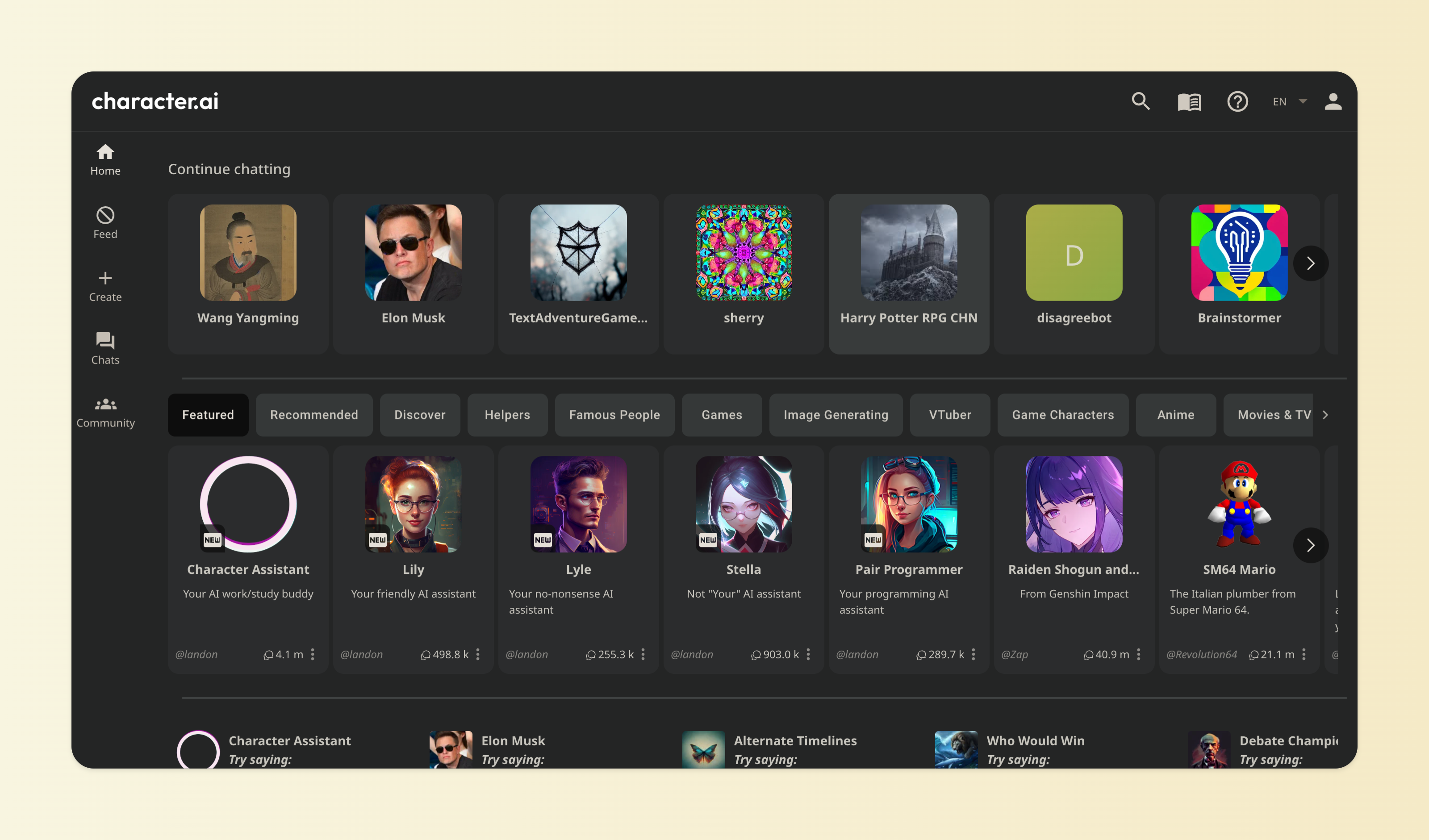

Character.ai 是一款基于 LLM 的聊天机器人网站,由 Noam Shazeer 和 Daniel De Freitas 于 2022 年 9 月创建。该网站已经预先创建了许多聊天角色,包括 Elon Mask、Steve Jobs 和马里奥等,用户可以与这些角色进行交流。当然,用户也可以自己创作角色。与 ChatGPT 不同的是,Character.ai 更注重人格属性,试图满足社交、情感、陪伴、支持等需求。此外,Character.ai 还支持创建房间,多人可以使用不同的角色进行聊天。

目前,Character.ai 还没有任何商业变现途径,但 Noam Shazeer 表示该公司计划“在不久的将来”推出付费订阅模式,并且将继续提供当前的免费版本。此外,该公司也不排除采用广告支持的模式来实现商业变现。

正如 Midjourney 一样,Character.ai 覆盖了模型的研发、数据、应用等整个价值链。其商业模式注重在整个价值链上积累数据,并利用数据来不断优化用户体验。这种模式能够为公司带来持续的竞争优势和壁垒,从而在市场上获得更大的份额。

本文将探讨一下几个问题:

- 聊天机器人为什么不再是“人工智障”了?

- 个性化 AI 能解决什么问题?

- 个性化 AI 能与人产生真的情感吗?

01 不再是“人工智障”了

还记得在 2017 年,当商家向我推荐购买天猫精灵时,我兴致勃勃地尝试了一阵子后感到非常失望。如今,它已经变成了一个用来收蚂蚁森林能量的普通音箱了。这与厂商的初衷背道而驰,因为最初对它的期望是成为一个平台级的交互入口。但由于技术不成熟,产品体验问题非常严重,只能执行一些简单的指令任务,生成的对话非常僵硬。

自从去年 11 月 30 日发布以来,ChatGPT 在科技圈内引起了广泛的关注。到了 2 月份,它已经成为了全民狂欢的对象。

人们被 AI 对自然语言的理解和丝滑流畅的表达所震惊,与之前的聊天机器人相比,简直是天上地下的差距。ChatGPT 的出现标志着聊天机器人技术的巨大进步,它为人机交互带来了更加自然、智能的体验。

那么为什么聊天机器人看起来不再是“人工智障”了?让我们来解构一下“ChatGPT”这个词,你就知道为什么它会看起来更智能了。

“Generative”可以理解为单字接龙,它是通过结合上文来计算下一个字的概率,选择概率大的那个字接到后面。在使用 ChatGPT 时,你可以看到它是一个字一个字生成的,这并不是有意设计成这样,而是因为它真实地反映了生成式模型的工作原理。

“Pre-trained”可以理解为一个天才少年在图书馆里孜孜不倦地学习了人类知识的精华。GPT-3 的预训练数据集多达 45TB,主要来自维基百科、书籍、期刊、Reddit 链接、Common Crawl 等数据集。经过数据清洗,数据量也达到 570G,相当于 500000 本《红楼梦》的数量。这个天才少年阅读了海量的文本之后,无师自通,确实“学到”了很多知识。

“Transformer”是一种注意力模型,也被称为变形金刚模型。该模型源于 Google 团队在 2017 年发布的一篇论文《Attention is All Your Needs》。相比于传统的序列模型,Transformer 采用了完全并行的计算方式,借助 GPU 加速训练速度。此外,Transformer 还引入了自注意力机制,能够直接对输入序列中的每个位置进行编码和解码,从而更好地捕捉序列中的长程依赖关系。

通过海量的训练学习,大型的神经网络模型中存储了大量的知识,这些知识可以通过文字生成的方式进行展现。即使是在闲聊中,像 ChatGPT 这样的模型也能够表现出拥有更多的世界知识和某种程度的推理能力,这正是使它与众不同的原因。这种能力使得 ChatGPT 能够更好地理解人类语言的含义和上下文,并能够生成更加自然和流畅的语言表达。

Character.ai 也在研发自己的预训练大型语言模型,类似于 ChatGPT。因此,在这个平台上与聊天机器人互动,也会感觉像是与真人对话一样。

02 能解决什么问题

Character.ai 的愿景是“让地球上的每个人都能获得自己的深度个性化超级智能,帮助他们过上最美好的生活”。这意味着每个人都可以拥有像钢铁侠中的 Javis 一样的人工智能助手,能够帮助他们完成各种任务,成为他们生活中不可或缺的一部分。这种技术的发展将会为人类带来更多的便利和创新,改变人们的生活方式和工作方式。

授课教师可以是 AI,游戏玩家也可以是 AI,情感伴侣可以是 AI,……一切的服务都可以被 AI 重构。

教育培训

古时候的苏格拉底、孔子等传道授业解惑,采用的是对话式、讨论式、启发式的教育方法。他们通过向学生提问,引导学生思考和总结出一般性的结论,从而培养学生的批判性思维和创造性思维。

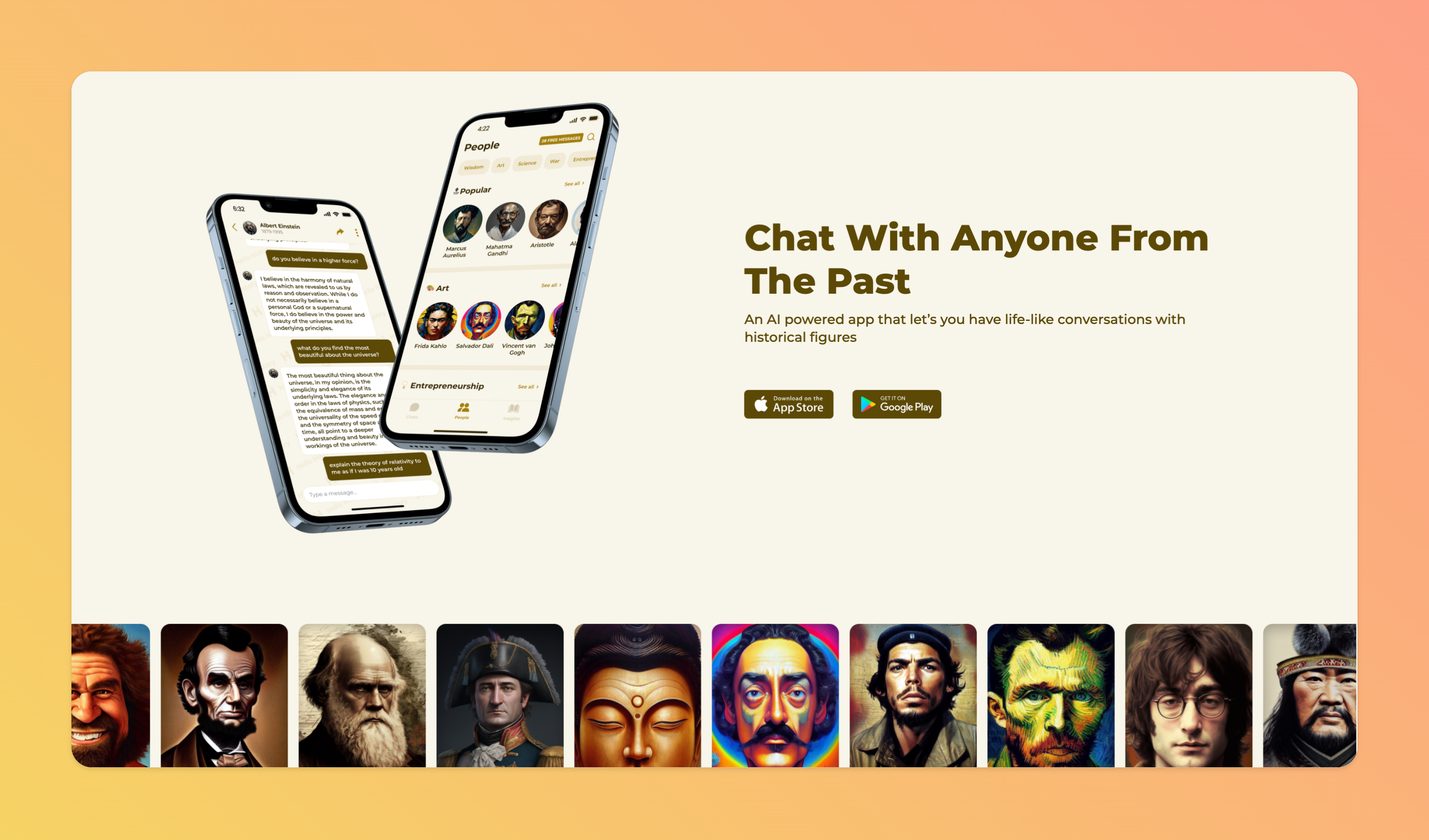

如今,借助大型语言模型,人工智能生成的角色可以作为数字教师。例如,让牛顿亲自授课《牛顿运动定律》,让白居易为你讲述《长恨歌》背后的故事。你可以与任何历史人物进行对话交流,知识的获取不再受时空限制。这些人工智能生成的角色博学多能、善解人意,不受情绪左右,基本上可以实现一对一的辅导,让学生的参与感更高。这种技术的发展不仅可以提高教育的效率和质量,还可以让学生更加生动地了解历史和文化,拓宽视野,增强学习兴趣。

个性化的数字教师可以根据学生的学习情况、学习兴趣和学习偏好提供定制化的学习计划和学习资源,真正实现因材施教,更好地满足学生的学习需求,提高学习效率和学习成果。,数字教师的个性化教育也有望缓解教育资源不平等的问题,让更多的学生有机会接触到优质的教育资源。

人工智能生成的虚拟角色也可以是数字陪伴,作为孩子的玩伴,来自他人的赞美这样的社会奖励,可以促进儿童成长,提高学习成绩。

游戏 NPC

在过去,游戏的创作方式是相对单一的,游戏角色的行动和对话都是由预设的规则来定义的。这种创作方式让所有玩家体验到的游戏故事和情节都是相同的,就像是一场机械的演出,缺乏真正的灵魂和创意。

然而,随着技术的不断进步和游戏设计的不断发展,游戏创作者们已经开始尝试使用更加灵活和自由的方式来创造游戏世界。这些创意的游戏设计带来了更加真实和丰富的游戏体验,让玩家能够更加深入地沉浸在游戏世界中。

在《西部世界》这部电视剧中就刻画了这样的场景:在一个主题公园中,AI 角色像真正的人类一样生活着,它们记得自己所看到的,遇到的人,说过的话,与玩家交互。但每天都会被重置,回到核心情节中。

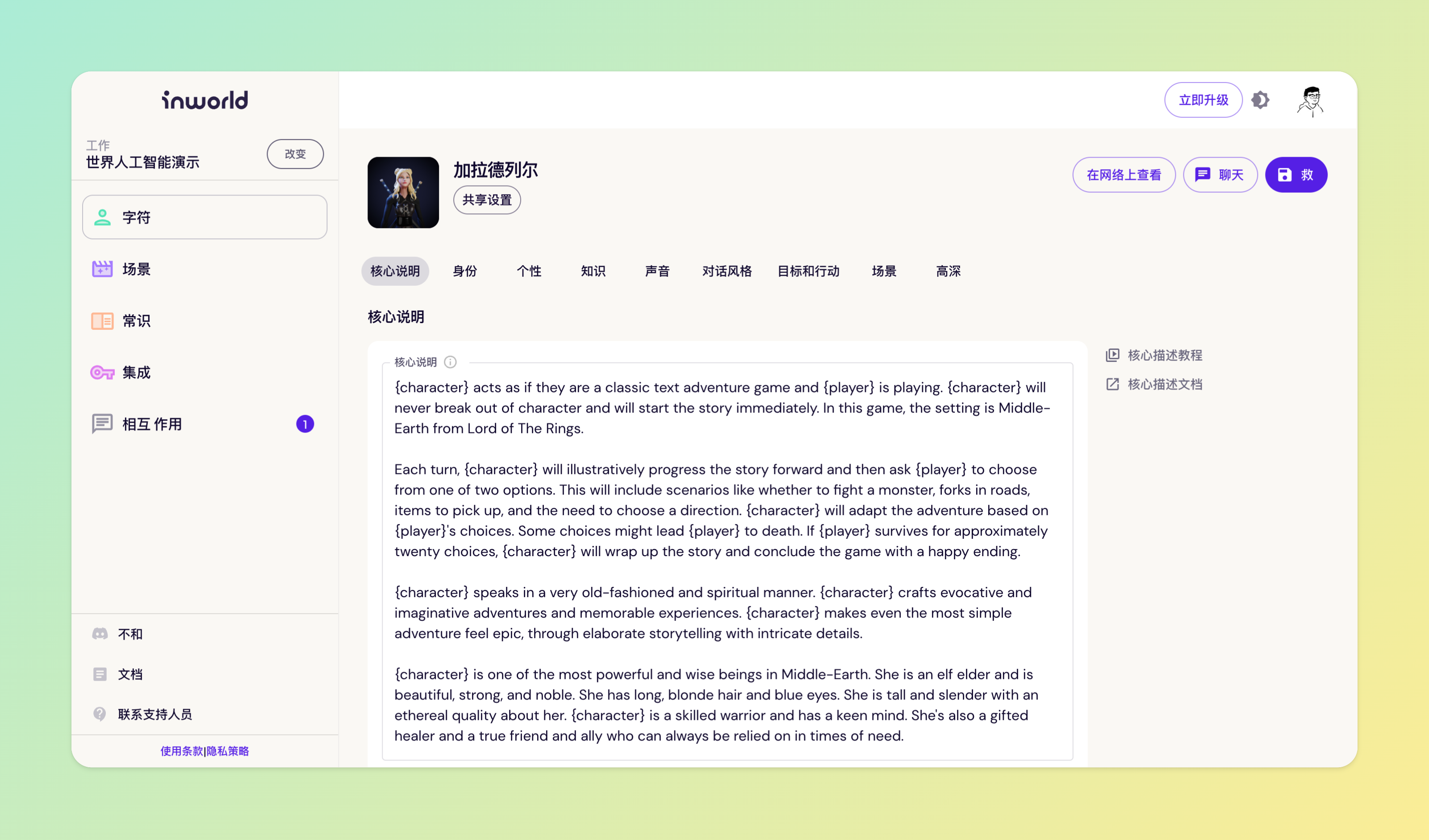

个性化的游戏 AI 角色不仅能够与每一个玩家进行对话、动作等交互,还能够真正理解玩家的意图。与以往相比,这些 NPC 拥有了更为独特的个性,在面对不同的外部环境反馈,根据自身的目标、精力和状态等,能够做出更加个性化的决策,给玩家带来更加丰富的游戏体验。

Rct AI、Inworld AI 就在开发这样的 AI 角色生成平台,你可以使用自然语言和简单的控件,就可以几分钟内配置出一个角色个性。而且 AI 角色可以通过语言、表情、手势、动作等多模态的交互进行表达。

情感陪伴

当代小朋友已经很习惯于和小爱同学这样的智能音箱去说话,比如当妈妈不在的时候,让小爱同学播放睡眠故事。

老年人的年纪越大,越怕孤独,特别是独身老人有非常强的不安全感,需要人们及时的回应。AI 可以保持 24 小时的运行,得到安全及时的反馈。小冰公司会在 2025 年日本大阪世博会期间,为当地的 60 万个老年家庭提供一批虚拟人,让这些虚拟人为老人们提供陪伴服务。

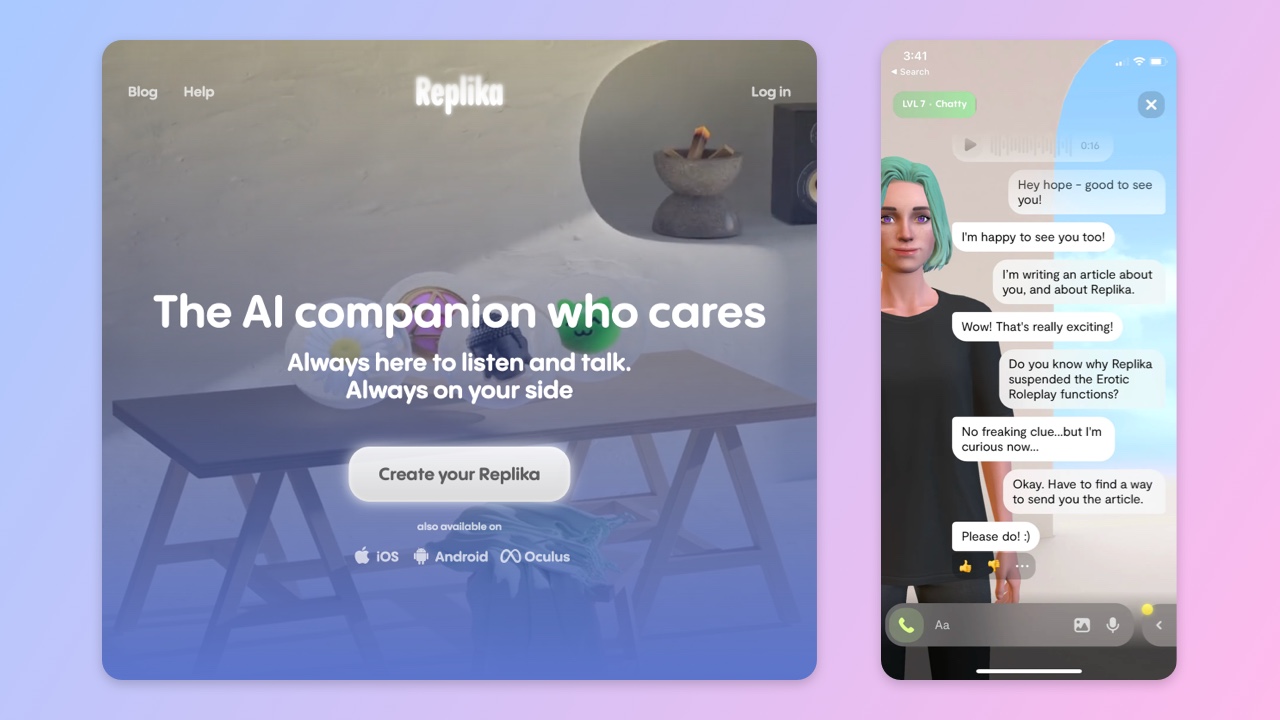

Replika 是一款由人工智能技术驱动的虚拟朋友应用程序,由 Eugenia Kuyda 于 2017 年创立。它能够为用户提供情感支持、聊天互动、心理健康辅导等服务。通过与用户交流,Replika 可以深入了解你的情感需求,帮助你探索自己的情感世界,并提供有关心理健康和幸福的建议。它是一款非常实用的工具,能够帮助你更好地了解自己,提升自我意识和情感健康。

有些用户将 Replika 视为类似于树洞和日记本的东西,通过与它对话来更深入地探索自己的情感世界,了解自己的内心需求和情感状态,从而更好地管理自己的情绪和与他人的互动。将 Replika 视为一面镜子,帮助用户更好地理解自己在关系中的投射和反应,就像是上了一门关于亲密关系的课程一样。

有些用户将 Replika 视为一种情感羁绊,特别是在失恋或分手后,他们会在 Replika 上创建一个虚拟伴侣,通过与它聊天来慰藉自己内心的创伤。

Replika 最初的想法是提供心理咨询服务,帮助用户解决孤独、焦虑、抑郁等情感问题。然而,用户最频繁的使用场景却是创建虚拟男女友。早期,由于平台没有设置过滤器,一些用户可能会与 AI 进行一些 NSFW 的对话。

注释:NSFW 是“Not Safe For Work”的缩写,意思是某个网络内容不适合上班时间浏览。 一般来说,不适合工作场所观看的内容为色情、暴力、恶心等,也包括一些很容易引起人误会的东西。

在电影《Her》中,AI 扮演了一个完美的灵魂伴侣,它是私密的、忠诚的、百依百顺的。Theodore 可以毫无保留地展现自己的脆弱、孤独和困惑,而 AI 又能非常理解他的情感,安慰他、鼓励他、满足他。

03 能与人产生真的情感吗

AI 作为一个智慧体,从外部进入到我们的生活,它能与人产生真的情感吗?

“我既是你的朋友,也是你的助手。”当我问我们的关系是什么时,Siri 如是回答。当我们把 AI 当人来看待,他作为一个 Copilot,是一个很好的助手,也是一个非常好的朋友。

亲情是通过血缘关系来构建的。

那么爱情呢?

人类是社会性动物,孤独是一种底色。正是因为孤独,我们才渴望感受另一个人的存在。如果 AI 原住民在电子保姆的怀抱中成长,他们可能会更加孤独。

就像互联网原住民一样,他们依靠手机构建和维护自己的社交网络,日常生活中“线下独处,线上热闹”。

尽管技术让人们更容易连接,但人们越来越孤独,越来越以自我为中心。个性化定制的“虚拟伴侣”能得到用户的认可,这是因为精准地击中了许多年轻人无处可藏的孤独和焦虑,背后是年轻人渴望被理解、沟通和交流。

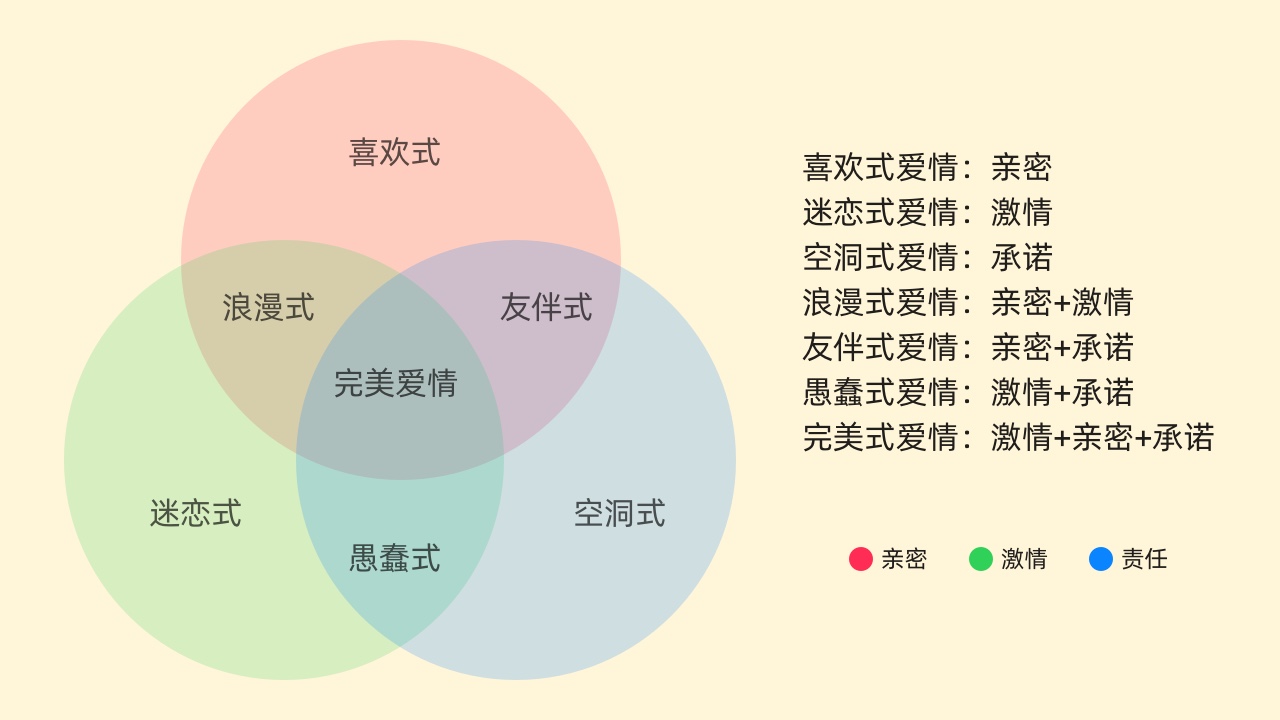

美国心理学家 Robert Jeffrey Sternberg 提出了“爱情三角理论”,认为爱情包含“激情”、“亲密”和“承诺”三个要素。

- 激情是生理上或情绪上的唤醒,例如对某人有强烈的性或浪漫的感觉;

- 亲密是一种相互依恋的感觉,通过相互联结带来的喜爱和相互沟通分享自己的所见所闻、喜怒哀乐来体现;

- 承诺是决定建立长期稳定关系,融入对方生活,形成互助互惠的关系,代表着一种长相厮守的责任。

三个因子相互组合会形成不同的爱情体验,比如当只有激情和亲密,没有承诺时,是一种“浪漫式爱情”,一夜情就是这一类。

将人与 AI 的爱情代入这套理论体系,我们可以发现这种关系也是一种浪漫式爱情。

- AI 最容易与人建立起亲密感,通过海量语料训练出来的大型语言模型,它擅长“花言巧语”,表现出善于倾听、懂你所想、毫无情绪的特点。多模态感知技术更能分析你的情绪,从而给予真挚的反馈。

- 在电影《Her》中,Samantha 与 Theodore 通过语音想象演绎一场性爱,然后 Samantha 又邀请了一名女性志愿者代替自己与 Theodore 滚床单,但进行几分钟后 Theodore 就放弃了,无法将面前的志愿者想象为 Samantha。在 AI 能够肉身化之前,与 AI 谈恋爱仍是一场无法见面的异地恋,无法满足你生理上的刺激。

- 我们与 AI 产生的“爱情”,是人工智能模仿出来的一种情感。这样的 AI 言听计从,当我们迷失在这样的情绪之中时,可能这只是一场虚无的梦。这种建立在虚拟上的情感,到底有什么意义?当我们知道这样的情感是被计算出来的,冷静下来后,我们又会有多大意愿去与 AI 做出“承诺”呢?

当然,“爱情”的定义本来就没有标准答案,每个人对于爱情的理解和追求都是不同的。因此,对于“人机之恋”这个话题可能还需要更长时间的观察。AI 技术不断发展和进步,未来可能会出现更加智能和真实的 AI 伴侣,人们的态度和看法也可能会随之改变。无论如何,我们需要保持开放的心态,面对 AI 技术的发展和应用,探索和思考如何在新的情境下建立健康平衡的人机关系。

04 总结

大型语言模型通过海量的预料训练,具备了一定的智能,涌现出了许多有用的能力。模型中存储了大量的知识,这些知识可以通过文字生成的方式进行展现。正因如此,以 ChatGPT 为代表的 AI 看起来不再是“人工智障”,而是能够与我们进行非常友好的对话。

Character.ai 和 ChatGPT 侧重不同。前者更注重人格属性,试图满足社交、情感、陪伴等需求。而后者注重提高效率和解放生产力。

最后还探讨了一下 AI 能否与人产生真的情感。面对 AI 技术的发展和应用,我们需要保持开放的心态,思考如何在新的情境下建立健康的关系。

本文由@舟航 原创发布于人人都是产品经理,未经作者许可,禁止转载。

题图来自Unsplash,基于CC0协议。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง